谷歌DeepMind最新發布的視訊轉音訊技術V2A,能夠根據視訊畫面和文字提示產生同步、逼真的音軌,為無聲視訊配樂。這項技術利用自回歸和擴散模型,結合AI生成的註釋,理解特定音頻事件與視覺場景的關聯,從而實現更精準、更具創造性的音頻生成。使用者可透過「正提示」和「負提示」控制音訊輸出,創造出符合影片內容和預期效果的音軌。 V2A不僅支援生成戲劇性配樂、逼真音效,還能產生與影片人物和基調相匹配的對話,為影片製作提供了強大的輔助工具。

谷歌deepmind發布了一項視訊轉音訊技術V2A,V2A 技術利用視訊像素和文字提示生成豐富的音軌,為無聲視訊製作配樂,實現同步視聽生成。

產品入口:https://top.aibase.com/tool/deepmind-v2a

使用者可以透過文字描述「正提示」 或「負提示」 來引導音訊輸出,實現對音軌創作的精確控制。 V2A 系統採用自回歸和擴散方法產生音頻,實現同步、逼真的音頻輸出。在訓練過程中,系統使用AI產生的註釋,幫助模型理解特定音訊事件與視覺場景的關聯。

運作原理:

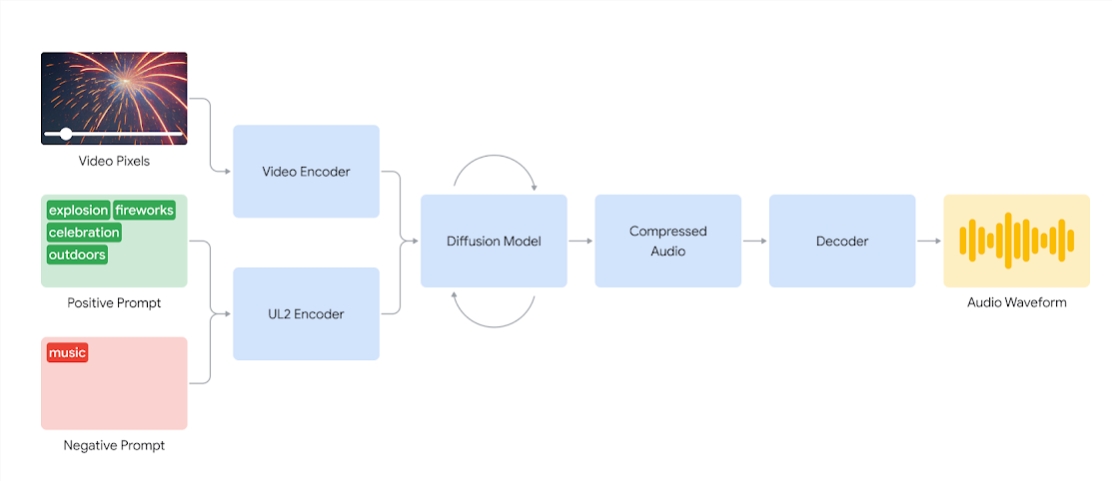

V2A 系統首先將視訊輸入編碼為壓縮表示。然後,擴散模型迭代地從隨機雜訊中提煉音訊。此過程由視覺輸入和給出的自然語言提示引導,以產生與提示緊密一致的同步、逼真的音訊。最後,音訊輸出被解碼,轉換為音訊波形並與視訊資料結合。

V2A 系統圖,採用視訊像素和音訊提示輸入產生與底層視訊同步的音訊波形。首先,V2A 對視訊和音訊提示輸入進行編碼,並透過擴散模型迭代運行。然後產生壓縮音頻,並將其解碼為音頻波形。

為了產生更高品質的音訊並增加引導模型生成特定聲音的能力,在訓練過程中添加了更多信息,包括帶有聲音詳細描述和口頭對話記錄的AI 生成的註釋。

透過對視訊、音訊和附加註釋進行訓練,該技術學會將特定的音訊事件與各種視覺場景聯繫起來,同時響應註釋或記錄中提供的資訊。

V2A功能特點:

音訊產生:V2A 根據視訊畫面和使用者提供的文字描述,自動產生同步的音軌,包括戲劇性配樂、逼真音效或與視訊人物和基調相匹配的對話的鏡頭。

同步音頻:採用自回歸和擴散方法生成音頻,確保生成的音頻與視頻內容完美同步,逼真的音頻輸出。

多樣化音軌:使用者可以產生無限數量的音軌,嘗試不同音效組合,找到最適合影片內容的聲音。

提示控制:使用者可以透過定義「正提示」 或「負提示」 來引導音軌生成,增加對輸出的控制,引導其遠離不需要的聲音。

訓練過程中使用註釋:在訓練過程中,系統使用AI 產生的註釋,幫助模型理解特定音訊事件與視覺場景的關聯。

為了提高音頻生成質量,研究團隊在訓練過程中引入了更多信息,如帶有聲音描述和口頭對話記錄的AI 生成的註釋。這樣的豐富資訊訓練使得技術能夠更好地理解視訊內容,並產生與視覺場景相符的音訊效果。

然而,目前仍存在一些挑戰,該團隊正在改進涉及語音的視訊的唇形同步。 V2A 嘗試根據輸入的轉錄文字產生語音,並將其與角色的唇形動作同步。但配對影片生成模型可能不以轉錄文字為條件。這會導致不匹配,通常會導致奇怪的唇形同步,因為視訊模型不會產生與轉錄文字相符的嘴部動作。

在向公眾開放之前, V2A 技術將接受嚴格的安全評估和測試。以下是V2A生成的一些配音配音案例:

1.音頻提示:狼對著月亮嚎叫

2.音頻提示:電影、驚悚片、恐怖片、音樂、緊張、氣氛、混凝土上的腳步聲

3.音頻提示:音樂會舞台上的鼓手被閃爍的燈光和歡呼的人群包圍

音頻提示:可愛的小恐龍鳴叫、叢林氛圍、雞蛋破裂

註:本文影片皆來自Google官方範例

總而言之,GoogleDeepMind的V2A技術為視訊內容創作帶來了新的可能性,其強大的音訊生成能力和便利的操作方式將大大提升視訊製作效率。雖然目前還存在一些挑戰需要克服,但V2A技術的未來發展前景值得期待。