V2A, la última tecnología de conversión de video a audio lanzada por Google DeepMind, puede generar pistas de audio sincronizadas y realistas basadas en imágenes de video e indicaciones de texto para poner banda sonora a videos silenciosos. Esta tecnología utiliza modelos autorregresivos y de difusión, combinados con anotaciones generadas por IA, para comprender la asociación entre eventos de audio específicos y escenas visuales, lo que permite una generación de audio más precisa y creativa. Los usuarios pueden controlar la salida de audio a través de "señales positivas" y "señales negativas" para crear pistas de audio que coincidan con el contenido del video y los efectos deseados. V2A no solo admite la generación de bandas sonoras dramáticas y efectos de sonido realistas, sino que también genera diálogos que coinciden con los personajes y el tono del video, proporcionando una poderosa herramienta auxiliar para la producción de videos.

Google DeepMind ha lanzado V2A, una tecnología de conversión de video a audio. La tecnología V2A utiliza píxeles de video e indicaciones de texto para generar pistas de audio enriquecidas, crear bandas sonoras para videos silenciosos y lograr una generación audiovisual sincrónica.

Entrada del producto: https://top.aibase.com/tool/deepmind-v2a

Los usuarios pueden guiar la salida de audio a través de descripciones de texto de "mensajes positivos" o "mensajes negativos" para lograr un control preciso sobre la creación de pistas de audio. El sistema V2A utiliza métodos autorregresivos y de difusión para generar audio, logrando una salida de audio realista y sincronizada. Durante el proceso de entrenamiento, el sistema utiliza anotaciones generadas por IA para ayudar al modelo a comprender cómo se relacionan eventos de audio específicos con la escena visual.

Cómo funciona:

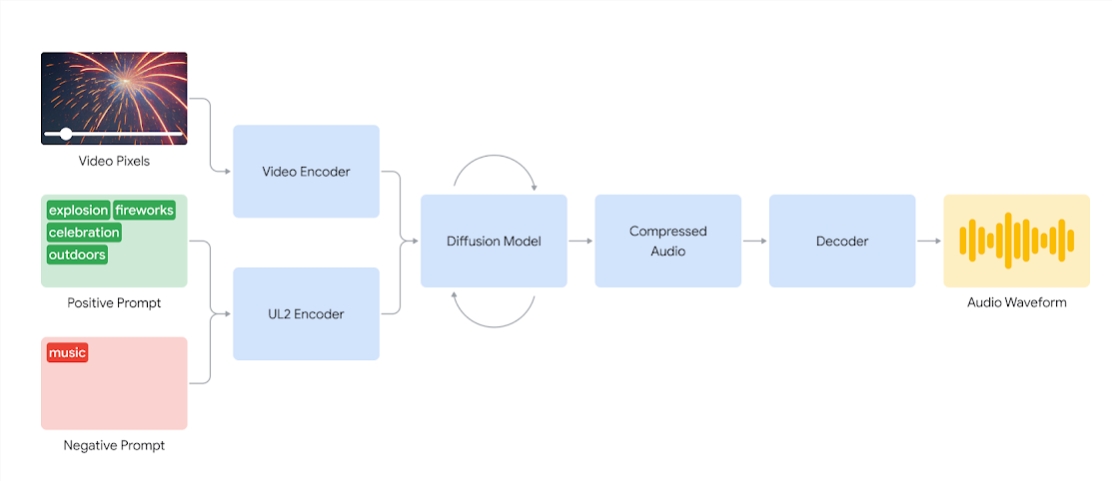

Los sistemas V2A primero codifican la entrada de vídeo en una representación comprimida. Luego, el modelo de difusión refina iterativamente el audio a partir del ruido aleatorio. Este proceso está guiado por información visual y señales de lenguaje natural dadas para producir un audio sincronizado y realista que se asemeja mucho a las señales. Finalmente, la salida de audio se decodifica, se convierte en una forma de onda de audio y se combina con los datos de video.

Diagrama de un sistema V2A que utiliza píxeles de vídeo y entradas de señales de audio para generar formas de onda de audio sincronizadas con el vídeo subyacente. En primer lugar, V2A codifica entradas de señales de vídeo y audio y se ejecuta de forma iterativa a través de un modelo de difusión. Luego, el audio comprimido se genera y se decodifica en una forma de onda de audio.

Para generar audio de mayor calidad y aumentar la capacidad de guiar el modelo para producir sonidos específicos, se agrega más información durante el proceso de capacitación, incluidas anotaciones generadas por IA con descripciones detalladas de sonidos y transcripciones de conversaciones habladas.

Al entrenarse con video, audio y anotaciones adjuntas, la tecnología aprende a asociar eventos de audio específicos con varias escenas visuales mientras responde a la información proporcionada en las anotaciones o grabaciones.

Características de V2A:

Generación de audio: V2A genera automáticamente pistas de audio sincronizadas basadas en secuencias de video y descripciones de texto proporcionadas por el usuario, incluidas tomas de bandas sonoras dramáticas, efectos de sonido realistas o diálogos que coinciden con los personajes y el tono del video.

Audio sincronizado: utilice métodos autorregresivos y de difusión para generar audio, asegurando que el audio generado esté perfectamente sincronizado con el contenido del video y proporcione una salida de audio realista.

Diversas pistas de audio: los usuarios pueden generar una cantidad ilimitada de pistas de audio, probar diferentes combinaciones de efectos de sonido y encontrar el sonido que mejor se adapte al contenido del video.

Control de señal: los usuarios pueden guiar la generación de pistas definiendo "cue positiva" o "cue negativa", agregando control sobre la salida y alejándola de sonidos no deseados.

Utilice anotaciones durante el entrenamiento: durante el proceso de entrenamiento, el sistema utiliza anotaciones generadas por IA para ayudar al modelo a comprender la asociación entre eventos de audio específicos y escenas visuales.

Para mejorar la calidad de la generación de audio, el equipo de investigación introdujo más información en el proceso de capacitación, como anotaciones generadas por IA con descripciones de sonido y grabaciones de diálogos hablados. Esta formación rica en información permite que la tecnología comprenda mejor el contenido de vídeo y produzca efectos de audio que coincidan con la escena visual.

Sin embargo, todavía existen algunos desafíos y el equipo está trabajando para mejorar la sincronización de labios en videos que involucran voz. V2A intenta generar voz basada en el texto transcrito ingresado y sincronizarlo con los movimientos de los labios del personaje. Pero los modelos de generación de vídeos emparejados no pueden estar condicionados al texto transcrito. Esto da como resultado discrepancias, que a menudo resultan en una extraña sincronización de labios, ya que el modelo de video no genera movimientos de la boca que coincidan con el texto transcrito.

La tecnología V2A se someterá a rigurosas evaluaciones y pruebas de seguridad antes de ponerse a disposición del público. Los siguientes son algunos casos de doblaje generados por V2A:

1. Mensaje de audio: El lobo aúlla a la luna.

2. Señales de audio: películas, novelas de suspense, películas de terror, música, tensión, atmósfera, pisadas sobre el cemento.

3. Señal de audio: baterista en el escenario del concierto rodeado de luces intermitentes y una multitud que lo vitoreaba.

Indicaciones de audio: lindos chirridos de dinosaurios, atmósfera selvática, cascar huevos

Nota: todos los vídeos de este artículo son de ejemplos oficiales de Google.

En definitiva, la tecnología V2A de Google DeepMind ofrece nuevas posibilidades para la creación de contenido de vídeo. Sus potentes capacidades de generación de audio y sus prácticos métodos de operación mejorarán enormemente la eficiencia de la producción de vídeo. Aunque todavía quedan algunos desafíos por superar, vale la pena mirar con ansias las perspectivas de desarrollo futuro de la tecnología V2A.