V2A, die neueste von Google DeepMind veröffentlichte Video-zu-Audio-Konvertierungstechnologie, kann synchronisierte und realistische Audiospuren basierend auf Videobildern und Textansagen generieren, um stumme Videos zu vertonen. Diese Technologie nutzt autoregressive und Diffusionsmodelle in Kombination mit KI-generierten Anmerkungen, um den Zusammenhang zwischen bestimmten Audioereignissen und visuellen Szenen zu verstehen und so eine genauere und kreativere Audioerzeugung zu ermöglichen. Benutzer können die Audioausgabe durch „positive Hinweise“ und „negative Hinweise“ steuern, um Audiospuren zu erstellen, die zum Videoinhalt und den beabsichtigten Effekten passen. V2A unterstützt nicht nur die Generierung dramatischer Soundtracks und realistischer Soundeffekte, sondern generiert auch Dialoge, die zu den Charakteren und dem Ton des Videos passen, und stellt so ein leistungsstarkes Hilfswerkzeug für die Videoproduktion dar.

Google DeepMind hat eine Video-zu-Audio-Technologie veröffentlicht, V2A. Die V2A-Technologie nutzt Videopixel und Textansagen, um reichhaltige Audiospuren zu generieren, Soundtracks für stumme Videos zu erstellen und eine synchrone audiovisuelle Erzeugung zu erreichen.

Produkteingang: https://top.aibase.com/tool/deepmind-v2a

Benutzer können die Audioausgabe durch Textbeschreibungen von „positiven Aufforderungen“ oder „negativen Aufforderungen“ steuern, um eine präzise Kontrolle über die Erstellung von Audiospuren zu erhalten. Das V2A-System verwendet autoregressive und Diffusionsmethoden zur Audioerzeugung und erreicht so eine synchronisierte, realistische Audioausgabe. Während des Trainingsprozesses verwendet das System KI-generierte Anmerkungen, um dem Modell zu helfen, zu verstehen, wie bestimmte Audioereignisse mit der visuellen Szene zusammenhängen.

So funktioniert es:

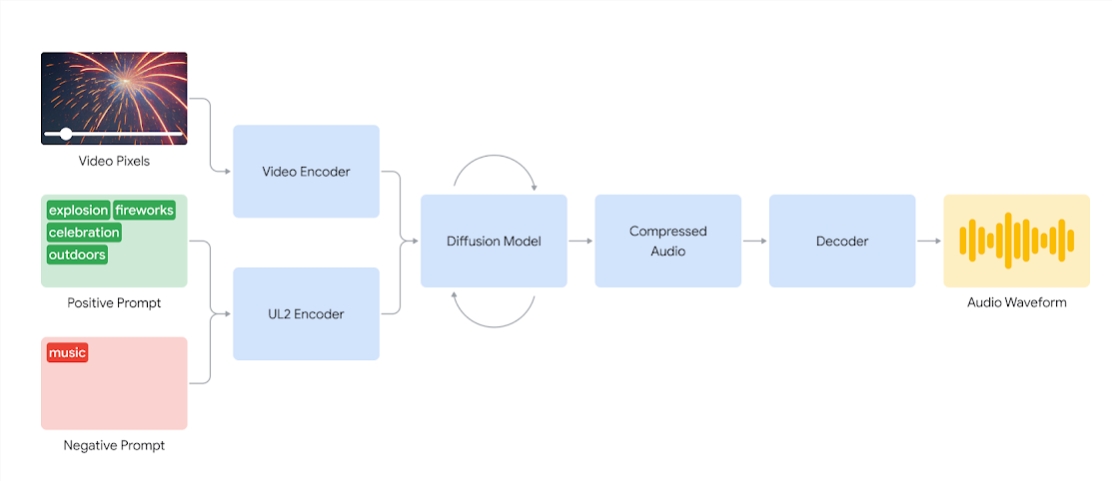

V2A-Systeme kodieren zunächst die Videoeingabe in eine komprimierte Darstellung. Das Diffusionsmodell verfeinert dann iterativ das Audiosignal aus dem zufälligen Rauschen. Dieser Prozess wird durch visuelle Eingaben und natürliche sprachliche Hinweise gesteuert, um synchronisierten, realistischen Ton zu erzeugen, der den Hinweisen genau entspricht. Abschließend wird die Audioausgabe dekodiert, in eine Audiowellenform umgewandelt und mit den Videodaten kombiniert.

Diagramm eines V2A-Systems, das Videopixel und Audio-Cue-Eingänge verwendet, um Audiowellenformen zu erzeugen, die mit dem zugrunde liegenden Video synchronisiert sind. Zunächst kodiert V2A Video- und Audio-Cue-Eingaben und durchläuft iterativ ein Diffusionsmodell. Anschließend wird komprimiertes Audio erzeugt und in eine Audiowellenform dekodiert.

Um eine höhere Audioqualität zu erzeugen und die Fähigkeit zu verbessern, das Modell bei der Erzeugung bestimmter Geräusche anzuleiten, werden während des Trainingsprozesses weitere Informationen hinzugefügt, darunter KI-generierte Anmerkungen mit detaillierten Beschreibungen von Geräuschen und Transkripten gesprochener Gespräche.

Durch Schulungen zu Video, Audio und angehängten Anmerkungen lernt die Technologie, bestimmte Audioereignisse mit verschiedenen visuellen Szenen zu verknüpfen und gleichzeitig auf die in den Anmerkungen oder Aufzeichnungen bereitgestellten Informationen zu reagieren.

V2A-Funktionen:

Audiogenerierung: V2A generiert automatisch synchronisierte Audiospuren basierend auf Videomaterial und vom Benutzer bereitgestellten Textbeschreibungen, einschließlich Aufnahmen dramatischer Soundtracks, realistischer Soundeffekte oder Dialoge, die zu den Charakteren und dem Ton des Videos passen.

Synchronisiertes Audio: Verwenden Sie autoregressive und Diffusionsmethoden zur Audiogenerierung, um sicherzustellen, dass das generierte Audio perfekt mit dem Videoinhalt synchronisiert ist und eine realistische Audioausgabe bietet.

Verschiedene Audiospuren: Benutzer können eine unbegrenzte Anzahl von Audiospuren erstellen, verschiedene Soundeffektkombinationen ausprobieren und den Ton finden, der am besten zum Videoinhalt passt.

Cue-Steuerung: Benutzer können die Track-Generierung durch die Definition von „positivem Cue“ oder „negativem Cue“ steuern, so die Kontrolle über die Ausgabe hinzufügen und sie von unerwünschten Geräuschen fernhalten.

Anmerkungen während des Trainings verwenden: Während des Trainingsprozesses verwendet das System KI-generierte Anmerkungen, um dem Modell zu helfen, den Zusammenhang zwischen bestimmten Audioereignissen und visuellen Szenen zu verstehen.

Um die Qualität der Audioerzeugung zu verbessern, fügte das Forschungsteam mehr Informationen in den Trainingsprozess ein, beispielsweise KI-generierte Anmerkungen mit Klangbeschreibungen und gesprochene Dialogaufzeichnungen. Ein solches informationsreiches Training ermöglicht es der Technologie, Videoinhalte besser zu verstehen und Audioeffekte zu erzeugen, die zur visuellen Szene passen.

Es gibt jedoch noch einige Herausforderungen und das Team arbeitet daran, die Lippensynchronisation für Videos mit Sprache zu verbessern. V2A versucht, Sprache basierend auf eingegebenem transkribiertem Text zu generieren und diese mit den Lippenbewegungen der Figur zu synchronisieren. Allerdings sind gepaarte Videogenerierungsmodelle möglicherweise nicht auf transkribierten Text angewiesen. Dies führt zu Nichtübereinstimmungen, was häufig zu einer seltsamen Lippensynchronisation führt, da das Videomodell keine Mundbewegungen erzeugt, die mit dem transkribierten Text übereinstimmen.

Die V2A-Technologie wird einer strengen Sicherheitsbewertung und -prüfung unterzogen, bevor sie der Öffentlichkeit zugänglich gemacht wird. Im Folgenden sind einige von V2A generierte Synchronisierungsfälle aufgeführt:

1. Audio-Eingabeaufforderung: Der Wolf heult den Mond an

2. Audiohinweise: Filme, Thriller, Horrorfilme, Musik, Spannung, Atmosphäre, Schritte auf Beton

3. Audio-Cue: Schlagzeuger auf der Konzertbühne, umgeben von blinkenden Lichtern und jubelnder Menge

Audioansagen: süßes kleines Dinosauriergezwitscher, Dschungelatmosphäre, Eierknacken

Hinweis: Die Videos in diesem Artikel stammen alle aus offiziellen Google-Beispielen

Alles in allem eröffnet die V2A-Technologie von Google DeepMind neue Möglichkeiten bei der Erstellung von Videoinhalten. Ihre leistungsstarken Audiogenerierungsfunktionen und praktischen Bedienungsmethoden werden die Effizienz der Videoproduktion erheblich verbessern. Obwohl noch einige Herausforderungen zu bewältigen sind, lohnt es sich, auf die zukünftigen Entwicklungsaussichten der V2A-Technologie zu blicken.