Google DeepMind がリリースした最新のビデオからオーディオへの変換テクノロジーである V2A は、ビデオ画像とテキスト プロンプトに基づいて同期されたリアルなオーディオ トラックを生成し、サイレント ビデオのサウンドトラックを作成できます。このテクノロジーは、自己回帰モデルと拡散モデルを AI 生成の注釈と組み合わせて利用し、特定のオーディオ イベントとビジュアル シーンの関連性を理解し、より正確で創造的なオーディオ生成を可能にします。ユーザーは「ポジティブ キュー」と「ネガティブ キュー」を通じてオーディオ出力を制御し、ビデオ コンテンツや意図したエフェクトに一致するオーディオ トラックを作成できます。 V2A は、ドラマチックなサウンドトラックやリアルなサウンドエフェクトの生成をサポートするだけでなく、ビデオのキャラクターやトーンに合わせたダイアログを生成することもでき、ビデオ制作の強力な補助ツールを提供します。

Google DeepMind は、ビデオ - オーディオ テクノロジである V2A をリリースしました。V2A テクノロジは、ビデオ ピクセルとテキスト プロンプトを使用してリッチ オーディオ トラックを生成し、サイレント ビデオのサウンドトラックを作成し、オーディオとビジュアルの同期生成を実現します。

製品入口: https://top.aibase.com/tool/deepmind-v2a

ユーザーは、「ポジティブ プロンプト」または「ネガティブ プロンプト」のテキスト説明を通じてオーディオ出力をガイドし、オーディオ トラックの作成を正確に制御できます。 V2A システムは、自己回帰および拡散方式を使用してオーディオを生成し、同期されたリアルなオーディオ出力を実現します。トレーニング プロセス中に、システムは AI によって生成された注釈を使用して、モデルが特定のオーディオ イベントがビジュアル シーンにどのように関連しているかを理解できるようにします。

仕組み:

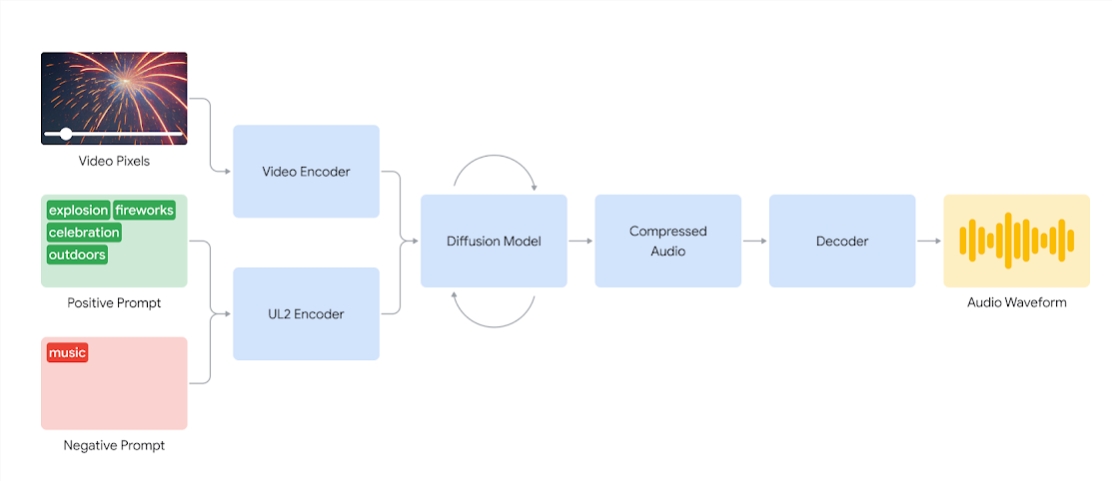

V2A システムは、まずビデオ入力を圧縮表現にエンコードします。次に、拡散モデルはランダム ノイズからオーディオを繰り返し調整します。このプロセスは、視覚的な入力と与えられた自然言語の手がかりによって導かれ、その手がかりに厳密に一致する同期されたリアルなオーディオを生成します。最後に、オーディオ出力がデコードされ、オーディオ波形に変換され、ビデオ データと結合されます。

ビデオ ピクセルとオーディオ キュー入力を使用して、基礎となるビデオと同期したオーディオ波形を生成する V2A システムの図。まず、V2A はビデオとオーディオのキュー入力をエンコードし、拡散モデルを通じて反復的に実行します。次に、圧縮オーディオが生成され、オーディオ波形にデコードされます。

高品質のオーディオを生成し、特定の音を生成するようにモデルをガイドする機能を高めるために、音の詳細な説明を含む AI 生成の注釈や会話のトランスクリプトなど、より多くの情報がトレーニング プロセス中に追加されます。

ビデオ、オーディオ、および添付された注釈をトレーニングすることにより、このテクノロジーは、注釈または録音で提供される情報に応答しながら、特定の音声イベントをさまざまな視覚的シーンに関連付けることを学習します。

V2A の機能:

オーディオ生成: V2A は、ビデオ映像と、ドラマチックなサウンドトラックのショット、リアルな音響効果、またはビデオのキャラクターやトーンと一致するダイアログなどのユーザー指定のテキスト説明に基づいて、同期されたオーディオ トラックを自動的に生成します。

同期されたオーディオ: 自己回帰および拡散方式を使用してオーディオを生成し、生成されたオーディオがビデオ コンテンツと完全に同期し、リアルなオーディオ出力を提供するようにします。

多様なオーディオ トラック: ユーザーは、無制限の数のオーディオ トラックを生成し、さまざまな効果音の組み合わせを試し、ビデオ コンテンツに最適なサウンドを見つけることができます。

キューコントロール: ユーザーは、「ポジティブキュー」または「ネガティブキュー」を定義することでトラック生成をガイドし、出力の制御を追加し、不要なサウンドから遠ざけることができます。

トレーニング中に注釈を使用する: トレーニング プロセス中に、システムは AI によって生成された注釈を使用して、モデルが特定のオーディオ イベントとビジュアル シーンの間の関連性を理解できるようにします。

音声生成の品質を向上させるために、研究チームは、音声の説明を含む AI 生成の注釈や会話の録音など、より多くの情報をトレーニング プロセスに導入しました。このような情報豊富なトレーニングにより、テクノロジーはビデオ コンテンツをより深く理解し、視覚的なシーンに一致するオーディオ効果を生成できるようになります。

ただし、まだいくつかの課題があり、チームは音声を含むビデオのリップシンクの改善に取り組んでいます。 V2A は、入力された文字起こしされたテキストに基づいて音声を生成し、それをキャラクターの唇の動きと同期させようとします。ただし、ペアビデオ生成モデルは、転写されたテキストを条件としない場合があります。これにより、ビデオ モデルが転写されたテキストと一致する口の動きを生成しないため、不一致が発生し、奇妙な口パクが発生することがよくあります。

V2A テクノロジーは、一般に公開される前に、厳格なセキュリティ評価とテストを受けます。 V2A によって生成されるダビング ケースのいくつかを次に示します。

1. 音声プロンプト: オオカミが月に向かって吠えます

2. 音声キュー: 映画、スリラー、ホラー映画、音楽、緊張感、雰囲気、コンクリートの足音

3. オーディオキュー: 点滅するライトと歓声を上げる群衆に囲まれたコンサートステージ上のドラマー

音声プロンプト: かわいい恐竜の鳴き声、ジャングルの雰囲気、卵を割る音

注: この記事のビデオはすべて Google 公式の例からのものです

全体として、Google DeepMind の V2A テクノロジーは、ビデオ コンテンツ作成に新たな可能性をもたらし、その強力なオーディオ生成機能と便利な操作方法により、ビデオ制作の効率が大幅に向上します。克服しなければならない課題はまだいくつかありますが、V2A テクノロジーの今後の発展の見通しに期待する価値があります。