V2A, новейшая технология преобразования видео в аудио, выпущенная Google DeepMind, может генерировать синхронизированные и реалистичные звуковые дорожки на основе видеоизображений и текстовых подсказок для звукового сопровождения немых видеороликов. Эта технология использует модели авторегрессии и диффузии в сочетании с аннотациями, созданными искусственным интеллектом, для понимания связи между конкретными аудиособытиями и визуальными сценами, что обеспечивает более точную и творческую генерацию звука. Пользователи могут управлять выводом звука с помощью «положительных сигналов» и «негативных сигналов», чтобы создавать звуковые дорожки, соответствующие видеоконтенту и предполагаемым эффектам. V2A не только поддерживает создание драматических саундтреков и реалистичных звуковых эффектов, но также генерирует диалоги, соответствующие персонажам и тону видео, предоставляя мощный вспомогательный инструмент для производства видео.

Google DeepMind выпустила технологию преобразования видео в аудио, V2A. Технология V2A использует видеопиксели и текстовые подсказки для создания насыщенных звуковых дорожек, создания саундтреков для немых видеороликов и достижения синхронной аудиовизуальной генерации.

Вход в продукт: https://top.aibase.com/tool/deepmind-v2a.

Пользователи могут управлять выводом звука с помощью текстовых описаний «положительных подсказок» или «отрицательных подсказок», чтобы обеспечить точный контроль над созданием звуковой дорожки. Система V2A использует методы авторегрессии и диффузии для генерации звука, обеспечивая синхронизированный и реалистичный вывод звука. В процессе обучения система использует аннотации, созданные искусственным интеллектом, чтобы помочь модели понять, как конкретные звуковые события связаны с визуальной сценой.

Как это работает:

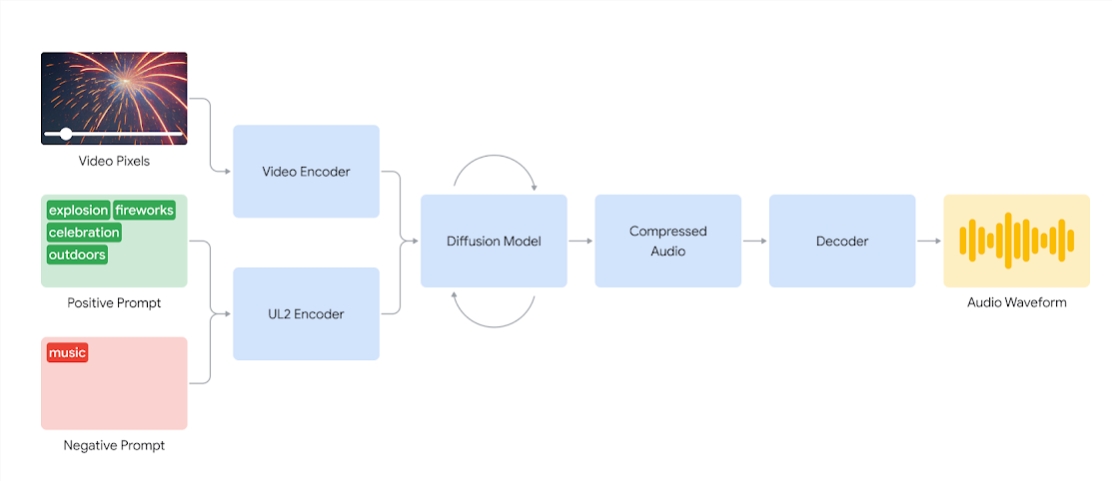

Системы V2A сначала кодируют входной видеосигнал в сжатое представление. Затем модель диффузии итеративно очищает звук от случайного шума. Этот процесс управляется визуальным вводом и подсказками на естественном языке для создания синхронизированного, реалистичного звука, который точно соответствует подсказкам. Наконец, аудиовыход декодируется, преобразуется в звуковой сигнал и объединяется с видеоданными.

Схема системы V2A, которая использует видеопиксели и входы аудиосигналов для генерации звуковых сигналов, синхронизированных с базовым видео. Во-первых, V2A кодирует входные видео- и аудиосигналы и итеративно выполняет модель диффузии. Затем сжатый звук генерируется и декодируется в звуковой сигнал.

Чтобы генерировать звук более высокого качества и расширять возможности управления моделью для воспроизведения определенных звуков, в процессе обучения добавляется дополнительная информация, включая созданные ИИ аннотации с подробным описанием звуков и расшифровки разговорных разговоров.

Обучая видео, аудио и прикрепленные аннотации, технология учится связывать определенные аудиособытия с различными визуальными сценами, реагируя на информацию, представленную в аннотациях или записях.

Возможности V2A:

Генерация звука: V2A автоматически генерирует синхронизированные звуковые дорожки на основе видеоматериалов и текстовых описаний, предоставленных пользователем, включая кадры драматических саундтреков, реалистичные звуковые эффекты или диалоги, соответствующие персонажам и тону видео.

Синхронизированный звук: используйте методы авторегрессии и диффузии для генерации звука, гарантируя, что сгенерированный звук идеально синхронизируется с видеоконтентом и обеспечивает реалистичный аудиовыход.

Разнообразные звуковые дорожки: пользователи могут создавать неограниченное количество звуковых дорожек, пробовать различные комбинации звуковых эффектов и находить звук, который лучше всего подходит к видеоконтенту.

Управление сигналом: пользователи могут управлять созданием треков, определяя «положительный сигнал» или «негативный сигнал», добавляя контроль над выходом и удаляя его из нежелательных звуков.

Используйте аннотации во время обучения. В процессе обучения система использует аннотации, созданные искусственным интеллектом, чтобы помочь модели понять связь между конкретными звуковыми событиями и визуальными сценами.

Чтобы улучшить качество генерации звука, исследовательская группа ввела в процесс обучения больше информации, например, созданные ИИ аннотации со звуковыми описаниями и записи разговорных диалогов. Такое насыщенное информацией обучение позволяет технологии лучше понимать видеоконтент и создавать звуковые эффекты, соответствующие визуальной сцене.

Тем не менее, некоторые проблемы все еще существуют, и команда работает над улучшением синхронизации губ для видео, включающих речь. V2A пытается генерировать речь на основе введенного расшифрованного текста и синхронизировать ее с движениями губ персонажа. Но модели генерации парного видео не могут быть обусловлены транскрибируемым текстом. Это приводит к несоответствиям, часто приводящим к странной синхронизации губ, поскольку видеомодель не генерирует движения рта, соответствующие расшифрованному тексту.

Технология V2A пройдет тщательную оценку и тестирование безопасности, прежде чем станет доступна общественности. Ниже приведены некоторые случаи дублирования, созданные с помощью V2A:

1. Аудиоподсказка: Волк воет на луну.

2. Звуковые сигналы: фильмы, триллеры, фильмы ужасов, музыка, напряжение, атмосфера, шаги по бетону.

3. Звуковая реплика: Барабанщик на концертной сцене в окружении мигающих огней и ликующей толпы.

Аудио-подсказки: милое щебетание маленького динозавра, атмосфера джунглей, разбивание яиц.

Примечание. Все видео в этой статье взяты из официальных примеров Google.

В целом, технология V2A от Google DeepMind открывает новые возможности для создания видеоконтента. Ее мощные возможности генерации звука и удобные методы работы значительно повысят эффективность производства видео. Хотя еще есть некоторые проблемы, которые необходимо преодолеть, перспективы развития технологии V2A заслуживают внимания.