V2A ซึ่งเป็นเทคโนโลยีการแปลงวิดีโอเป็นเสียงล่าสุดที่ออกโดย Google DeepMind สามารถสร้างแทร็กเสียงที่ซิงโครไนซ์และสมจริงตามภาพวิดีโอและข้อความแจ้งเพื่อประกอบวิดีโอเงียบ ๆ เทคโนโลยีนี้ใช้โมเดลการถดถอยอัตโนมัติและการแพร่กระจาย รวมกับคำอธิบายประกอบที่สร้างโดย AI เพื่อทำความเข้าใจความสัมพันธ์ระหว่างเหตุการณ์เสียงที่เฉพาะเจาะจงและฉากภาพ จึงทำให้การสร้างเสียงที่แม่นยำและสร้างสรรค์มากขึ้น ผู้ใช้สามารถควบคุมเอาต์พุตเสียงผ่าน "สัญญาณเชิงบวก" และ "สัญญาณเชิงลบ" เพื่อสร้างแทร็กเสียงที่ตรงกับเนื้อหาวิดีโอและเอฟเฟกต์ที่ต้องการ V2A ไม่เพียงแต่สนับสนุนการสร้างเพลงประกอบที่น่าทึ่งและเอฟเฟกต์เสียงที่สมจริง แต่ยังสร้างบทสนทนาที่เข้ากับตัวละครและโทนของวิดีโอด้วย ซึ่งเป็นเครื่องมือเสริมอันทรงพลังสำหรับการผลิตวิดีโอ

Google DeepMind ได้เปิดตัว V2A ซึ่งเป็นเทคโนโลยีการแปลงวิดีโอเป็นเสียง V2A ใช้พิกเซลวิดีโอและข้อความแจ้งเพื่อสร้างแทร็กเสียงที่สมบูรณ์ สร้างเพลงประกอบสำหรับวิดีโอเงียบ และบรรลุการสร้างภาพและเสียงแบบซิงโครนัส

ทางเข้าผลิตภัณฑ์: https://top.aibase.com/tool/deepmind-v2a

ผู้ใช้สามารถแนะนำเอาต์พุตเสียงผ่านคำอธิบายข้อความ "พร้อมท์เชิงบวก" หรือ "พร้อมท์เชิงลบ" เพื่อให้สามารถควบคุมการสร้างแทร็กเสียงได้อย่างแม่นยำ ระบบ V2A ใช้วิธีการถดถอยอัตโนมัติและการแพร่กระจายเพื่อสร้างเสียง เพื่อให้ได้เอาต์พุตเสียงที่ซิงโครไนซ์และสมจริง ในระหว่างกระบวนการฝึกอบรม ระบบจะใช้คำอธิบายประกอบที่สร้างโดย AI เพื่อช่วยให้โมเดลเข้าใจว่าเหตุการณ์เสียงที่เฉพาะเจาะจงเกี่ยวข้องกับฉากภาพอย่างไร

มันทำงานอย่างไร:

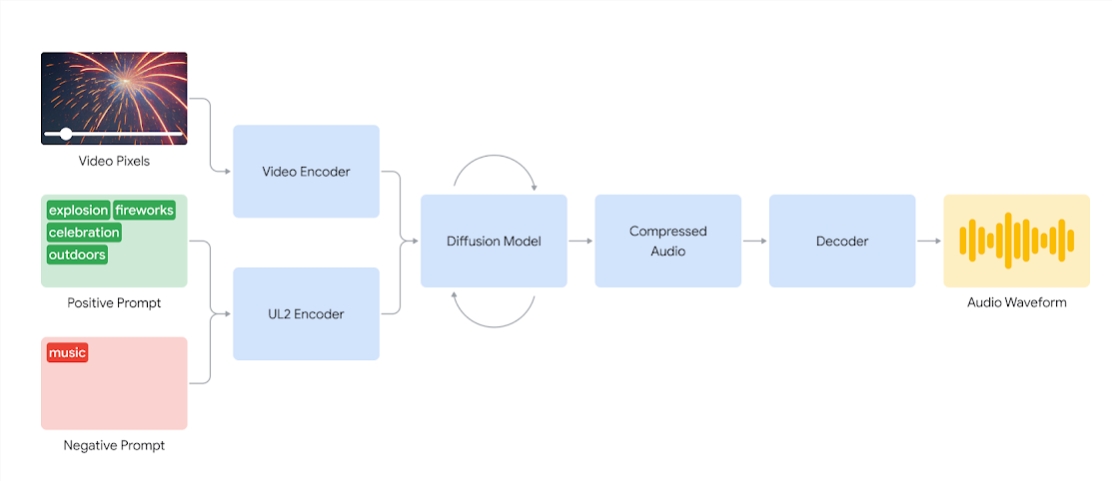

ขั้นแรกระบบ V2A จะเข้ารหัสอินพุตวิดีโอเป็นรูปแบบการบีบอัด จากนั้นแบบจำลองการแพร่กระจายจะปรับแต่งเสียงจากสัญญาณรบกวนแบบสุ่มซ้ำๆ กระบวนการนี้ได้รับการชี้นำโดยการป้อนข้อมูลด้วยภาพและสัญญาณภาษาที่เป็นธรรมชาติ เพื่อสร้างเสียงที่ซิงโครไนซ์และสมจริงซึ่งตรงกับสัญญาณต่างๆ อย่างใกล้ชิด ในที่สุด เอาต์พุตเสียงจะถูกถอดรหัส แปลงเป็นรูปแบบคลื่นเสียง และรวมกับข้อมูลวิดีโอ

ไดอะแกรมของระบบ V2A ที่ใช้พิกเซลวิดีโอและอินพุตคิวเสียงเพื่อสร้างรูปคลื่นเสียงที่ซิงโครไนซ์กับวิดีโอที่เกี่ยวข้อง ขั้นแรก V2A จะเข้ารหัสอินพุตคิววิดีโอและเสียง และรันซ้ำๆ ผ่านโมเดลการแพร่กระจาย จากนั้นเสียงที่ถูกบีบอัดจะถูกสร้างขึ้นและถอดรหัสเป็นรูปแบบคลื่นเสียง

เพื่อสร้างเสียงคุณภาพสูงขึ้นและเพิ่มความสามารถในการนำทางโมเดลเพื่อสร้างเสียงที่เฉพาะเจาะจง จึงได้มีการเพิ่มข้อมูลเพิ่มเติมในระหว่างกระบวนการฝึกอบรม รวมถึงคำอธิบายประกอบที่สร้างโดย AI พร้อมคำอธิบายโดยละเอียดของเสียงและการถอดเสียงของการสนทนาที่เป็นคำพูด

ด้วยการฝึกอบรมเกี่ยวกับวิดีโอ เสียง และคำอธิบายประกอบที่แนบมา เทคโนโลยีจะเรียนรู้ที่จะเชื่อมโยงเหตุการณ์เสียงที่เฉพาะเจาะจงกับฉากภาพต่างๆ ในขณะที่ตอบสนองต่อข้อมูลที่ให้ไว้ในคำอธิบายประกอบหรือการบันทึก

คุณสมบัติ V2A:

การสร้างเสียง: V2A จะสร้างแทร็กเสียงที่ซิงโครไนซ์โดยอัตโนมัติตามฟุตเทจวิดีโอและคำอธิบายข้อความที่ผู้ใช้ให้ไว้ รวมถึงช็อตเพลงประกอบละคร เอฟเฟกต์เสียงสมจริง หรือบทสนทนาที่ตรงกับตัวละครและโทนของวิดีโอ

เสียงที่ซิงโครไนซ์: ใช้วิธีการถดถอยอัตโนมัติและการแพร่กระจายเพื่อสร้างเสียง รับรองว่าเสียงที่สร้างขึ้นจะซิงโครไนซ์กับเนื้อหาวิดีโออย่างสมบูรณ์แบบและให้เอาต์พุตเสียงที่สมจริง

แทร็กเสียงที่หลากหลาย: ผู้ใช้สามารถสร้างแทร็กเสียงได้ไม่จำกัดจำนวน ลองใช้เอฟเฟกต์เสียงที่แตกต่างกัน และค้นหาเสียงที่เหมาะกับเนื้อหาวิดีโอมากที่สุด

การควบคุมคิว: ผู้ใช้สามารถแนะนำการสร้างแทร็กโดยกำหนด "คิวเชิงบวก" หรือ "คิวเชิงลบ" เพิ่มการควบคุมเอาต์พุตและควบคุมทิศทางให้ห่างจากเสียงที่ไม่ต้องการ

ใช้คำอธิบายประกอบระหว่างการฝึก: ในระหว่างกระบวนการฝึกอบรม ระบบจะใช้คำอธิบายประกอบที่สร้างโดย AI เพื่อช่วยให้โมเดลเข้าใจความสัมพันธ์ระหว่างเหตุการณ์เสียงที่เฉพาะเจาะจงและฉากภาพ

เพื่อปรับปรุงคุณภาพของการสร้างเสียง ทีมวิจัยได้แนะนำข้อมูลเพิ่มเติมในกระบวนการฝึกอบรม เช่น คำอธิบายประกอบที่สร้างโดย AI พร้อมคำอธิบายเสียงและการบันทึกเสียงบทสนทนา การฝึกอบรมที่มีข้อมูลมากมายดังกล่าวช่วยให้เทคโนโลยีเข้าใจเนื้อหาวิดีโอได้ดีขึ้น และสร้างเอฟเฟกต์เสียงที่เข้ากับฉากภาพ

อย่างไรก็ตาม ยังมีความท้าทายอยู่บ้าง และทีมงานกำลังปรับปรุงลิปซิงค์สำหรับวิดีโอที่เกี่ยวข้องกับคำพูด V2A พยายามสร้างคำพูดโดยอิงตามข้อความที่ถอดเสียงและซิงโครไนซ์กับการเคลื่อนไหวของริมฝีปากของตัวละคร แต่โมเดลการสร้างวิดีโอที่จับคู่กันอาจไม่ถูกกำหนดเงื่อนไขบนข้อความที่ถอดเสียง ซึ่งส่งผลให้เกิดความไม่ตรงกัน ซึ่งมักส่งผลให้เกิดการลิปซิงค์ที่แปลกประหลาด เนื่องจากโมเดลวิดีโอไม่สร้างการเคลื่อนไหวของปากที่ตรงกับข้อความที่ถอดเสียง

เทคโนโลยี V2A จะได้รับการประเมินและทดสอบความปลอดภัยอย่างเข้มงวดก่อนที่จะเผยแพร่สู่สาธารณะ ต่อไปนี้เป็นกรณีพากย์บางกรณีที่สร้างโดย V2A:

1. เสียงเตือน: หมาป่าหอนที่ดวงจันทร์

2. สัญญาณเสียง: ภาพยนตร์ ระทึกขวัญ ภาพยนตร์สยองขวัญ ดนตรี ความตึงเครียด บรรยากาศ รอยเท้าบนพื้นคอนกรีต

3. Audio Cue: มือกลองบนเวทีคอนเสิร์ตที่รายล้อมไปด้วยแสงไฟและเสียงเชียร์จากฝูงชน

เสียงแจ้ง: เสียงร้องของไดโนเสาร์ตัวน้อยน่ารัก บรรยากาศในป่า ไข่แตก

หมายเหตุ: วิดีโอในบทความนี้ทั้งหมดมาจากตัวอย่างอย่างเป็นทางการของ Google

โดยรวมแล้ว เทคโนโลยี V2A ของ Google DeepMind นำเสนอความเป็นไปได้ใหม่ๆ ให้กับการสร้างเนื้อหาวิดีโอ ความสามารถในการสร้างเสียงอันทรงพลังและวิธีการใช้งานที่สะดวกสบายจะช่วยปรับปรุงประสิทธิภาพของการผลิตวิดีโอได้อย่างมาก แม้ว่ายังคงมีความท้าทายบางประการที่ต้องเอาชนะ แต่โอกาสในการพัฒนาเทคโนโลยี V2A ในอนาคตก็คุ้มค่าที่จะรอคอย