V2A, teknologi konversi video-ke-audio terbaru yang dirilis oleh Google DeepMind, dapat menghasilkan trek audio yang tersinkronisasi dan realistis berdasarkan gambar video dan perintah teks untuk membuat soundtrack video senyap. Teknologi ini menggunakan model autoregresif dan difusi, dikombinasikan dengan anotasi yang dihasilkan AI, untuk memahami hubungan antara peristiwa audio tertentu dan adegan visual, sehingga memungkinkan pembuatan audio yang lebih akurat dan kreatif. Pengguna dapat mengontrol keluaran audio melalui "isyarat positif" dan "isyarat negatif" untuk membuat trek audio yang sesuai dengan konten video dan efek yang diinginkan. V2A tidak hanya mendukung pembuatan soundtrack dramatis dan efek suara realistis, namun juga menghasilkan dialog yang sesuai dengan karakter dan nada video, menyediakan alat bantu yang kuat untuk produksi video.

Google DeepMind telah merilis teknologi video-ke-audio, V2A. Teknologi V2A menggunakan piksel video dan petunjuk teks untuk menghasilkan trek audio yang kaya, membuat soundtrack untuk video senyap, dan mencapai pembuatan audio-visual yang sinkron.

Pintu masuk produk: https://top.aibase.com/tool/deepmind-v2a

Pengguna dapat memandu keluaran audio melalui deskripsi teks "perintah positif" atau "perintah negatif" untuk mencapai kontrol yang tepat atas pembuatan trek audio. Sistem V2A menggunakan metode autoregresif dan difusi untuk menghasilkan audio, menghasilkan keluaran audio yang tersinkronisasi dan realistis. Selama proses pelatihan, sistem menggunakan anotasi yang dihasilkan AI untuk membantu model memahami bagaimana peristiwa audio tertentu berhubungan dengan adegan visual.

Cara kerjanya:

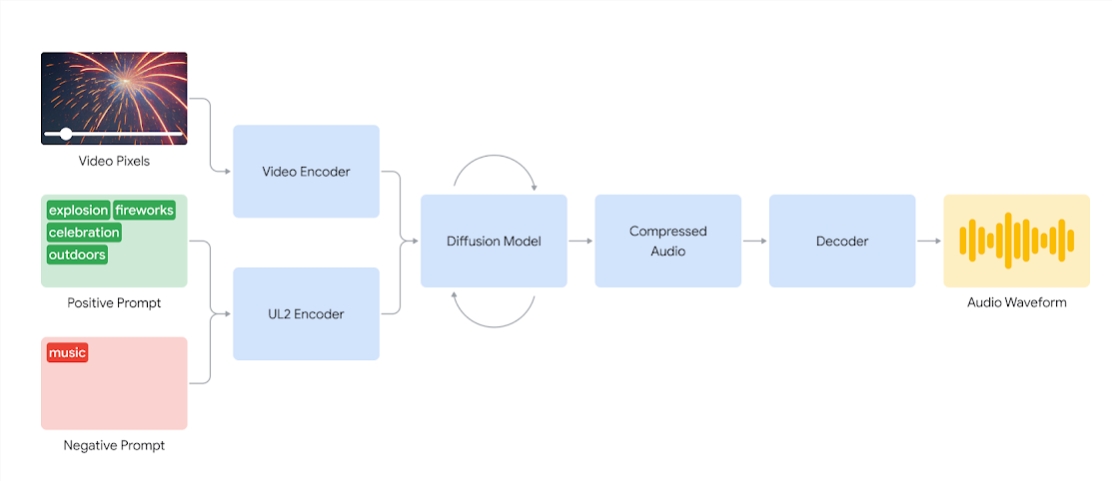

Sistem V2A pertama-tama mengkodekan input video ke dalam representasi terkompresi. Model difusi kemudian secara berulang memurnikan audio dari derau acak. Proses ini dipandu oleh masukan visual dan isyarat bahasa alami yang diberikan untuk menghasilkan audio yang tersinkronisasi dan realistis yang sangat cocok dengan isyarat tersebut. Terakhir, keluaran audio didekodekan, diubah menjadi bentuk gelombang audio dan digabungkan dengan data video.

Diagram sistem V2A yang menggunakan piksel video dan input isyarat audio untuk menghasilkan bentuk gelombang audio yang disinkronkan dengan video yang mendasarinya. Pertama, V2A mengkodekan input isyarat video dan audio dan dijalankan secara iteratif melalui model difusi. Audio terkompresi kemudian dihasilkan dan diterjemahkan menjadi bentuk gelombang audio.

Untuk menghasilkan audio berkualitas lebih tinggi dan meningkatkan kemampuan memandu model untuk menghasilkan suara tertentu, lebih banyak informasi ditambahkan selama proses pelatihan, termasuk anotasi yang dihasilkan AI dengan deskripsi mendetail tentang suara dan transkrip percakapan lisan.

Dengan melatih video, audio, dan anotasi terlampir, teknologi ini belajar mengaitkan peristiwa audio tertentu dengan berbagai adegan visual sambil merespons informasi yang diberikan dalam anotasi atau rekaman.

Fitur V2A:

Pembuatan audio: V2A secara otomatis menghasilkan trek audio yang disinkronkan berdasarkan rekaman video dan deskripsi teks yang disediakan pengguna, termasuk pengambilan soundtrack dramatis, efek suara realistis, atau dialog yang sesuai dengan karakter dan nada video.

Audio yang disinkronkan: Gunakan metode autoregresif dan difusi untuk menghasilkan audio, memastikan bahwa audio yang dihasilkan tersinkronisasi secara sempurna dengan konten video dan memberikan output audio yang realistis.

Beragam trek audio: Pengguna dapat menghasilkan trek audio dalam jumlah tak terbatas, mencoba berbagai kombinasi efek suara, dan menemukan suara yang paling sesuai dengan konten video.

Kontrol Isyarat: Pengguna dapat memandu pembuatan trek dengan menentukan "isyarat positif" atau "isyarat negatif", menambahkan kontrol atas keluaran dan menjauhkannya dari suara yang tidak diinginkan.

Gunakan anotasi selama pelatihan: Selama proses pelatihan, sistem menggunakan anotasi yang dihasilkan AI untuk membantu model memahami hubungan antara peristiwa audio tertentu dan adegan visual.

Untuk meningkatkan kualitas pembuatan audio, tim peneliti memperkenalkan lebih banyak informasi ke dalam proses pelatihan, seperti anotasi yang dihasilkan AI dengan deskripsi suara dan rekaman dialog lisan. Pelatihan kaya informasi tersebut memungkinkan teknologi untuk lebih memahami konten video dan menghasilkan efek audio yang sesuai dengan pemandangan visual.

Namun, masih ada beberapa tantangan, dan tim berupaya meningkatkan sinkronisasi bibir untuk video yang melibatkan ucapan. V2A mencoba menghasilkan ucapan berdasarkan masukan teks yang ditranskripsi dan menyinkronkannya dengan gerakan bibir karakter. Namun model pembuatan video berpasangan mungkin tidak dikondisikan pada teks yang ditranskripsi. Hal ini mengakibatkan ketidakcocokan, sering kali mengakibatkan sinkronisasi bibir yang aneh, karena model video tidak menghasilkan gerakan mulut yang sesuai dengan teks yang ditranskripsi.

Teknologi V2A akan menjalani evaluasi dan pengujian keamanan yang ketat sebelum tersedia untuk umum. Berikut ini adalah beberapa kasus dubbing yang dihasilkan oleh V2A:

1. Audio prompt: Serigala melolong di bulan

2. Isyarat audio: film, thriller, film horor, musik, ketegangan, suasana, langkah kaki di atas beton

3. Isyarat Audio: Drummer di panggung konser dikelilingi oleh lampu berkedip dan penonton bersorak

Petunjuk audio: kicau dinosaurus kecil yang lucu, suasana hutan, telur pecah

Catatan: Video dalam artikel ini semuanya berasal dari contoh resmi Google

Secara keseluruhan, teknologi V2A Google DeepMind menghadirkan kemungkinan baru dalam pembuatan konten video. Kemampuan menghasilkan audio yang kuat dan metode pengoperasian yang mudah akan sangat meningkatkan efisiensi produksi video. Meski masih ada beberapa tantangan yang perlu diatasi, prospek pengembangan teknologi V2A di masa depan patut dinantikan.