Google DeepMind가 출시한 최신 비디오-오디오 변환 기술인 V2A는 비디오 이미지와 텍스트 프롬프트를 기반으로 동기화되고 사실적인 오디오 트랙을 생성하여 무성 비디오를 사운드트랙할 수 있습니다. 이 기술은 AI 생성 주석과 결합된 자동 회귀 및 확산 모델을 활용하여 특정 오디오 이벤트와 시각적 장면 간의 연관성을 이해함으로써 보다 정확하고 창의적인 오디오 생성을 가능하게 합니다. 사용자는 "긍정적 신호"와 "부정적 신호"를 통해 오디오 출력을 제어하여 비디오 콘텐츠 및 의도한 효과와 일치하는 오디오 트랙을 만들 수 있습니다. V2A는 드라마틱한 사운드트랙과 사실적인 사운드 효과 생성을 지원할 뿐만 아니라, 영상의 성격과 톤에 어울리는 대사를 생성해 영상 제작을 위한 강력한 보조 도구를 제공합니다.

Google DeepMind는 비디오-오디오 기술인 V2A를 출시했습니다. V2A 기술은 비디오 픽셀과 텍스트 프롬프트를 사용하여 풍부한 오디오 트랙을 생성하고 무성 비디오용 사운드트랙을 생성하며 동기식 오디오-비주얼 생성을 달성합니다.

제품 입구: https://top.aibase.com/tool/deepmind-v2a

사용자는 "긍정적 프롬프트" 또는 "부정적 프롬프트"의 텍스트 설명을 통해 오디오 출력을 안내하여 오디오 트랙 생성을 정밀하게 제어할 수 있습니다. V2A 시스템은 자동 회귀 및 확산 방법을 사용하여 오디오를 생성하고 동기화되고 사실적인 오디오 출력을 달성합니다. 훈련 과정에서 시스템은 AI 생성 주석을 사용하여 모델이 특정 오디오 이벤트가 시각적 장면과 어떻게 관련되는지 이해하도록 돕습니다.

작동 방식:

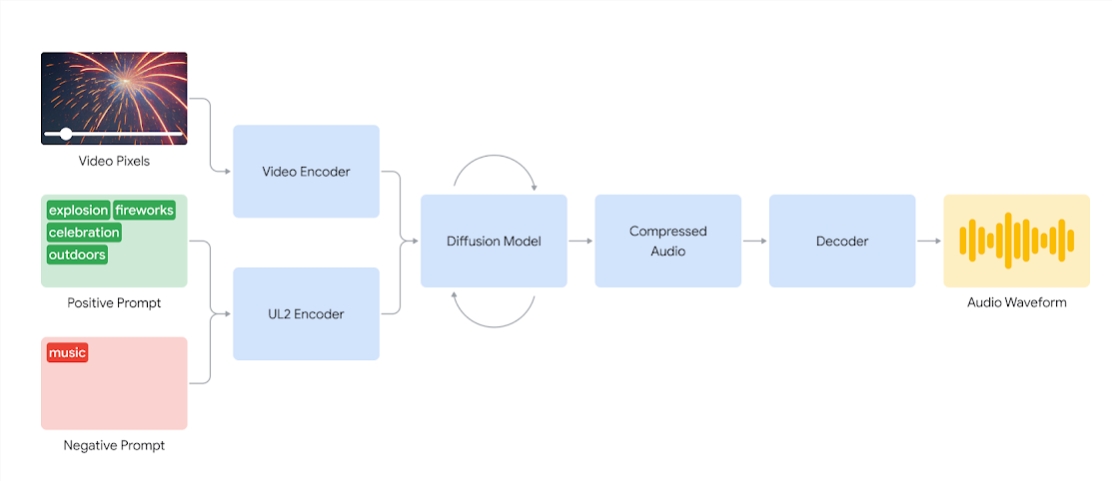

V2A 시스템은 먼저 비디오 입력을 압축된 표현으로 인코딩합니다. 그런 다음 확산 모델은 무작위 노이즈로부터 오디오를 반복적으로 개선합니다. 이 프로세스는 시각적 입력과 자연어 단서에 의해 안내되어 단서와 밀접하게 일치하는 동기화되고 사실적인 오디오를 생성합니다. 마지막으로 오디오 출력이 디코딩되어 오디오 파형으로 변환되고 비디오 데이터와 결합됩니다.

비디오 픽셀과 오디오 큐 입력을 사용하여 기본 비디오와 동기화된 오디오 파형을 생성하는 V2A 시스템의 다이어그램. 첫째, V2A는 비디오 및 오디오 큐 입력을 인코딩하고 확산 모델을 통해 반복적으로 실행됩니다. 그러면 압축된 오디오가 생성되어 오디오 파형으로 디코딩됩니다.

더 높은 품질의 오디오를 생성하고 특정 사운드를 생성하도록 모델을 안내하는 기능을 높이기 위해 사운드에 대한 자세한 설명과 음성 대화 내용을 담은 AI 생성 주석을 포함하여 훈련 프로세스 중에 더 많은 정보가 추가됩니다.

비디오, 오디오 및 첨부된 주석을 학습함으로써 이 기술은 주석이나 녹음에 제공된 정보에 응답하면서 특정 오디오 이벤트를 다양한 시각적 장면과 연관시키는 방법을 학습합니다.

V2A 기능:

오디오 생성: V2A는 극적인 사운드 트랙 샷, 사실적인 사운드 효과 또는 비디오의 문자 및 톤과 일치하는 대화를 포함하여 비디오 장면과 사용자가 제공한 텍스트 설명을 기반으로 동기화된 오디오 트랙을 자동으로 생성합니다.

동기화된 오디오: 자동 회귀 및 확산 방법을 사용하여 오디오를 생성하여 생성된 오디오가 비디오 콘텐츠와 완벽하게 동기화되고 사실적인 오디오 출력을 제공하도록 합니다.

다양한 오디오 트랙: 사용자는 무제한의 오디오 트랙을 생성하고, 다양한 사운드 효과 조합을 시도하고, 비디오 콘텐츠에 가장 적합한 사운드를 찾을 수 있습니다.

큐 제어: 사용자는 "포지티브 큐" 또는 "네거티브 큐"를 정의하고 출력에 대한 제어를 추가하고 원치 않는 사운드를 방지하여 트랙 생성을 안내할 수 있습니다.

훈련 중 주석 사용: 훈련 과정에서 시스템은 AI 생성 주석을 사용하여 모델이 특정 오디오 이벤트와 시각적 장면 간의 연관성을 이해하도록 돕습니다.

오디오 생성 품질을 향상시키기 위해 연구팀은 소리 설명이 포함된 AI 생성 주석 및 음성 대화 녹음과 같은 더 많은 정보를 훈련 프로세스에 도입했습니다. 이러한 정보가 풍부한 교육을 통해 기술을 통해 비디오 콘텐츠를 더 잘 이해하고 시각적 장면에 맞는 오디오 효과를 생성할 수 있습니다.

그러나 여전히 몇 가지 과제가 남아 있으며 팀에서는 음성이 포함된 비디오의 립싱크를 개선하기 위해 노력하고 있습니다. V2A는 입력된 전사된 텍스트를 기반으로 음성을 생성하고 이를 캐릭터의 입술 움직임과 동기화하려고 시도합니다. 그러나 페어링된 비디오 생성 모델은 복사된 텍스트를 조건으로 하지 않을 수도 있습니다. 비디오 모델이 전사된 텍스트와 일치하는 입 움직임을 생성하지 않기 때문에 이로 인해 불일치가 발생하고 종종 이상한 립싱크가 발생합니다.

V2A 기술은 대중에게 공개되기 전에 엄격한 보안 평가 및 테스트를 거칩니다. V2A에서 생성된 더빙 사례는 다음과 같습니다.

1. 오디오 프롬프트: 늑대가 달을 보고 울부짖습니다.

2. 오디오 신호: 영화, 스릴러, 공포 영화, 음악, 긴장감, 분위기, 콘크리트 위의 발자국

3. 오디오 큐: 번쩍이는 조명과 환호하는 군중으로 둘러싸인 콘서트 무대의 드러머

오디오 프롬프트: 귀여운 공룡의 지저귀는 소리, 정글 분위기, 계란이 깨지는 소리

참고: 이 글의 동영상은 모두 Google 공식 사례에서 발췌한 것입니다.

전체적으로 Google DeepMind의 V2A 기술은 비디오 콘텐츠 제작에 새로운 가능성을 제공합니다. 강력한 오디오 생성 기능과 편리한 작동 방법은 비디오 제작 효율성을 크게 향상시킵니다. 아직 극복해야 할 몇 가지 과제가 있지만 V2A 기술의 향후 개발 전망은 기대해 볼 가치가 있습니다.