V2A, la dernière technologie de conversion vidéo-audio publiée par Google DeepMind, peut générer des pistes audio synchronisées et réalistes basées sur des images vidéo et des invites textuelles pour créer une bande-son de vidéos silencieuses. Cette technologie utilise des modèles autorégressifs et de diffusion, combinés à des annotations générées par l'IA, pour comprendre l'association entre des événements audio spécifiques et des scènes visuelles, permettant ainsi une génération audio plus précise et créative. Les utilisateurs peuvent contrôler la sortie audio via des « repères positifs » et des « repères négatifs » pour créer des pistes audio qui correspondent au contenu vidéo et aux effets souhaités. V2A prend non seulement en charge la génération de bandes sonores dramatiques et d'effets sonores réalistes, mais génère également des dialogues qui correspondent aux personnages et au ton de la vidéo, fournissant ainsi un puissant outil auxiliaire pour la production vidéo.

Google DeepMind a lancé V2A, une technologie de conversion vidéo-audio qui utilise des pixels vidéo et des invites textuelles pour générer des pistes audio riches, créer des bandes sonores pour des vidéos silencieuses et réaliser une génération audiovisuelle synchrone.

Entrée du produit : https://top.aibase.com/tool/deepmind-v2a

Les utilisateurs peuvent guider la sortie audio à travers des descriptions textuelles d'« invites positives » ou d'« invites négatives » pour obtenir un contrôle précis sur la création de pistes audio. Le système V2A utilise des méthodes autorégressives et de diffusion pour générer de l'audio, obtenant ainsi une sortie audio synchronisée et réaliste. Pendant le processus de formation, le système utilise des annotations générées par l'IA pour aider le modèle à comprendre le lien entre des événements audio spécifiques et la scène visuelle.

Comment ça marche :

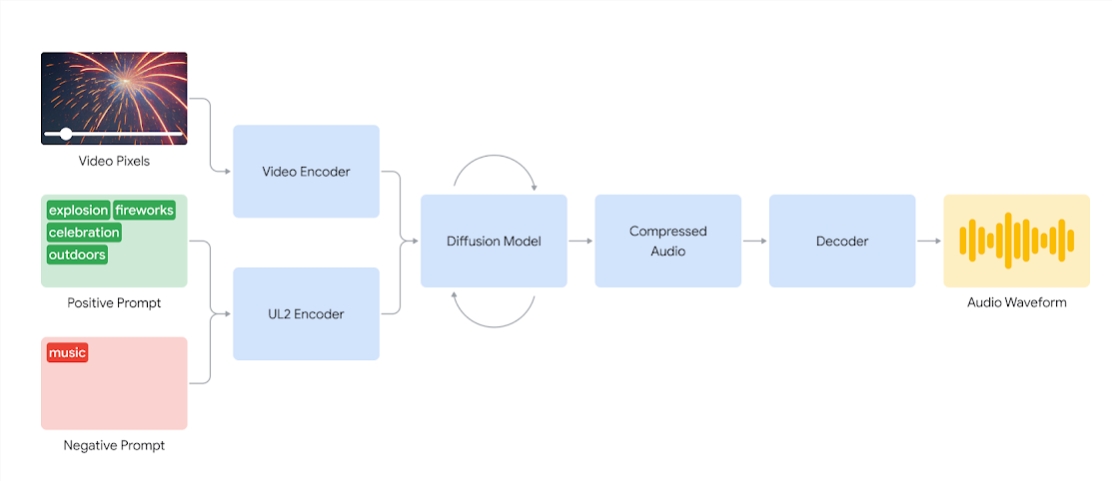

Les systèmes V2A codent d’abord l’entrée vidéo dans une représentation compressée. Le modèle de diffusion affine ensuite de manière itérative l'audio à partir du bruit aléatoire. Ce processus est guidé par une entrée visuelle et des signaux de langage naturel donnés pour produire un son synchronisé et réaliste qui correspond étroitement aux signaux. Enfin, la sortie audio est décodée, convertie en forme d'onde audio et combinée avec les données vidéo.

Schéma d'un système V2A qui utilise des pixels vidéo et des entrées de signaux audio pour générer des formes d'onde audio synchronisées avec la vidéo sous-jacente. Premièrement, V2A encode les entrées de signaux vidéo et audio et s'exécute de manière itérative via un modèle de diffusion. L'audio compressé est ensuite généré et décodé en une forme d'onde audio.

Pour générer un son de meilleure qualité et augmenter la capacité de guider le modèle pour produire des sons spécifiques, davantage d'informations sont ajoutées au cours du processus de formation, notamment des annotations générées par l'IA avec des descriptions détaillées des sons et des transcriptions des conversations parlées.

En s'entraînant sur la vidéo, l'audio et les annotations jointes, la technologie apprend à associer des événements audio spécifiques à diverses scènes visuelles tout en répondant aux informations fournies dans les annotations ou les enregistrements.

Fonctionnalités V2A :

Génération audio : V2A génère automatiquement des pistes audio synchronisées basées sur des séquences vidéo et des descriptions textuelles fournies par l'utilisateur, y compris des plans de bandes sonores dramatiques, des effets sonores réalistes ou des dialogues qui correspondent aux personnages et au ton de la vidéo.

Audio synchronisé : utilisez des méthodes autorégressives et de diffusion pour générer de l'audio, en garantissant que l'audio généré est parfaitement synchronisé avec le contenu vidéo et fournit une sortie audio réaliste.

Diverses pistes audio : les utilisateurs peuvent générer un nombre illimité de pistes audio, essayer différentes combinaisons d'effets sonores et trouver le son qui convient le mieux au contenu vidéo.

Contrôle du signal : les utilisateurs peuvent guider la génération de pistes en définissant un « signal positif » ou un « signal négatif », en ajoutant un contrôle sur la sortie et en l'éloignant des sons indésirables.

Utiliser des annotations pendant la formation : pendant le processus de formation, le système utilise des annotations générées par l'IA pour aider le modèle à comprendre l'association entre des événements audio spécifiques et des scènes visuelles.

Pour améliorer la qualité de la génération audio, l'équipe de recherche a introduit davantage d'informations dans le processus de formation, telles que des annotations générées par l'IA avec des descriptions sonores et des enregistrements de dialogues parlés. Une telle formation riche en informations permet à la technologie de mieux comprendre le contenu vidéo et de produire des effets audio adaptés à la scène visuelle.

Cependant, il reste encore quelques défis à relever et l'équipe travaille à améliorer la synchronisation labiale pour les vidéos impliquant de la parole. V2A tente de générer un discours basé sur le texte transcrit et de le synchroniser avec les mouvements des lèvres du personnage. Mais les modèles de génération vidéo couplés ne peuvent pas être conditionnés au texte transcrit. Cela entraîne des décalages, entraînant souvent une synchronisation labiale étrange, car le modèle vidéo ne génère pas de mouvements de bouche correspondant au texte transcrit.

La technologie V2A sera soumise à une évaluation et à des tests de sécurité rigoureux avant d'être mise à la disposition du public. Voici quelques cas de doublage générés par V2A :

1. Invite audio : Le loup hurle à la lune

2. Indices audio : films, thrillers, films d'horreur, musique, tension, atmosphère, pas sur le béton

3. Signal audio : le batteur sur scène, entouré de lumières clignotantes et d'une foule enthousiaste.

Invites audio : mignons petits gazouillis de dinosaures, atmosphère de jungle, craquement d'œufs

Remarque : les vidéos de cet article proviennent toutes d'exemples officiels de Google.

Dans l'ensemble, la technologie V2A de Google DeepMind apporte de nouvelles possibilités à la création de contenu vidéo. Ses puissantes capacités de génération audio et ses méthodes de fonctionnement pratiques amélioreront considérablement l'efficacité de la production vidéo. Même s’il reste encore quelques défis à relever, les perspectives de développement futur de la technologie V2A méritent d’être attendues.