V2A, a mais recente tecnologia de conversão de vídeo em áudio lançada pelo Google DeepMind, pode gerar faixas de áudio sincronizadas e realistas com base em imagens de vídeo e prompts de texto para criar trilhas sonoras de vídeos silenciosos. Esta tecnologia utiliza modelos autorregressivos e de difusão, combinados com anotações geradas por IA, para compreender a associação entre eventos de áudio específicos e cenas visuais, permitindo uma geração de áudio mais precisa e criativa. Os usuários podem controlar a saída de áudio por meio de "sugestões positivas" e "sugestões negativas" para criar faixas de áudio que correspondam ao conteúdo do vídeo e aos efeitos pretendidos. V2A não apenas suporta a geração de trilhas sonoras dramáticas e efeitos sonoros realistas, mas também gera diálogos que combinam com os personagens e o tom do vídeo, fornecendo uma poderosa ferramenta auxiliar para produção de vídeo.

O Google DeepMind lançou uma tecnologia de vídeo para áudio, a tecnologia V2A, que usa pixels de vídeo e prompts de texto para gerar trilhas de áudio ricas, criar trilhas sonoras para vídeos silenciosos e obter geração audiovisual síncrona.

Entrada do produto: https://top.aibase.com/tool/deepmind-v2a

Os usuários podem orientar a saída de áudio por meio de descrições de texto de "avisos positivos" ou "avisos negativos" para obter controle preciso sobre a criação da trilha de áudio. O sistema V2A usa métodos autorregressivos e de difusão para gerar áudio, obtendo uma saída de áudio realista e sincronizada. Durante o processo de treinamento, o sistema usa anotações geradas por IA para ajudar o modelo a entender como eventos de áudio específicos se relacionam com a cena visual.

Como funciona:

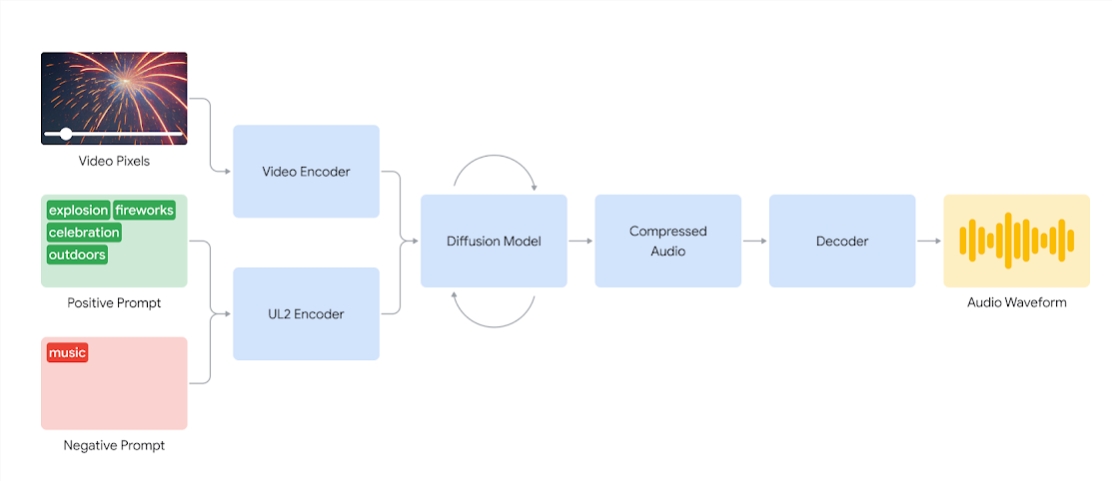

Os sistemas V2A primeiro codificam a entrada de vídeo em uma representação compactada. O modelo de difusão então refina iterativamente o áudio a partir do ruído aleatório. Este processo é guiado por informações visuais e dicas de linguagem natural fornecidas para produzir áudio sincronizado e realista que corresponda perfeitamente às dicas. Finalmente, a saída de áudio é decodificada, convertida em forma de onda de áudio e combinada com os dados de vídeo.

Diagrama de um sistema V2A que usa pixels de vídeo e entradas de sinais de áudio para gerar formas de onda de áudio sincronizadas com o vídeo subjacente. Primeiro, o V2A codifica entradas de sinais de vídeo e áudio e é executado iterativamente por meio de um modelo de difusão. O áudio compactado é então gerado e decodificado em uma forma de onda de áudio.

Para gerar áudio de maior qualidade e aumentar a capacidade de orientar o modelo para produzir sons específicos, mais informações são adicionadas durante o processo de treinamento, incluindo anotações geradas por IA com descrições detalhadas de sons e transcrições de conversas faladas.

Ao treinar em vídeo, áudio e anotações anexadas, a tecnologia aprende a associar eventos de áudio específicos a várias cenas visuais enquanto responde às informações fornecidas nas anotações ou gravações.

Recursos V2A:

Geração de áudio: o V2A gera automaticamente faixas de áudio sincronizadas com base em imagens de vídeo e descrições de texto fornecidas pelo usuário, incluindo cenas de trilhas sonoras dramáticas, efeitos sonoros realistas ou diálogos que correspondam aos personagens e ao tom do vídeo.

Áudio sincronizado: Use métodos autorregressivos e de difusão para gerar áudio, garantindo que o áudio gerado esteja perfeitamente sincronizado com o conteúdo do vídeo e forneça uma saída de áudio realista.

Diversas trilhas de áudio: os usuários podem gerar um número ilimitado de trilhas de áudio, experimentar diferentes combinações de efeitos sonoros e encontrar o som que melhor se adapta ao conteúdo do vídeo.

Controle de sugestão: os usuários podem orientar a geração de trilhas definindo "sugestão positiva" ou "sugestão negativa", adicionando controle sobre a saída e evitando sons indesejados.

Use anotações durante o treinamento: Durante o processo de treinamento, o sistema usa anotações geradas por IA para ajudar o modelo a compreender a associação entre eventos de áudio específicos e cenas visuais.

Para melhorar a qualidade da geração de áudio, a equipe de pesquisa introduziu mais informações no processo de treinamento, como anotações geradas por IA com descrições sonoras e gravações de diálogos falados. Esse treinamento rico em informações permite que a tecnologia compreenda melhor o conteúdo do vídeo e produza efeitos de áudio que correspondam à cena visual.

No entanto, ainda existem alguns desafios e a equipe está trabalhando para melhorar a sincronização labial em vídeos que envolvem fala. V2A tenta gerar fala com base no texto transcrito de entrada e sincronizá-lo com os movimentos labiais do personagem. Mas os modelos de geração de vídeo emparelhado não podem estar condicionados ao texto transcrito. Isso resulta em incompatibilidades, muitas vezes resultando em estranha sincronização labial, pois o modelo do vídeo não gera movimentos de boca que correspondam ao texto transcrito.

A tecnologia V2A passará por rigorosas avaliações e testes de segurança antes de ser disponibilizada ao público. A seguir estão alguns casos de dublagem gerados pelo V2A:

1. Aviso de áudio: O lobo uiva para a lua

2. Dicas de áudio: filmes, thrillers, filmes de terror, música, tensão, atmosfera, passos no concreto

3. Sugestão de áudio: Baterista no palco do show cercado por luzes piscando e multidão aplaudindo

Avisos de áudio: pequeno dinossauro fofo cantando, atmosfera de selva, ovo quebrando

Observação: os vídeos neste artigo são todos exemplos oficiais do Google

Em suma, a tecnologia V2A do Google DeepMind traz novas possibilidades para a criação de conteúdo de vídeo. Seus poderosos recursos de geração de áudio e métodos de operação convenientes irão melhorar muito a eficiência da produção de vídeo. Embora ainda existam alguns desafios que precisam ser superados, vale a pena esperar pelas perspectivas futuras de desenvolvimento da tecnologia V2A.