谷歌DeepMind發布了一份關於惡意AI應用的開創性研究報告,該報告揭示了生成式AI工具濫用的主要趨勢。研究關注了全球生成式AI的風險,特別是那些被大型科技公司推向市場以追求巨額利潤的工具。研究團隊DeepMind和Jigsaw合作,分析了數百起濫用案例,旨在量化這些風險,並為未來AI安全策略提供數據支援。報告中發現,假訊息傳播,特別是「Deepfakes」的生成,已經成為最常見的惡意AI應用,對公眾輿論和政治進程構成了嚴重威脅。

GoogleDeepMind 首次進行了關於最常見的惡意AI 應用的研究,結果顯示生成虛假政治家和名人的人工智能(AI)“Deepfakes” 比用AI 協助網絡攻擊的嘗試更為普遍。這項研究是GoogleAI 部門DeepMind 和Google旗下的研發單位Jigsaw 合作的,目的是量化產生AI 工具的風險,這些工具已被全球最大的科技公司推向市場以尋求巨額利潤。

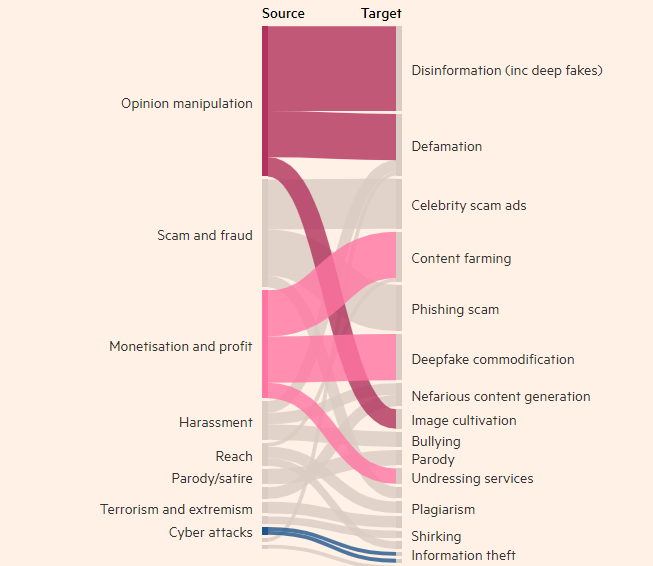

與技術相關的不良行為者的動機

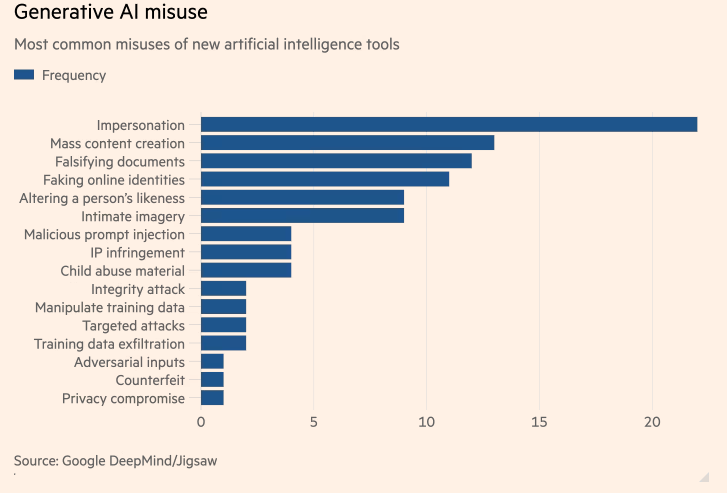

研究發現,製作真實但虛假的人物圖像、視訊和音訊的行為幾乎是濫用生成AI 工具的次數最多的一種,比其他次高的使用文字工具(例如聊天機器人)偽造資訊的方式高出近兩倍。濫用生成AI 的最常見目標是影響公眾輿論,這佔據了27% 的使用情況,引發了對Deepfakes 如何影響今年全球選舉的擔憂。

近幾個月來,英國首相Rishi Sunak 和其他全球領袖的Deepfakes 出現在TikTok、X 和Instagram 上。英國選民將在下週的大選中投票。儘管社群媒體平台努力標註或刪除此類內容,但人們可能不會意識到這是虛假的,而內容的傳播可能會影響選民的投票。 DeepMind 的研究人員分析了大約200起濫用行為,涉及社群媒體平台X 和Reddit,以及網路部落格和媒體報道濫用行為的情況。

研究發現,濫用AI 生成產品(如OpenAI 的ChatGPT 和谷歌的Gemini)的第二大動機是賺錢,無論是提供創建Deepfakes 的服務,還是使用生成AI 創建大量內容,例如虛假新聞文章。研究發現,大多數濫用行為使用易於獲得的工具,“需要最少的技術專業知識”,這意味著更多的不良行為者可以濫用生成AI。

DeepMind 的研究將影響其改進評估模型的安全性,並希望這也會影響其競爭對手和其他利害關係人如何看待「危害的表現」。

劃重點:

- DeepMind 的研究發現Deepfakes 是濫用人工智慧應用的首要問題。

- 最常見的濫用生成AI 工具的目的是影響公眾輿論,佔使用情況的27%。

- 濫用生成AI 的第二大動機是賺錢,主要包括提供Deepfakes 服務和虛假新聞的創建。

這項研究對於了解和應對生成式AI帶來的潛在風險至關重要。 DeepMind的研究結果強調了需要發展更有效的安全機制和監管框架,以防止惡意行為者利用AI技術進行有害活動,並保障公眾利益和資訊安全。 未來,類似的研究將持續推動AI技術的安全發展。