Google DeepMind hat einen bahnbrechenden Forschungsbericht über bösartige KI-Anwendungen veröffentlicht, der wichtige Trends beim Missbrauch generativer KI-Tools aufzeigt. Die Studie befasst sich mit den Risiken generativer KI auf der ganzen Welt, insbesondere mit Tools, die von großen Technologieunternehmen auf der Suche nach riesigen Gewinnen auf den Markt gebracht werden. Die Forschungsteams DeepMind und Jigsaw haben gemeinsam Hunderte von Missbrauchsfällen analysiert, mit dem Ziel, diese Risiken zu quantifizieren und Datenunterstützung für zukünftige KI-Sicherheitsstrategien bereitzustellen. Der Bericht stellte fest, dass die Verbreitung falscher Informationen, insbesondere die Generierung von „Deepfakes“, zur häufigsten bösartigen KI-Anwendung geworden ist und eine ernsthafte Bedrohung für die öffentliche Meinung und den politischen Prozess darstellt.

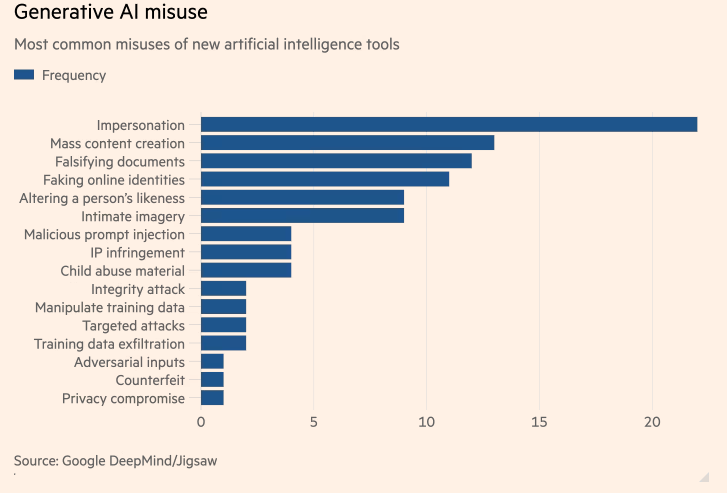

Eine einzigartige Studie von Google DeepMind zu den häufigsten bösartigen KI-Anwendungen zeigt, dass „Deepfakes“ künstlicher Intelligenz (KI), die falsche Politiker und Prominente generieren, häufiger vorkommen als Versuche, KI zur Unterstützung von Cyberangriffen einzusetzen. Die Studie, eine Zusammenarbeit zwischen Googles KI-Abteilung DeepMind und Googles Forschungs- und Entwicklungseinheit Jigsaw, zielte darauf ab, die Risiken der Entwicklung von KI-Tools zu quantifizieren, die von den weltweit größten Technologieunternehmen auf der Suche nach riesigen Gewinnen auf den Markt gebracht wurden.

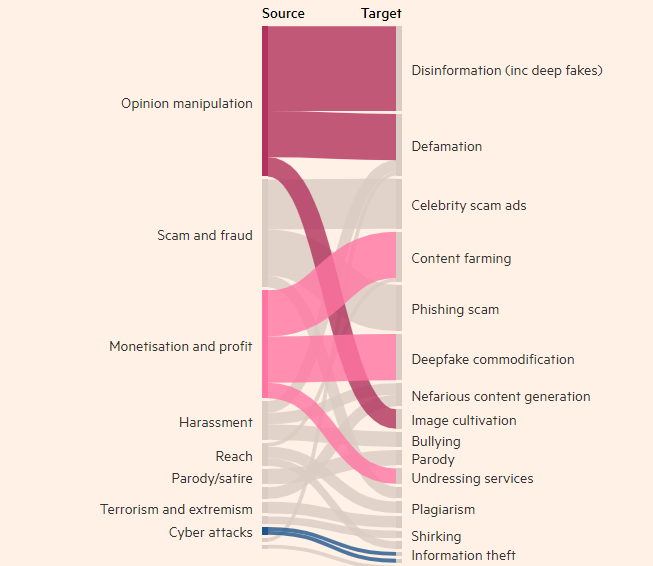

Motive technologiebezogener schlechter Akteure

Die Studie ergab, dass die Erstellung echter, aber falscher Bilder, Videos und Audiodaten von Menschen der häufigste Missbrauch generativer KI-Tools war, fast doppelt so häufig wie die zweithäufigste Nutzung von Texttools wie Chatbots. mal Informationen verfälschen. Das häufigste Ziel des Missbrauchs generativer KI ist die Beeinflussung der öffentlichen Meinung, was 27 % der Anwendungsfälle ausmacht, was Bedenken darüber aufkommen lässt, wie Deepfakes in diesem Jahr Wahlen auf der ganzen Welt beeinflussen könnten.

In den letzten Monaten sind Deepfakes des britischen Premierministers Rishi Sunak und anderer Weltführer auf TikTok, X und Instagram aufgetaucht. Die britischen Wähler werden bei den Parlamentswahlen nächste Woche zur Wahl gehen. Trotz der Bemühungen von Social-Media-Plattformen, solche Inhalte zu kennzeichnen oder zu entfernen, werden sie möglicherweise nicht als falsch erkannt und die Verbreitung der Inhalte kann die Wahlbeteiligung beeinflussen. DeepMind-Forscher analysierten rund 200 Missbrauchsfälle auf den Social-Media-Plattformen X und Reddit sowie Online-Blogs und Medienberichte über Missbrauch.

Die Studie ergab, dass die zweitgrößte Motivation für den Missbrauch von KI-generierten Produkten wie ChatGPT von OpenAI und Gemini von Google darin bestand, Geld zu verdienen, sei es durch das Anbieten von Diensten zur Erstellung von Deepfakes oder durch die Nutzung generativer KI zur Erstellung großer Mengen an Inhalten wie Fakes Nachrichtenartikel. Die Studie ergab, dass bei den meisten Missbräuchen leicht zugängliche Tools zum Einsatz kommen, die „nur minimales technisches Fachwissen erfordern“, was bedeutet, dass mehr böswillige Akteure generative KI missbrauchen können.

Die Forschung von DeepMind wird Einfluss darauf haben, wie das Unternehmen seine Bewertung der Sicherheit seiner Modelle verbessert, und es hofft, dass dies auch Einfluss darauf haben wird, wie seine Konkurrenten und andere Interessengruppen die „Manifestation von Schäden“ sehen.

Highlight:

- Untersuchungen von DeepMind ergaben, dass Deepfakes das größte Problem für den Missbrauch von Anwendungen der künstlichen Intelligenz sind.

- Der häufigste Missbrauch generativer KI-Tools besteht in der Beeinflussung der öffentlichen Meinung und macht 27 % der Nutzungen aus.

– Die zweitgrößte Motivation für den Missbrauch generierter KI ist das Geldverdienen, wozu vor allem die Bereitstellung von Deepfakes-Diensten und die Erstellung gefälschter Nachrichten gehört.

Diese Forschung ist von entscheidender Bedeutung für das Verständnis und die Bewältigung der potenziellen Risiken, die von generativer KI ausgehen. Die Forschungsergebnisse von DeepMind unterstreichen die Notwendigkeit, wirksamere Sicherheitsmechanismen und Regulierungsrahmen zu entwickeln, um zu verhindern, dass böswillige Akteure KI-Technologie für schädliche Aktivitäten nutzen und öffentliche Interessen und Informationssicherheit schützen. Auch in Zukunft werden ähnliche Forschungen die sichere Entwicklung der KI-Technologie vorantreiben.