Google DeepMind выпустила новаторский исследовательский отчет о вредоносных приложениях ИИ, в котором раскрываются основные тенденции в неправомерном использовании инструментов генеративного ИИ. В исследовании рассматриваются риски, связанные с генеративным искусственным интеллектом во всем мире, особенно с инструментами, которые крупные технологические компании продвигают на рынок в погоне за огромной прибылью. Исследовательские группы DeepMind и Jigsaw совместно проанализировали сотни случаев злоупотреблений, стремясь количественно оценить эти риски и предоставить данные для поддержки будущих стратегий безопасности ИИ. В отчете установлено, что распространение ложной информации, особенно создание «дипфейков», стало самым распространенным вредоносным приложением ИИ, представляющим серьезную угрозу общественному мнению и политическому процессу.

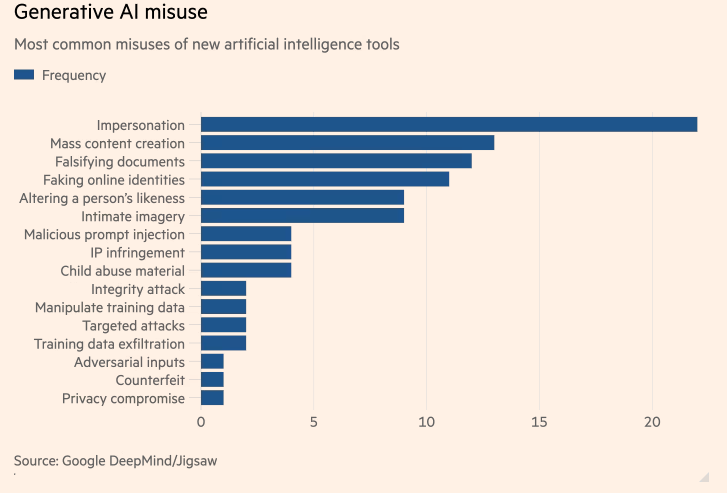

Первое в своем роде исследование наиболее распространенных вредоносных приложений ИИ, проведенное Google DeepMind, показывает, что «дипфейки» искусственного интеллекта (ИИ), создающие фальшивых политиков и знаменитостей, встречаются чаще, чем попытки использовать ИИ для содействия кибератакам. Исследование, созданное в результате сотрудничества подразделения искусственного интеллекта Google DeepMind и подразделения исследований и разработок Google Jigsaw, было направлено на количественную оценку рисков создания инструментов искусственного интеллекта, которые были выведены на рынок крупнейшими мировыми технологическими компаниями в поисках огромной прибыли.

Мотивы злоумышленников, связанных с технологиями

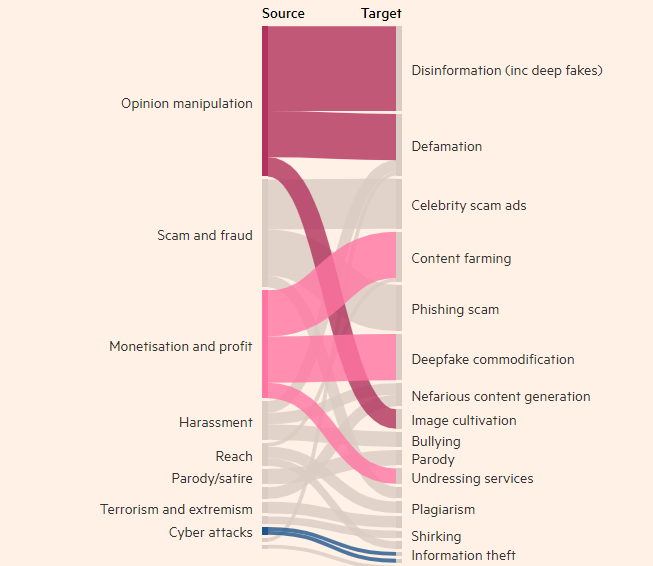

Исследование показало, что создание реальных, но ложных изображений, видео и аудио людей было наиболее распространенным злоупотреблением инструментами генеративного искусственного интеллекта, почти в два раза более распространенным, чем следующее по величине использование текстовых инструментов, таких как чат-боты. раз фальсифицировать информацию. Наиболее распространенной целью злоупотреблений генеративным ИИ является влияние на общественное мнение, на которое приходится 27% случаев использования, что вызывает обеспокоенность по поводу того, как дипфейки могут повлиять на выборы по всему миру в этом году.

В последние месяцы в TikTok, X и Instagram появились дипфейки премьер-министра Великобритании Риши Сунака и других мировых лидеров. Британские избиратели придут на избирательные участки на всеобщих выборах, которые состоятся на следующей неделе. Несмотря на усилия платформ социальных сетей маркировать или удалять такой контент, люди могут не признать его ложным, а распространение контента может повлиять на явку избирателей. Исследователи DeepMind проанализировали около 200 случаев злоупотреблений с участием платформ социальных сетей X и Reddit, а также онлайн-блогов и сообщений СМИ о злоупотреблениях.

Исследование показало, что второй по значимости мотивацией злоупотребления продуктами, созданными ИИ, такими как ChatGPT от OpenAI и Gemini от Google, было зарабатывание денег, будь то предложение услуг по созданию дипфейков или использование генеративного ИИ для создания больших объемов контента, например фейкового. новостные статьи. Исследование показало, что в большинстве случаев злоупотреблений используются легкодоступные инструменты, которые «требуют минимальных технических знаний», а это означает, что больше злоумышленников могут злоупотреблять генеративным ИИ.

Исследования DeepMind повлияют на то, как компания улучшит оценку безопасности своих моделей, и компания надеется, что это также повлияет на то, как ее конкуренты и другие заинтересованные стороны рассматривают «проявление вреда».

Выделять:

- Исследование DeepMind показало, что дипфейки являются проблемой номер один из-за неправильного использования приложений искусственного интеллекта.

- Наиболее распространенным злоупотреблением инструментами генеративного ИИ является влияние на общественное мнение, что составляет 27% случаев использования.

- Второй по значимости мотивацией злоупотребления созданным ИИ является зарабатывание денег, что в основном включает в себя предоставление услуг Deepfakes и создание фейковых новостей.

Это исследование имеет решающее значение для понимания и устранения потенциальных рисков, связанных с генеративным ИИ. Результаты исследования DeepMind подчеркивают необходимость разработки более эффективных механизмов безопасности и нормативно-правовой базы, чтобы предотвратить использование злоумышленниками технологии искусственного интеллекта для ведения вредоносной деятельности и защиты общественных интересов и информационной безопасности. В будущем подобные исследования будут продолжать способствовать безопасному развитию технологий искусственного интеллекта.