Google DeepMind ได้เปิดตัวรายงานการวิจัยที่ก้าวล้ำเกี่ยวกับแอปพลิเคชัน AI ที่เป็นอันตราย ซึ่งเผยให้เห็นแนวโน้มที่สำคัญในการใช้เครื่องมือ AI เชิงสร้างสรรค์ในทางที่ผิด งานวิจัยนี้พิจารณาถึงความเสี่ยงของ generative AI ทั่วโลก โดยเฉพาะอย่างยิ่งเครื่องมือที่บริษัทเทคโนโลยีขนาดใหญ่นำออกสู่ตลาดเพื่อแสวงหาผลกำไรมหาศาล ทีมวิจัย DeepMind และ Jigsaw ร่วมมือกันวิเคราะห์กรณีการละเมิดหลายร้อยกรณี โดยมีเป้าหมายเพื่อวัดปริมาณความเสี่ยงเหล่านี้ และให้การสนับสนุนข้อมูลสำหรับกลยุทธ์ความปลอดภัย AI ในอนาคต รายงานพบว่าการแพร่กระจายของข้อมูลเท็จ โดยเฉพาะอย่างยิ่งการสร้าง "Deepfakes" ได้กลายเป็นแอปพลิเคชัน AI ที่เป็นอันตรายที่พบบ่อยที่สุด ซึ่งก่อให้เกิดภัยคุกคามร้ายแรงต่อความคิดเห็นของประชาชนและกระบวนการทางการเมือง

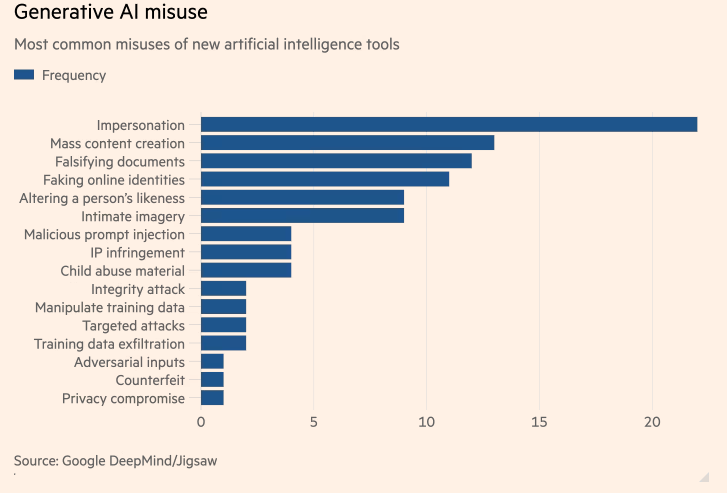

การศึกษาครั้งแรกที่ไม่ซ้ำใครโดย Google DeepMind เกี่ยวกับแอปพลิเคชัน AI ที่เป็นอันตรายที่พบบ่อยที่สุด แสดงให้เห็นว่าปัญญาประดิษฐ์ (AI) "ดีพเฟค" ที่สร้างนักการเมืองและคนดังปลอมนั้นพบได้บ่อยกว่าการพยายามใช้ AI เพื่อช่วยเหลือการโจมตีทางไซเบอร์ การศึกษานี้เป็นความร่วมมือระหว่างหน่วย AI ของ Google DeepMind และหน่วยวิจัยและพัฒนาของ Google Jigsaw มีวัตถุประสงค์เพื่อวัดปริมาณความเสี่ยงในการสร้างเครื่องมือ AI ที่บริษัทเทคโนโลยีรายใหญ่ที่สุดของโลกนำออกสู่ตลาดเพื่อค้นหาผลกำไรมหาศาล

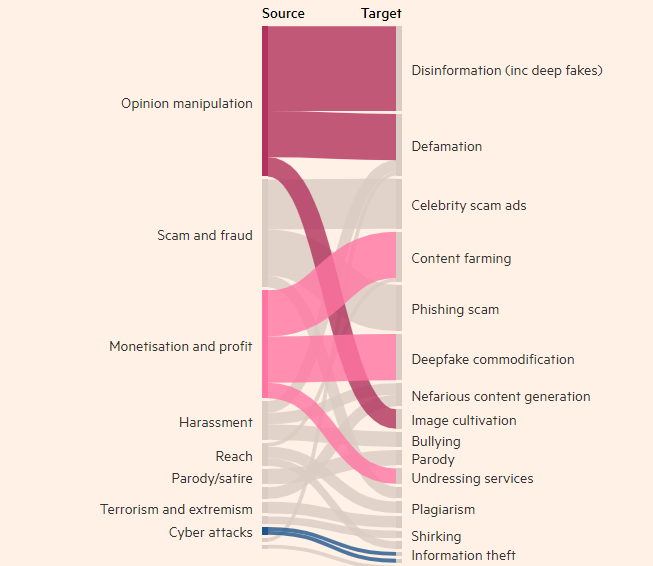

แรงจูงใจของผู้ไม่ประสงค์ดีที่เกี่ยวข้องกับเทคโนโลยี

ผลการศึกษาพบว่า การสร้างภาพ วิดีโอ และเสียงที่เป็นจริงแต่เป็นเท็จนั้น เป็นการใช้เครื่องมือ AI ที่สร้างในทางที่ผิดที่พบบ่อยที่สุด ซึ่งมากกว่าการใช้เครื่องมือข้อความที่สูงเป็นอันดับถัดไป เช่น แชทบอท เกือบสองเท่า เพื่อบิดเบือนข้อมูลครั้ง เป้าหมายที่พบบ่อยที่สุดของการใช้ generative AI ในทางที่ผิดคือการมีอิทธิพลต่อความคิดเห็นของประชาชน ซึ่งคิดเป็น 27% ของกรณีการใช้งาน ทำให้เกิดความกังวลว่า Deepfakes อาจมีอิทธิพลต่อการเลือกตั้งทั่วโลกในปีนี้อย่างไร

Deepfakes ของนายกรัฐมนตรีอังกฤษ Rishi Sunak และผู้นำระดับโลกคนอื่น ๆ ได้ปรากฏตัวบน TikTok, X และ Instagram ในช่วงหลายเดือนที่ผ่านมา ผู้มีสิทธิเลือกตั้งชาวอังกฤษจะไปลงคะแนนเสียงในการเลือกตั้งทั่วไปในสัปดาห์หน้า แม้ว่าแพลตฟอร์มโซเชียลมีเดียจะพยายามติดป้ายกำกับหรือลบเนื้อหาดังกล่าว แต่ผู้คนก็อาจไม่ยอมรับว่าเนื้อหาดังกล่าวเป็นเท็จ และการแพร่กระจายของเนื้อหาอาจส่งผลต่อการลงคะแนนเสียงของผู้มีสิทธิเลือกตั้ง นักวิจัยของ DeepMind วิเคราะห์กรณีการละเมิดประมาณ 200 กรณีที่เกี่ยวข้องกับแพลตฟอร์มโซเชียลมีเดีย X และ Reddit รวมถึงบล็อกออนไลน์และรายงานสื่อเกี่ยวกับการละเมิด

การศึกษาพบว่าแรงจูงใจที่ใหญ่เป็นอันดับสองในการใช้ผลิตภัณฑ์ที่สร้างโดย AI ในทางที่ผิด เช่น ChatGPT ของ OpenAI และ Gemini ของ Google คือการสร้างรายได้ ไม่ว่าจะเป็นการเสนอบริการเพื่อสร้าง Deepfakes หรือใช้ generative AI เพื่อสร้างเนื้อหาจำนวนมาก เช่น ของปลอม บทความข่าว การศึกษาพบว่าการละเมิดส่วนใหญ่ใช้เครื่องมือที่เข้าถึงได้ง่ายซึ่ง "ต้องใช้ความเชี่ยวชาญทางเทคนิคเพียงเล็กน้อย" ซึ่งหมายความว่าผู้ไม่ประสงค์ดีสามารถใช้ AI ที่สร้างในทางที่ผิดได้มากขึ้น

การวิจัยของ DeepMind จะมีอิทธิพลต่อการปรับปรุงการประเมินความปลอดภัยของโมเดล และหวังว่าสิ่งนี้จะส่งผลต่อวิธีที่คู่แข่งและผู้มีส่วนได้ส่วนเสียอื่นๆ มอง "การแสดงอันตราย"

ไฮไลท์:

- การวิจัยของ DeepMind พบว่า Deepfakes เป็นปัญหาอันดับหนึ่งสำหรับการใช้งานปัญญาประดิษฐ์ในทางที่ผิด

- การใช้เครื่องมือ generative AI ในทางที่ผิดที่พบบ่อยที่สุดคือการโน้มน้าวความคิดเห็นสาธารณะ ซึ่งคิดเป็น 27% ของการใช้งาน

- แรงจูงใจที่ใหญ่เป็นอันดับสองสำหรับการใช้ AI ที่สร้างขึ้นในทางที่ผิดคือการสร้างรายได้ ซึ่งส่วนใหญ่รวมถึงการให้บริการ Deepfakes และการสร้างข่าวปลอม

งานวิจัยนี้มีความสำคัญอย่างยิ่งในการทำความเข้าใจและจัดการกับความเสี่ยงที่อาจเกิดขึ้นจาก generative AI ผลการวิจัยของ DeepMind เน้นย้ำถึงความจำเป็นในการพัฒนากลไกความปลอดภัยและกรอบการกำกับดูแลที่มีประสิทธิภาพมากขึ้น เพื่อป้องกันผู้ไม่ประสงค์ดีใช้เทคโนโลยี AI เพื่อดำเนินกิจกรรมที่เป็นอันตราย และปกป้องผลประโยชน์สาธารณะและความปลอดภัยของข้อมูล ในอนาคต การวิจัยที่คล้ายกันนี้จะยังคงส่งเสริมการพัฒนาเทคโนโลยี AI อย่างปลอดภัยต่อไป