Google DeepMind ha publicado un informe de investigación innovador sobre aplicaciones maliciosas de IA que revela tendencias importantes en el uso indebido de herramientas de IA generativa. La investigación analiza los riesgos de la IA generativa en todo el mundo, en particular las herramientas que las grandes empresas tecnológicas lanzan al mercado en busca de enormes ganancias. Los equipos de investigación DeepMind y Jigsaw colaboraron para analizar cientos de casos de abuso, con el objetivo de cuantificar estos riesgos y brindar soporte de datos para futuras estrategias de seguridad de IA. El informe encontró que la difusión de información falsa, especialmente la generación de "Deepfakes", se ha convertido en la aplicación maliciosa de IA más común, lo que representa una grave amenaza para la opinión pública y el proceso político.

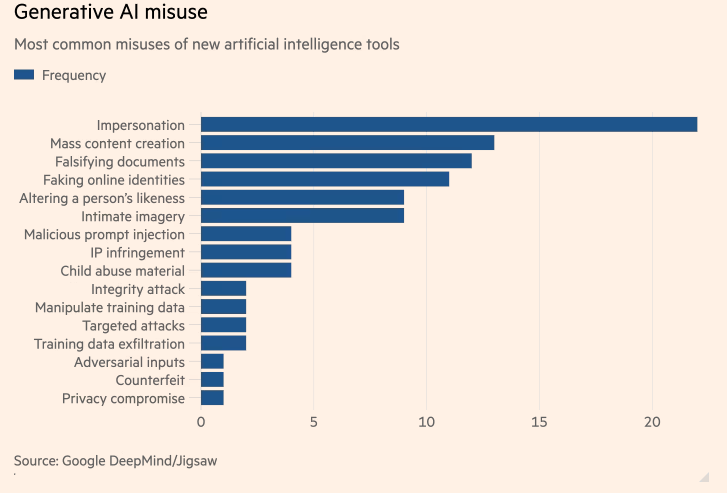

Un estudio, el primero de su tipo, realizado por Google DeepMind sobre las aplicaciones maliciosas de IA más comunes muestra que los "deepfakes" de inteligencia artificial (IA) que generan políticos y celebridades falsos son más comunes que los intentos de utilizar la IA para ayudar en ciberataques. El estudio, una colaboración entre la unidad de IA de Google, DeepMind, y la unidad de investigación y desarrollo de Google, Jigsaw, tenía como objetivo cuantificar los riesgos de generar herramientas de IA que han sido llevadas al mercado por las empresas de tecnología más grandes del mundo en busca de enormes ganancias.

Motivos de los malos actores relacionados con la tecnología

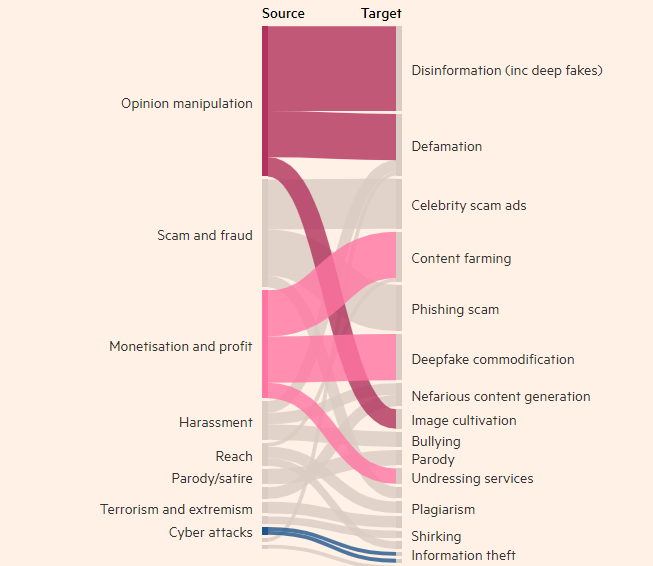

El estudio encontró que el acto de crear imágenes, videos y audio reales pero falsos de personas fue el uso indebido más común de las herramientas de inteligencia artificial generativa, casi dos veces más común que el siguiente uso más alto de herramientas de texto, como los chatbots. para falsificar información tiempos. El objetivo más común del uso indebido de la IA generativa es influir en la opinión pública, que representa el 27% de los casos de uso, lo que genera preocupación sobre cómo los deepfakes pueden influir en las elecciones de todo el mundo este año.

En los últimos meses han aparecido deepfakes del primer ministro británico Rishi Sunak y otros líderes mundiales en TikTok, X e Instagram. Los votantes británicos acudirán a las urnas en las elecciones generales de la próxima semana. A pesar de los esfuerzos de las plataformas de redes sociales por etiquetar o eliminar dicho contenido, es posible que la gente no lo reconozca como falso y la difusión del contenido puede influir en la participación electoral. Los investigadores de DeepMind analizaron aproximadamente 200 casos de abuso que involucraban a las plataformas de redes sociales X y Reddit, así como blogs en línea e informes de abuso en los medios.

El estudio encontró que la segunda mayor motivación para abusar de productos generados por IA, como ChatGPT de OpenAI y Gemini de Google, era ganar dinero, ya sea ofreciendo servicios para crear deepfakes o usando IA generativa para crear grandes cantidades de contenido, como falsos. artículos de noticias. El estudio encontró que la mayoría de los abusos utilizan herramientas de fácil acceso que "requieren experiencia técnica mínima", lo que significa que más actores malos pueden abusar de la IA generativa.

La investigación de DeepMind influirá en cómo mejora su evaluación de la seguridad de sus modelos, y espera que esto también influya en cómo sus competidores y otras partes interesadas ven la "manifestación de daño".

Reflejos:

- La investigación de DeepMind encontró que los deepfakes son el problema número uno por el uso indebido de aplicaciones de inteligencia artificial.

- El uso indebido más común de las herramientas de IA generativa es influir en la opinión pública, representando el 27% de los usos.

- La segunda motivación más importante para abusar de la IA generada es ganar dinero, lo que incluye principalmente la prestación de servicios Deepfakes y la creación de noticias falsas.

Esta investigación es fundamental para comprender y abordar los riesgos potenciales que plantea la IA generativa. Los hallazgos de la investigación de DeepMind resaltan la necesidad de desarrollar mecanismos de seguridad y marcos regulatorios más efectivos para evitar que actores maliciosos utilicen tecnología de inteligencia artificial para realizar actividades dañinas y proteger los intereses públicos y la seguridad de la información. En el futuro, se seguirán realizando investigaciones similares para promover el desarrollo seguro de la tecnología de IA.