Google DeepMind는 생성 AI 도구의 오용에 대한 주요 추세를 보여주는 악성 AI 애플리케이션에 대한 획기적인 연구 보고서를 발표했습니다. 이 연구에서는 전 세계 생성 AI의 위험성, 특히 거대 기술 기업이 막대한 이익을 추구하기 위해 시장에 출시하는 도구를 살펴봅니다. 연구팀 DeepMind와 Jigsaw는 이러한 위험을 정량화하고 미래 AI 보안 전략을 위한 데이터 지원을 제공하는 것을 목표로 수백 건의 남용 사례를 분석하기 위해 협력했습니다. 보고서는 허위 정보의 확산, 특히 '딥페이크' 생성이 가장 일반적인 악성 AI 애플리케이션이 되어 여론과 정치 과정에 심각한 위협을 가하고 있음을 발견했습니다.

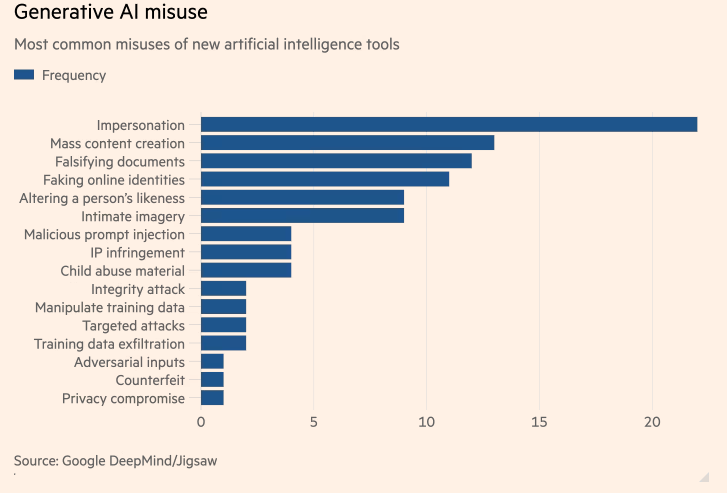

가장 일반적인 악성 AI 애플리케이션에 대한 Google DeepMind의 최초 연구에 따르면 가짜 정치인과 유명 인사를 생성하는 인공 지능(AI) "딥페이크"가 AI를 사용하여 사이버 공격을 지원하려는 시도보다 더 흔하다는 사실이 밝혀졌습니다. Google의 AI 부서인 DeepMind와 Google의 연구 개발 부서인 Jigsaw가 공동으로 진행한 이 연구는 막대한 이익을 추구하는 세계 최대 기술 기업이 시장에 출시한 AI 도구 생성의 위험을 정량화하는 것을 목표로 했습니다.

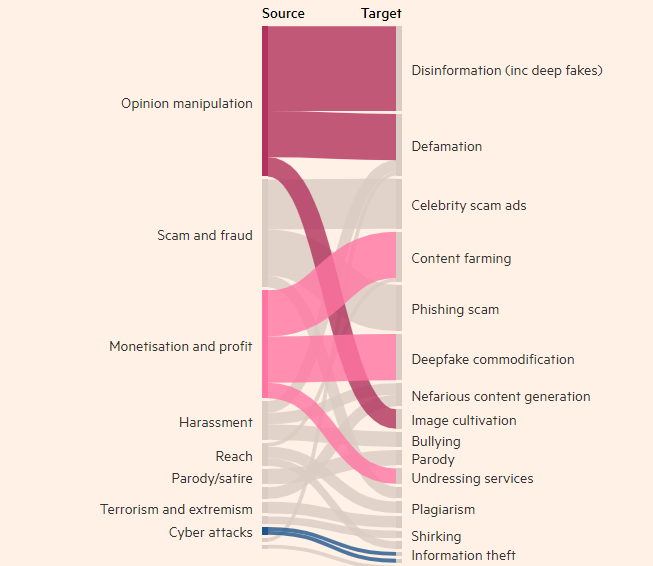

기술 관련 나쁜 행위자의 동기

연구에 따르면 사람들의 실제이지만 거짓인 이미지, 비디오 및 오디오를 생성하는 행위는 생성 AI 도구의 가장 일반적인 오용으로, 챗봇과 같은 다음으로 많이 사용되는 텍스트 도구보다 거의 2배 더 흔하다는 사실이 밝혀졌습니다. 정보를 위조하는 것. 생성 AI 오용의 가장 일반적인 목표는 여론에 영향을 미치는 것인데, 이는 사용 사례의 27%를 차지하며 딥페이크가 올해 전 세계 선거에 어떤 영향을 미칠 수 있는지에 대한 우려를 불러일으킵니다.

최근 몇 달 동안 영국 총리 리시 수낙(Rishi Sunak)과 기타 글로벌 지도자들의 딥페이크가 TikTok, X 및 Instagram에 등장했습니다. 영국 유권자들은 다음 주 총선에 투표하러 갈 예정입니다. 이러한 콘텐츠에 라벨을 붙이거나 삭제하려는 소셜 미디어 플랫폼의 노력에도 불구하고 사람들은 이를 허위로 인식하지 못할 수 있으며 콘텐츠의 확산이 유권자 투표율에 영향을 미칠 수 있습니다. DeepMind 연구원들은 소셜 미디어 플랫폼 X 및 Reddit과 관련된 약 200건의 학대 사례는 물론 온라인 블로그 및 미디어의 학대 보고서도 분석했습니다.

연구에 따르면 OpenAI의 ChatGPT 및 Google의 Gemini와 같은 AI 생성 제품을 남용하는 두 번째로 큰 동기는 딥페이크를 만드는 서비스를 제공하든, 생성 AI를 사용하여 가짜와 같은 대량의 콘텐츠를 만드는 것이든 간에 돈을 벌기 위한 것이었습니다. 뉴스 기사. 연구에 따르면 대부분의 남용은 "최소한의 기술 전문 지식이 필요한" 쉽게 접근할 수 있는 도구를 사용하는 것으로 나타났습니다. 이는 더 많은 악의적인 행위자가 생성 AI를 악용할 수 있음을 의미합니다.

DeepMind의 연구는 모델의 안전성 평가를 개선하는 방법에 영향을 미칠 것이며, 이것이 경쟁사와 기타 이해관계자가 "위험의 징후"를 보는 방식에도 영향을 미치기를 바랍니다.

가장 밝은 부분:

- DeepMind의 연구에 따르면 인공지능 애플리케이션 오용의 가장 큰 문제는 딥페이크입니다.

- 생성 AI 도구의 가장 흔한 오용은 여론에 영향을 미치는 것으로 전체 사용의 27%를 차지합니다.

- 생성된 AI를 악용하는 두 번째로 큰 동기는 돈을 버는 것인데, 여기에는 주로 Deepfakes 서비스 제공과 가짜 뉴스 생성이 포함됩니다.

이 연구는 생성 AI로 인한 잠재적 위험을 이해하고 해결하는 데 중요합니다. DeepMind의 연구 결과는 악의적인 행위자가 AI 기술을 사용하여 유해한 활동을 수행하고 공익과 정보 보안을 보호하는 것을 방지하기 위해 보다 효과적인 보안 메커니즘과 규제 프레임워크를 개발할 필요성을 강조합니다. 앞으로도 유사한 연구가 AI 기술의 안전한 발전을 위해 계속해서 추진될 것입니다.