أصدرت Google DeepMind تقريرًا بحثيًا رائدًا حول تطبيقات الذكاء الاصطناعي الضارة يكشف عن الاتجاهات الرئيسية في إساءة استخدام أدوات الذكاء الاصطناعي التوليدية. يبحث البحث في مخاطر الذكاء الاصطناعي التوليدي في جميع أنحاء العالم، وخاصة الأدوات التي تدفعها شركات التكنولوجيا الكبرى إلى السوق سعياً لتحقيق أرباح ضخمة. تعاونت فرق البحث DeepMind وJigsaw لتحليل المئات من حالات إساءة الاستخدام، بهدف تحديد هذه المخاطر وتوفير دعم البيانات لاستراتيجيات أمان الذكاء الاصطناعي المستقبلية. وخلص التقرير إلى أن انتشار المعلومات الكاذبة، وخاصة جيل "Deepfakes"، أصبح أكثر تطبيقات الذكاء الاصطناعي الخبيثة شيوعا، مما يشكل تهديدا خطيرا للرأي العام والعملية السياسية.

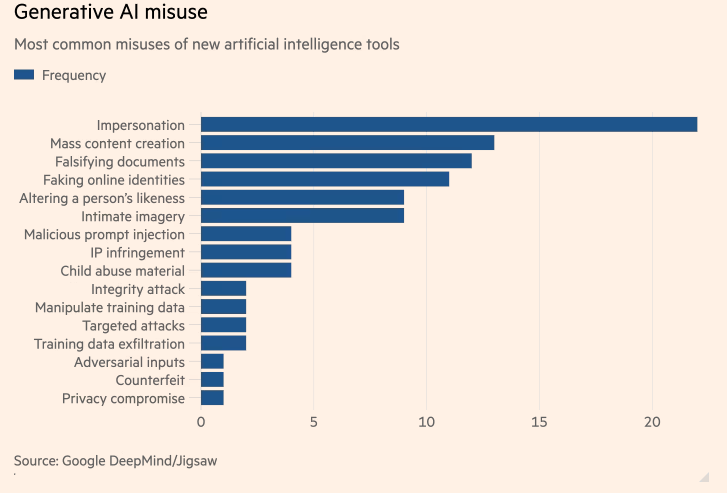

أظهرت دراسة هي الأولى من نوعها أجرتها Google DeepMind حول تطبيقات الذكاء الاصطناعي الخبيثة الأكثر شيوعًا، أن "التزييف العميق" للذكاء الاصطناعي (AI) الذي يولد سياسيين ومشاهير مزيفين، أكثر شيوعًا من محاولات استخدام الذكاء الاصطناعي لمساعدة الهجمات الإلكترونية. وتهدف الدراسة، وهي عبارة عن تعاون بين وحدة الذكاء الاصطناعي DeepMind في Google ووحدة البحث والتطوير Jigsaw التابعة لشركة Google، إلى تحديد مخاطر توليد أدوات الذكاء الاصطناعي التي جلبتها أكبر شركات التكنولوجيا في العالم إلى السوق بحثًا عن أرباح ضخمة.

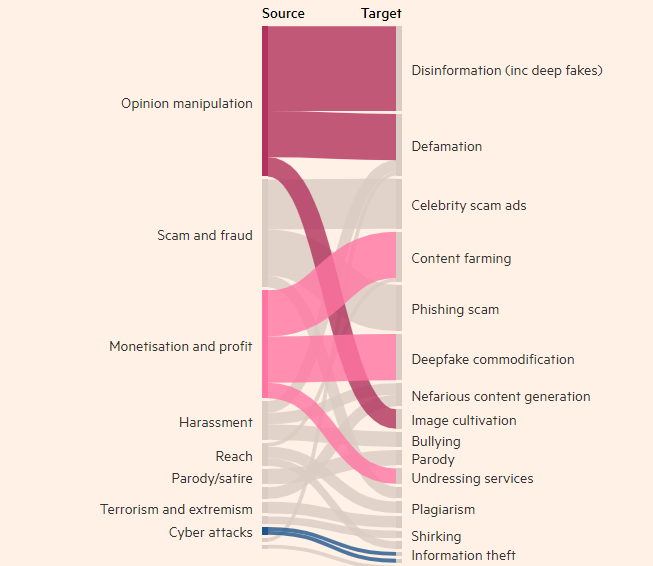

دوافع الجهات الفاعلة السيئة المتعلقة بالتكنولوجيا

وجدت الدراسة أن إنشاء صور ومقاطع فيديو ومقاطع صوتية حقيقية ولكن زائفة للأشخاص كان أكثر إساءة استخدام لأدوات الذكاء الاصطناعي التوليدية شيوعًا، وأكثر شيوعًا تقريبًا مرتين من ثاني أعلى استخدام لأدوات النص، مثل برامج الدردشة الآلية، لتزوير المعلومات مرات الهدف الأكثر شيوعًا لإساءة استخدام الذكاء الاصطناعي التوليدي هو التأثير على الرأي العام، والذي يمثل 27% من حالات الاستخدام، مما يثير المخاوف بشأن مدى تأثير التزييف العميق على الانتخابات في جميع أنحاء العالم هذا العام.

ظهرت التزييفات العميقة لرئيس الوزراء البريطاني ريشي سوناك وغيره من القادة العالميين على TikTok وX وInstagram في الأشهر الأخيرة. يتوجه الناخبون البريطانيون إلى صناديق الاقتراع في الانتخابات العامة المقررة الأسبوع المقبل. وعلى الرغم من الجهود التي تبذلها منصات التواصل الاجتماعي لتسمية مثل هذا المحتوى أو إزالته، إلا أن الناس قد لا يتعرفون عليه على أنه كاذب، وقد يؤثر انتشار المحتوى على إقبال الناخبين. قام باحثو DeepMind بتحليل ما يقرب من 200 حالة إساءة استخدام تتعلق بمنصات التواصل الاجتماعي X وReddit، بالإضافة إلى المدونات عبر الإنترنت وتقارير وسائل الإعلام عن إساءة الاستخدام.

ووجدت الدراسة أن ثاني أكبر دافع لإساءة استخدام المنتجات المولدة بالذكاء الاصطناعي، مثل ChatGPT من OpenAI وGemini من Google، كان كسب المال، سواء كان ذلك تقديم خدمات لإنشاء التزييف العميق أو استخدام الذكاء الاصطناعي المولد لإنشاء كميات كبيرة من المحتوى، مثل المحتوى المزيف. مقالات إخبارية. ووجدت الدراسة أن معظم الانتهاكات تستخدم أدوات يمكن الوصول إليها بسهولة والتي "تتطلب الحد الأدنى من الخبرة الفنية"، مما يعني أن المزيد من الجهات الفاعلة السيئة يمكنها إساءة استخدام الذكاء الاصطناعي التوليدي.

سوف تؤثر أبحاث ديب مايند على كيفية تحسين تقييمها لسلامة نماذجها، وتأمل أن يؤثر هذا أيضًا على كيفية رؤية منافسيها وأصحاب المصلحة الآخرين لـ "مظاهر الضرر".

تسليط الضوء على:

- وجدت أبحاث DeepMind أن التزييف العميق هو المشكلة الأولى لإساءة استخدام تطبيقات الذكاء الاصطناعي.

- سوء الاستخدام الأكثر شيوعًا لأدوات الذكاء الاصطناعي التوليدي هو التأثير على الرأي العام، وهو ما يمثل 27% من الاستخدامات.

- ثاني أكبر دافع لإساءة استخدام الذكاء الاصطناعي هو كسب المال، والذي يتضمن بشكل أساسي تقديم خدمات Deepfakes وإنشاء أخبار مزيفة.

يعد هذا البحث أمرًا بالغ الأهمية لفهم ومعالجة المخاطر المحتملة التي يشكلها الذكاء الاصطناعي التوليدي. تسلط نتائج أبحاث DeepMind الضوء على الحاجة إلى تطوير آليات أمنية وأطر تنظيمية أكثر فعالية لمنع الجهات الخبيثة من استخدام تكنولوجيا الذكاء الاصطناعي للقيام بأنشطة ضارة وحماية المصالح العامة وأمن المعلومات. وفي المستقبل، ستستمر أبحاث مماثلة في تعزيز التطوير الآمن لتكنولوجيا الذكاء الاصطناعي.