O Google DeepMind lançou um relatório de pesquisa inovador sobre aplicativos maliciosos de IA que revela as principais tendências no uso indevido de ferramentas generativas de IA. A investigação analisa os riscos da IA generativa em todo o mundo, especialmente as ferramentas que estão a ser lançadas no mercado por grandes empresas tecnológicas em busca de lucros enormes. As equipes de pesquisa DeepMind e Jigsaw colaboraram para analisar centenas de casos de abuso, com o objetivo de quantificar esses riscos e fornecer suporte de dados para futuras estratégias de segurança de IA. O relatório concluiu que a propagação de informações falsas, especialmente a geração de "Deepfakes", tornou-se a aplicação maliciosa de IA mais comum, representando uma séria ameaça à opinião pública e ao processo político.

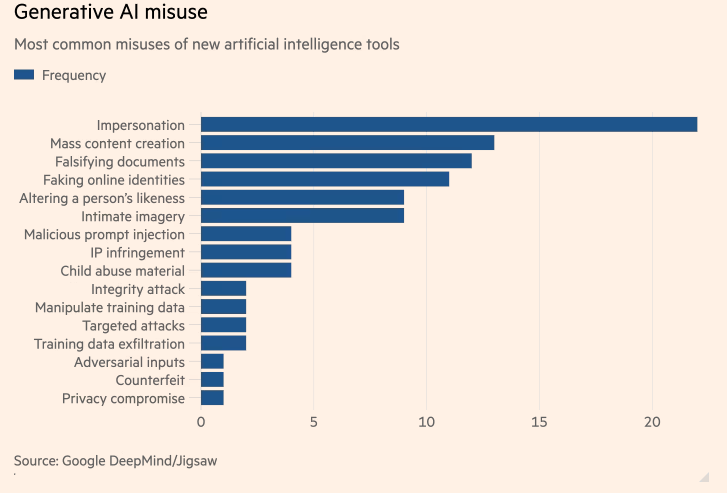

Um estudo inédito realizado pelo Google DeepMind sobre os aplicativos maliciosos de IA mais comuns mostra que “deepfakes” de inteligência artificial (IA) que geram políticos e celebridades falsos são mais comuns do que tentativas de usar IA para auxiliar ataques cibernéticos. O estudo, uma colaboração entre a unidade de IA do Google, DeepMind, e a unidade de pesquisa e desenvolvimento do Google, Jigsaw, teve como objetivo quantificar os riscos de geração de ferramentas de IA que foram trazidas ao mercado pelas maiores empresas de tecnologia do mundo em busca de enormes lucros.

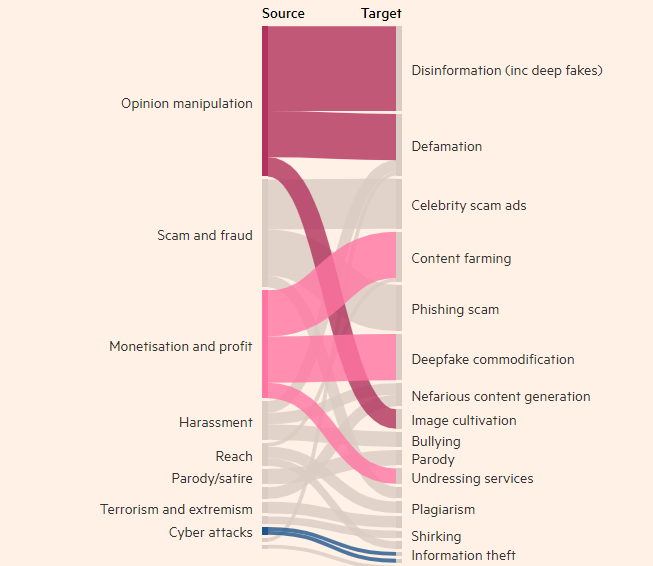

Motivos dos maus atores relacionados à tecnologia

O estudo descobriu que o ato de criar imagens, vídeos e áudio de pessoas reais, mas falsos, era o uso indevido mais comum de ferramentas generativas de IA, quase duas vezes mais comum do que o segundo maior uso de ferramentas de texto, como chatbots, falsificar informações vezes. O objetivo mais comum do uso indevido de IA generativa é influenciar a opinião pública, que representa 27% dos casos de uso, levantando preocupações sobre como os deepfakes podem influenciar as eleições em todo o mundo este ano.

Deepfakes do primeiro-ministro britânico Rishi Sunak e de outros líderes globais apareceram no TikTok, X e Instagram nos últimos meses. Os eleitores britânicos irão às urnas nas eleições gerais da próxima semana. Apesar dos esforços das plataformas de redes sociais para rotular ou remover esse tipo de conteúdo, as pessoas podem não reconhecê-lo como falso e a propagação do conteúdo pode influenciar a participação eleitoral. Os pesquisadores da DeepMind analisaram aproximadamente 200 casos de abuso envolvendo plataformas de mídia social X e Reddit, bem como blogs online e relatos de abuso na mídia.

O estudo descobriu que a segunda maior motivação para o abuso de produtos gerados por IA, como o ChatGPT da OpenAI e o Gemini do Google, era ganhar dinheiro, seja oferecendo serviços para criar deepfakes ou usando IA generativa para criar grandes quantidades de conteúdo, como falsos. artigos de notícias. O estudo descobriu que a maioria dos abusos utiliza ferramentas facilmente acessíveis que “exigem conhecimentos técnicos mínimos”, o que significa que mais agentes mal-intencionados podem abusar da IA generativa.

A investigação da DeepMind influenciará a forma como melhora a sua avaliação da segurança dos seus modelos, e espera que isto também influencie a forma como os seus concorrentes e outras partes interessadas veem a “manifestação de danos”.

Destaque:

- A pesquisa da DeepMind descobriu que os deepfakes são o problema número um no uso indevido de aplicativos de inteligência artificial.

- A utilização indevida mais comum de ferramentas de IA generativas consiste em influenciar a opinião pública, representando 27% das utilizações.

- A segunda maior motivação para abusar da IA gerada é ganhar dinheiro, o que inclui principalmente o fornecimento de serviços Deepfakes e a criação de notícias falsas.

Esta pesquisa é fundamental para compreender e abordar os riscos potenciais representados pela IA generativa. As conclusões da investigação da DeepMind destacam a necessidade de desenvolver mecanismos de segurança e quadros regulamentares mais eficazes para evitar que intervenientes mal-intencionados utilizem a tecnologia de IA para realizar atividades prejudiciais e proteger os interesses públicos e a segurança da informação. No futuro, pesquisas semelhantes continuarão a promover o desenvolvimento seguro da tecnologia de IA.