Google DeepMind telah merilis laporan penelitian inovatif tentang aplikasi AI berbahaya yang mengungkapkan tren utama penyalahgunaan alat AI generatif. Penelitian ini melihat risiko AI generatif di seluruh dunia, khususnya alat yang dipasarkan oleh perusahaan teknologi besar demi mengejar keuntungan besar. Tim peneliti DeepMind dan Jigsaw berkolaborasi untuk menganalisis ratusan kasus penyalahgunaan, yang bertujuan untuk mengukur risiko-risiko ini dan memberikan dukungan data untuk strategi keamanan AI di masa depan. Laporan tersebut menemukan bahwa penyebaran informasi palsu, terutama generasi "Deepfakes", telah menjadi aplikasi AI berbahaya yang paling umum, sehingga menimbulkan ancaman serius terhadap opini publik dan proses politik.

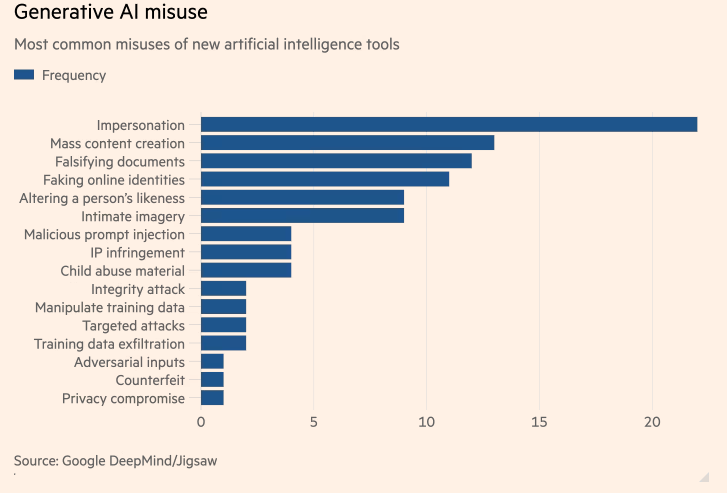

Sebuah studi pertama yang dilakukan oleh Google DeepMind mengenai aplikasi AI berbahaya yang paling umum menunjukkan bahwa "deepfake" kecerdasan buatan (AI) yang menghasilkan politisi dan selebritas palsu lebih umum terjadi dibandingkan upaya menggunakan AI untuk membantu serangan siber. Studi tersebut, yang merupakan kolaborasi antara unit AI Google DeepMind dan unit penelitian dan pengembangan Google Jigsaw, bertujuan untuk mengukur risiko pembuatan alat AI yang dibawa ke pasar oleh perusahaan teknologi terbesar di dunia untuk mencari keuntungan besar.

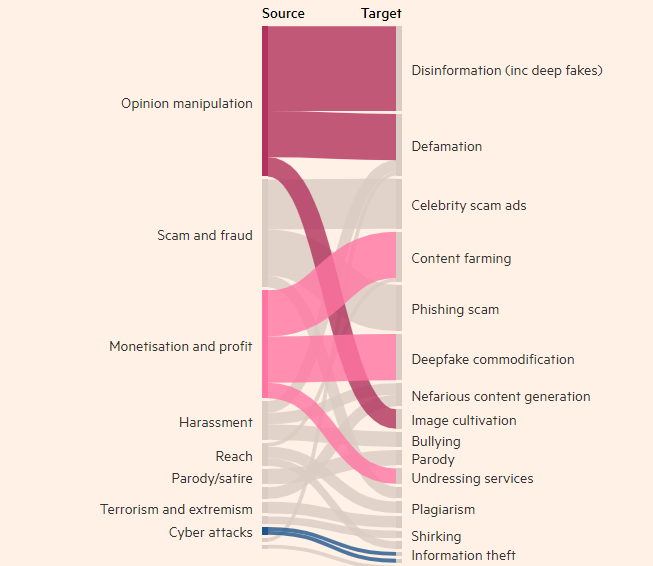

Motif pelaku kejahatan terkait teknologi

Studi ini menemukan bahwa tindakan membuat gambar, video, dan audio orang yang nyata namun palsu merupakan penyalahgunaan alat AI generatif yang paling umum, hampir dua kali lebih umum dibandingkan penggunaan alat teks tertinggi berikutnya, seperti chatbots. untuk memalsukan informasi kali. Tujuan paling umum dari penyalahgunaan AI generatif adalah untuk memengaruhi opini publik, yang mencakup 27% kasus penggunaan, sehingga meningkatkan kekhawatiran tentang bagaimana deepfake dapat memengaruhi pemilu di seluruh dunia tahun ini.

Deepfake Perdana Menteri Inggris Rishi Sunak dan para pemimpin global lainnya telah muncul di TikTok, X, dan Instagram dalam beberapa bulan terakhir. Para pemilih Inggris akan pergi ke tempat pemungutan suara pada pemilihan umum minggu depan. Meskipun ada upaya dari platform media sosial untuk memberi label atau menghapus konten tersebut, masyarakat mungkin tidak mengenalinya sebagai konten palsu, dan penyebaran konten tersebut dapat mempengaruhi jumlah pemilih. Peneliti DeepMind menganalisis sekitar 200 kasus pelecehan yang melibatkan platform media sosial X dan Reddit, serta blog online dan laporan media tentang pelecehan.

Studi ini menemukan bahwa motivasi terbesar kedua untuk menyalahgunakan produk yang dihasilkan oleh AI, seperti ChatGPT milik OpenAI dan Gemini milik Google, adalah untuk menghasilkan uang, baik dengan menawarkan layanan untuk membuat deepfake atau menggunakan AI generatif untuk membuat konten dalam jumlah besar, seperti konten palsu. artikel berita. Studi ini menemukan bahwa sebagian besar penyalahgunaan menggunakan alat yang mudah diakses dan "memerlukan sedikit keahlian teknis", yang berarti semakin banyak pelaku kejahatan yang dapat menyalahgunakan AI generatif.

Penelitian DeepMind akan memengaruhi cara mereka meningkatkan penilaian keamanan model-modelnya, dan diharapkan hal ini juga akan memengaruhi cara para pesaingnya dan pemangku kepentingan lainnya memandang “manifestasi bahaya.”

Menyorot:

- Penelitian DeepMind menemukan bahwa deepfake adalah masalah nomor satu dalam penyalahgunaan aplikasi kecerdasan buatan.

- Penyalahgunaan alat AI generatif yang paling umum adalah untuk memengaruhi opini publik, yaitu sebesar 27% dari keseluruhan penggunaan.

- Motivasi terbesar kedua dalam menyalahgunakan AI yang dihasilkan adalah untuk menghasilkan uang, yang sebagian besar mencakup penyediaan layanan Deepfakes dan pembuatan berita palsu.

Penelitian ini sangat penting untuk memahami dan mengatasi potensi risiko yang ditimbulkan oleh AI generatif. Temuan penelitian DeepMind menyoroti perlunya mengembangkan mekanisme keamanan dan kerangka peraturan yang lebih efektif untuk mencegah pelaku kejahatan menggunakan teknologi AI untuk melakukan aktivitas berbahaya dan melindungi kepentingan publik dan keamanan informasi. Di masa depan, penelitian serupa akan terus mendorong pengembangan teknologi AI yang aman.