Google DeepMind a publié un rapport de recherche révolutionnaire sur les applications d'IA malveillantes qui révèle les principales tendances en matière d'utilisation abusive des outils d'IA générative. La recherche examine les risques de l’IA générative dans le monde, en particulier les outils mis sur le marché par les grandes entreprises technologiques à la recherche d’énormes profits. Les équipes de recherche DeepMind et Jigsaw ont collaboré pour analyser des centaines de cas d'abus, dans le but de quantifier ces risques et de fournir un support de données pour les futures stratégies de sécurité de l'IA. Le rapport révèle que la diffusion de fausses informations, en particulier la génération de « Deepfakes », est devenue l'application malveillante d'IA la plus courante, représentant une menace sérieuse pour l'opinion publique et le processus politique.

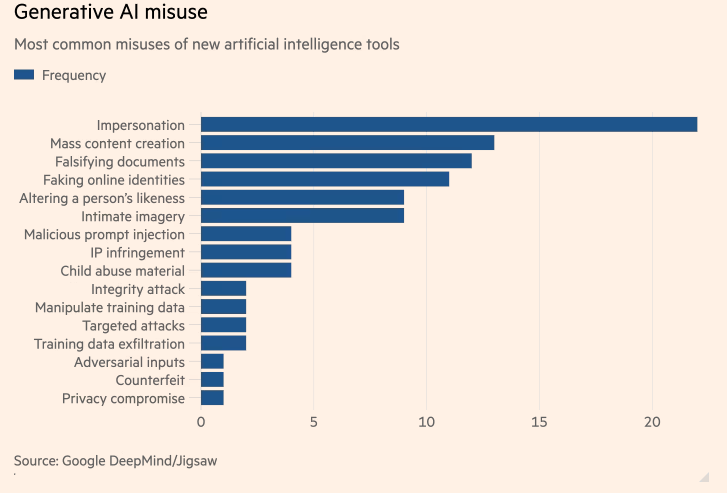

Une étude unique en son genre réalisée par Google DeepMind sur les applications malveillantes d'IA les plus courantes montre que les « deepfakes » d'intelligence artificielle (IA) qui génèrent de faux politiciens et célébrités sont plus courants que les tentatives d'utilisation de l'IA pour faciliter les cyberattaques. L'étude, une collaboration entre l'unité d'IA de Google DeepMind et l'unité de recherche et développement de Google Jigsaw, visait à quantifier les risques liés à la génération d'outils d'IA mis sur le marché par les plus grandes entreprises technologiques du monde à la recherche d'énormes profits.

Motivations des mauvais acteurs liés à la technologie

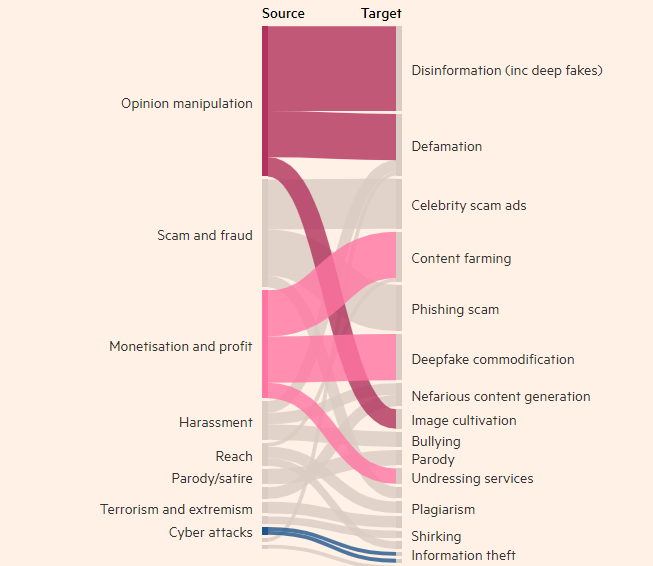

L'étude a révélé que le fait de créer des images, des vidéos et des fichiers audio réels mais faux de personnes était l'utilisation abusive la plus courante des outils d'IA générative, près de deux fois plus courante que l'utilisation suivante d'outils textuels, tels que les chatbots, pour falsifier les informations. L’objectif le plus courant de l’utilisation abusive de l’IA générative est d’influencer l’opinion publique, qui représente 27 % des cas d’utilisation, ce qui soulève des inquiétudes quant à la manière dont les deepfakes pourraient influencer les élections dans le monde cette année.

Des deepfakes du Premier ministre britannique Rishi Sunak et d’autres dirigeants mondiaux sont apparus sur TikTok, X et Instagram ces derniers mois. Les électeurs britanniques se rendront aux urnes lors des élections générales de la semaine prochaine. Malgré les efforts des plateformes de médias sociaux pour étiqueter ou supprimer ce contenu, les gens peuvent ne pas le reconnaître comme faux et la diffusion du contenu peut influencer la participation électorale. Les chercheurs de DeepMind ont analysé environ 200 cas d’abus impliquant les plateformes de médias sociaux X et Reddit, ainsi que des blogs en ligne et des rapports d’abus dans les médias.

L'étude a révélé que la deuxième motivation la plus importante pour abuser des produits générés par l'IA, tels que ChatGPT d'OpenAI et Gemini de Google, était de gagner de l'argent, qu'il s'agisse d'offrir des services pour créer des deepfakes ou d'utiliser l'IA générative pour créer de grandes quantités de contenu, comme des faux. articles de presse. L'étude a révélé que la plupart des abus utilisent des outils facilement accessibles qui « nécessitent une expertise technique minimale », ce qui signifie qu'un plus grand nombre d'acteurs malveillants peuvent abuser de l'IA générative.

Les recherches de DeepMind influenceront la manière dont elle améliore son évaluation de la sécurité de ses modèles, et elle espère que cela influencera également la façon dont ses concurrents et autres parties prenantes perçoivent la « manifestation de préjudice ».

Points forts:

- Les recherches de DeepMind ont révélé que les deepfakes constituent le problème numéro un en matière d'utilisation abusive des applications d'intelligence artificielle.

- L'utilisation abusive la plus courante des outils d'IA générative consiste à influencer l'opinion publique, représentant 27 % des utilisations.

- La deuxième motivation majeure pour abuser de l'IA générée est la recherche de revenus, ce qui comprend principalement la fourniture de services Deepfakes et la création de fausses nouvelles.

Cette recherche est essentielle pour comprendre et gérer les risques potentiels posés par l’IA générative. Les résultats des recherches de DeepMind soulignent la nécessité de développer des mécanismes de sécurité et des cadres réglementaires plus efficaces pour empêcher les acteurs malveillants d’utiliser la technologie de l’IA pour mener des activités nuisibles et protéger les intérêts publics et la sécurité des informations. À l’avenir, des recherches similaires continueront de promouvoir le développement sûr de la technologie de l’IA.