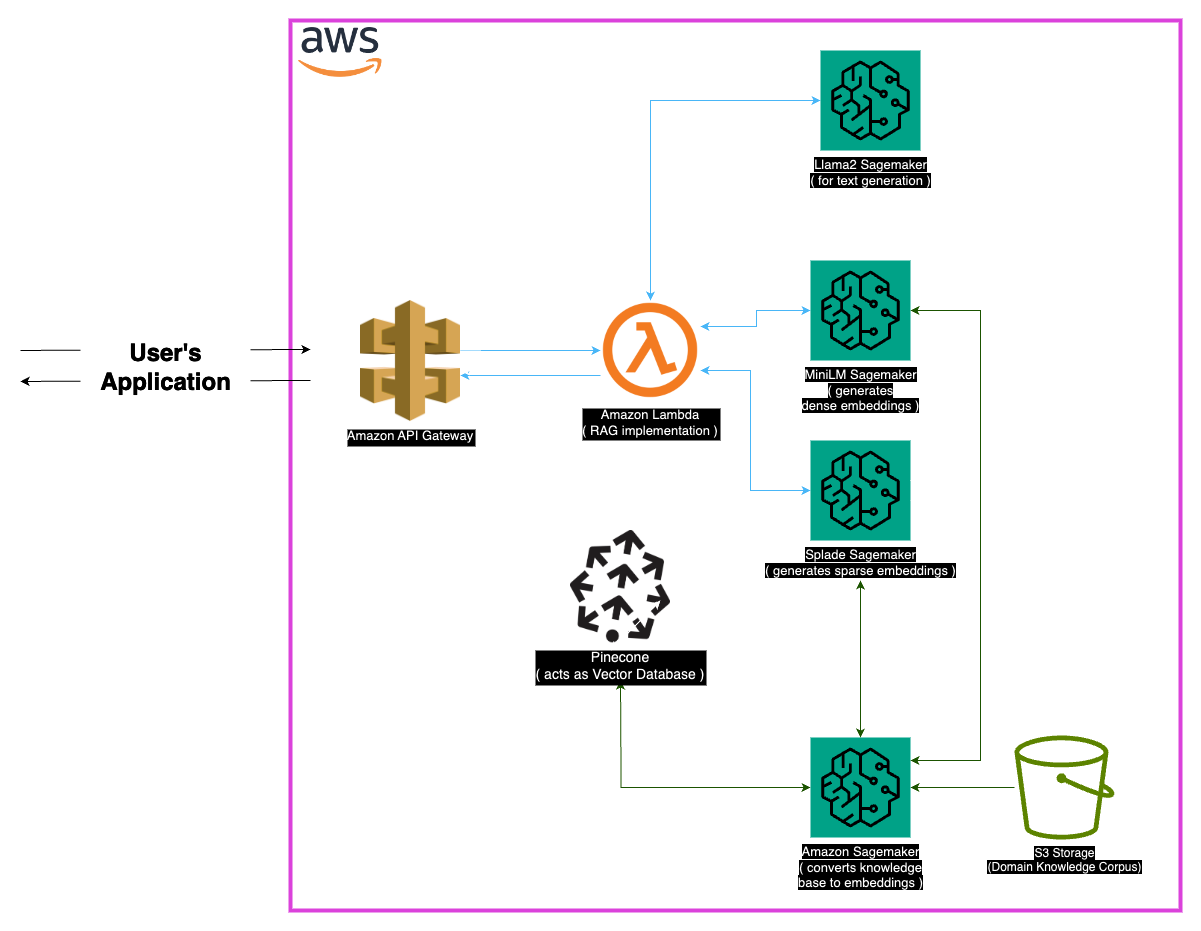

Explore Medllama-QA,這是一種由Llama-2-7B提供動力的尖端醫療詢問系統。該存儲庫利用檢索增強發電(RAG)和先進的嵌入方式,可提供精確的,上下文準確的答案,減少幻覺。 Medllama-QA憑藉Minilm,Splade,Pinecone和Sagemaker在內的強大技術堆棧,在醫療質量檢查中實現了提高的準確性和相關性,與標準語言模型相比,表現出了出色的性能。

醫療領域要求在提問系統中精確,該存儲庫提供了一個利用Llama-2-7b模型的複雜解決方案。通過檢索增強生成(RAG)方法,該系統將精選的醫學知識庫與Llama-2-7B整合在一起,從而確保上下文和醫學上準確的響應。通過利用嵌入式和薩吉酮和松果的計算能力,該模型解決了大型語言模型的挑戰,有望減少幻覺和確切的相關答案。

“ PubMed”數據集是醫學知識的龐大儲藏。鑑於模型窗口大小的局限性,塊策略將大型文本數據集分解為可管理的部分,從而使模型能夠有效地處理和理解上下文信息。

嵌入

密集的嵌入(Minilm) :由Minilm生成的文本數據的緊湊表示,為每片文本提供固定尺寸的向量,以確保均勻性。這些嵌入從醫學文本中捕獲基本信息,從而使模型可以有效地理解和處理輸入數據。

稀疏嵌入(splade) :以高維向量為特徵,其稀疏嵌入的稀疏嵌入捕獲了數據中的細微關係。這種方法使該模型能夠在醫學文本中捕獲複雜的細節,從而增強了其提供準確且相關的答案的能力。

向量商店

檢索增強產生(RAG)方法的核心在於矢量商店,該商店在存儲嵌入和促進快速檢索方面起著至關重要的作用。 Pinecone因其在管理和查詢高維矢量方面的優化而被選為抹布方法的有效性不可或缺。 Pinecone的效率可確保快速相似性搜索,並使模型能夠快速檢索與語義相關的內容。

Huggingface :利用Huggingface庫的功能來管理和微調語言模型,該項目受益於包括Llama-2-7B在內的許多預培訓模型。

Pinecone :使用Pinecone作為向量索引,可確保代表文本數據的高維向量的有效存儲,管理和查詢。它的功能在支持抹布方法方面至關重要。

Sagemaker :薩吉式製造商的計算能力是針對嵌入,檢索和整體模型開發等任務的。 SageMaker提供了一個無縫的環境,用於大規模部署和管理機器學習模型。

Llama2 :由Meta AI開發的Llama-2模型構成了該項目的基礎。 Llama-2-7B具有較大的參數大小,是醫療問題的主要生成模型。

檢索增強發電(RAG) :這種創新的方法將Llama-2-7B的固有知識與精選的醫學知識基礎相結合。密集和稀疏嵌入的整合以及可有效檢索的松果,可確保精確,相關和非凝固的響應。

考慮到醫療數據的廣泛性質,可能會出現某些邊緣情況。處理範圍超出模型訓練數據以確保准確響應的查詢至關重要。此外,系統應足夠強大,可以處理模棱兩可的查詢並提供有意義的輸出。

雖然當前的實現是強大的,但總有增強的空間。可能的改進包括完善塊策略,以更好地理解上下文理解並探索其他嵌入,以提高性能。可以納入醫學文本處理和語言模型進步的持續研究,以進一步增強系統的功能。

確保安裝以下依賴關係:

請按照以下步驟使用系統:

安裝依賴項。

MedLlama-QA.ipynb 與標準語言模型相比,該系統表現出提高的精度和幻覺的提高。精確和相關的答案是通過抹布方法產生的,使其成為醫療詢問的有價值的工具。

該項目已根據MIT許可獲得許可。

有關任何查詢,請通過[[email protected]與我聯繫。

特別感謝Meta AI的開發人員對Llama 2大型語言模型家族的貢獻。該項目以他們的工作為基礎,旨在為醫學領域中語言模型的負責任發展做出貢獻。