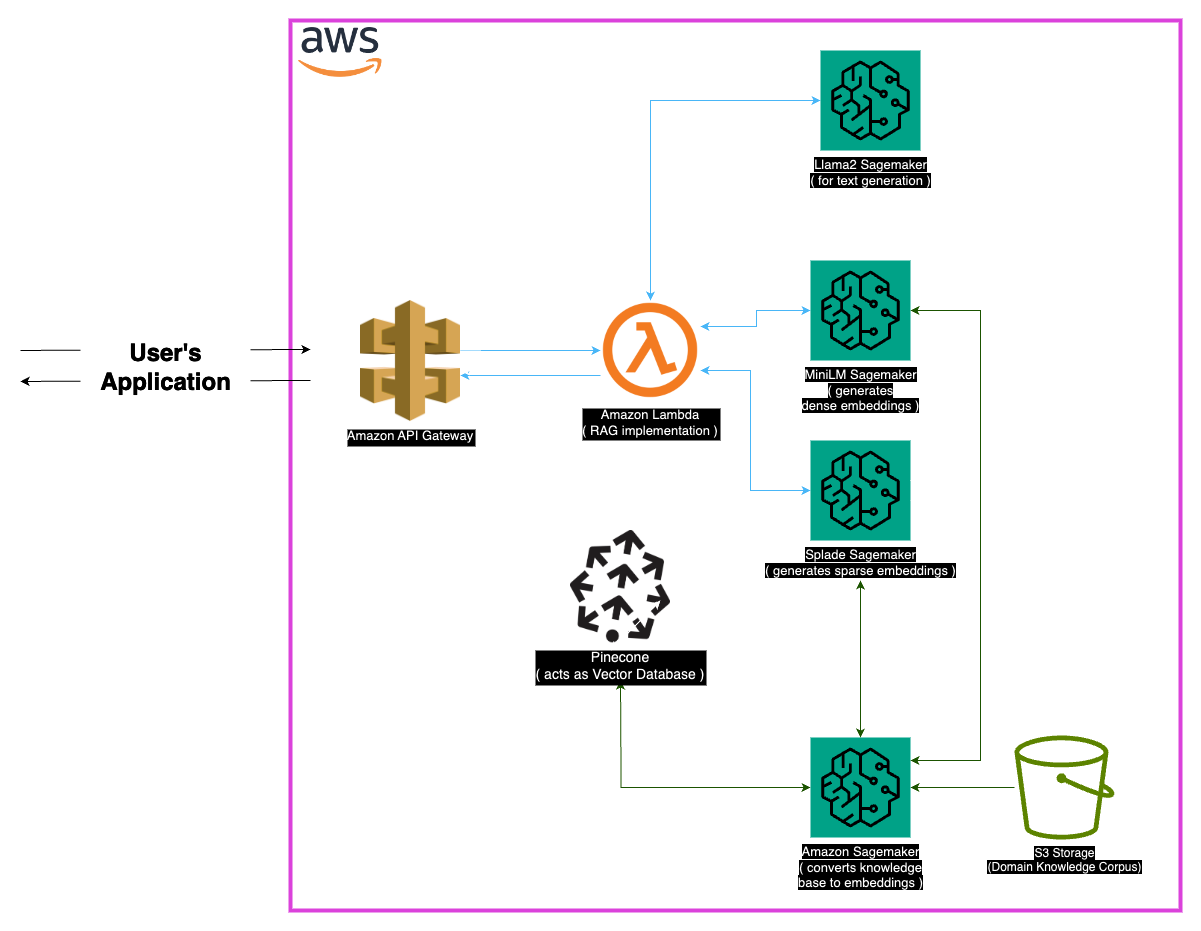

สำรวจ Medllama-Qa ระบบการตอบคำถามทางการแพทย์ที่ทันสมัยขับเคลื่อนโดย Llama-2-7B การใช้ประโยชน์จาก Generation Augmented Generation (RAG) และการฝังขั้นสูงที่เก็บนี้ให้คำตอบที่แม่นยำและแม่นยำตามบริบทลดภาพหลอน ด้วยสแต็คเทคโนโลยีที่แข็งแกร่งรวมถึง Minilm, Splade, Pinecone และ Sagemaker, Medllama-QA ได้รับความแม่นยำและความเกี่ยวข้องที่เพิ่มขึ้นใน QA การแพทย์แสดงประสิทธิภาพที่เหนือกว่าเมื่อเปรียบเทียบกับโมเดลภาษามาตรฐาน

สาขาการแพทย์ต้องการความแม่นยำในระบบการตอบคำถามและที่เก็บนี้นำเสนอโซลูชันที่ซับซ้อนซึ่งใช้ประโยชน์จากโมเดล LLAMA-2-7B ด้วยวิธีการดึง (RAG) การดึงข้อมูลระบบนี้รวมฐานความรู้ทางการแพทย์ที่ได้รับการดูแลเข้ากับ LLAMA-2-7B เพื่อให้มั่นใจว่าการตอบสนองตามบริบทและทางการแพทย์ ด้วยการใช้ประโยชน์จากการฝังและพลังการคำนวณของ Sagemaker และ Pinecone โมเดลนี้จะกล่าวถึงความท้าทายของแบบจำลองภาษาขนาดใหญ่การลดลงของภาพหลอนและคำตอบที่แม่นยำและแม่นยำ

ชุดข้อมูล 'PubMed' ทำหน้าที่เป็นอ่างเก็บน้ำที่มีความรู้ทางการแพทย์มากมาย ด้วยข้อ จำกัด ของขนาดหน้าต่างโมเดลกลยุทธ์การถ่ายทำจะแบ่งชุดข้อมูลข้อความขนาดใหญ่ออกเป็นส่วนที่จัดการได้ทำให้โมเดลสามารถประมวลผลและเข้าใจข้อมูลตามบริบทได้อย่างมีประสิทธิภาพ

การฝัง

Dense Embeddings (MINILM) : การแสดงข้อมูลขนาดกะทัดรัดของข้อมูลข้อความที่สร้างขึ้นจาก MINILM ให้เวกเตอร์ขนาดคงที่สำหรับข้อความทุกชิ้นเพื่อให้มั่นใจถึงความสม่ำเสมอ การฝังตัวเหล่านี้จับข้อมูลที่จำเป็นจากข้อความทางการแพทย์ช่วยให้แบบจำลองเข้าใจและประมวลผลข้อมูลอินพุตได้อย่างมีประสิทธิภาพ

Sparse Embeddings (splade) : โดดเด่นด้วยเวกเตอร์มิติสูงที่มีค่าเป็นศูนย์ส่วนใหญ่การฝังตัวของ Sparse Sparse จับความสัมพันธ์ที่เหมาะสมที่สุดในข้อมูล วิธีการนี้ช่วยให้แบบจำลองสามารถจับรายละเอียดที่ซับซ้อนในข้อความทางการแพทย์เพิ่มความสามารถในการให้คำตอบที่ถูกต้องและเกี่ยวข้องกับบริบท

ร้านค้าเวกเตอร์

แกนหลักของวิธีการดึง (RAG) การดึง (RAG) อยู่ในร้านค้าเวกเตอร์ซึ่งมีบทบาทสำคัญในการจัดเก็บการฝังและอำนวยความสะดวกในการดึงข้อมูลอย่างรวดเร็ว Pinecone ซึ่งได้รับการคัดเลือกสำหรับการเพิ่มประสิทธิภาพในการจัดการและสอบถามเวกเตอร์มิติสูงเป็นส่วนประกอบสำคัญของประสิทธิภาพของวิธี RAG ประสิทธิภาพของ Pinecone ทำให้มั่นใจได้ว่าการค้นหาความคล้ายคลึงกันอย่างรวดเร็วและช่วยให้โมเดลสามารถดึงเนื้อหาที่เกี่ยวข้องกับความหมายได้อย่างรวดเร็ว

HuggingFace : ใช้ประโยชน์จากความสามารถของ LuggingFace Library สำหรับการจัดการและการปรับแต่งรูปแบบภาษาโครงการนี้ได้รับประโยชน์จากแบบจำลองที่ผ่านการฝึกอบรมมาก่อนรวมถึง LLAMA-2-7B

Pinecone : การใช้ pinecone เป็นดัชนีเวกเตอร์ทำให้มั่นใจได้ว่าการจัดเก็บการจัดการและการสืบค้นของเวกเตอร์มิติสูงที่แสดงถึงข้อมูลข้อความ ความสามารถของมันเป็นหัวใจสำคัญในการสนับสนุนวิธีการ RAG

Sagemaker : ความกล้าหาญในการคำนวณของ Sagemaker นั้นได้รับการควบคุมสำหรับงานต่าง ๆ เช่นการสร้างการฝังการดึงและการพัฒนาแบบจำลองโดยรวม Sagemaker ให้สภาพแวดล้อมที่ราบรื่นสำหรับการปรับใช้และการจัดการรูปแบบการเรียนรู้ของเครื่องในระดับ

LLAMA2 : โมเดล LLAMA-2 พัฒนาโดย Meta AI เป็นรากฐานของโครงการนี้ LLAMA-2-7B ที่มีขนาดพารามิเตอร์ขนาดใหญ่ทำหน้าที่เป็นรูปแบบการกำเนิดหลักสำหรับการตอบคำถามทางการแพทย์

Retrieval Augmented Generation (RAG) : วิธีการที่เป็นนวัตกรรมนี้ผสมผสานความรู้โดยธรรมชาติของ Llama-2-7B กับฐานความรู้ทางการแพทย์ที่ได้รับการดูแล การบูรณาการของการฝังที่หนาแน่นและเบาบางพร้อมกับ pinecone เพื่อการดึงที่มีประสิทธิภาพทำให้มั่นใจได้ว่าการตอบสนองที่แม่นยำมีความเกี่ยวข้องและไม่ได้รับการตอบสนอง

เมื่อพิจารณาถึงลักษณะที่กว้างขวางของข้อมูลทางการแพทย์บางกรณีอาจเกิดขึ้น จำเป็นอย่างยิ่งที่จะต้องจัดการกับข้อสงสัยที่อยู่นอกข้อมูลการฝึกอบรมของโมเดลเพื่อให้แน่ใจว่าการตอบสนองที่แม่นยำ นอกจากนี้ระบบควรมีความแข็งแกร่งพอที่จะจัดการกับการสืบค้นที่คลุมเครือและให้ผลลัพธ์ที่มีความหมาย

ในขณะที่การใช้งานปัจจุบันมีความแข็งแกร่ง แต่ก็มีที่ว่างสำหรับการปรับปรุงเสมอ การปรับปรุงที่เป็นไปได้รวมถึงการปรับแต่งกลยุทธ์ chunking เพื่อความเข้าใจบริบทที่ดีขึ้นและสำรวจการฝังตัวเพิ่มเติมเพื่อประสิทธิภาพที่ดีขึ้น การวิจัยอย่างต่อเนื่องในการประมวลผลข้อความทางการแพทย์และความก้าวหน้าในรูปแบบภาษาสามารถรวมเข้าด้วยกันเพื่อเพิ่มขีดความสามารถของระบบ

ตรวจสอบให้แน่ใจว่ามีการติดตั้งการพึ่งพาต่อไปนี้:

ทำตามขั้นตอนเหล่านี้เพื่อใช้ระบบ:

ติดตั้งการพึ่งพา

MedLlama-QA.ipynb ระบบแสดงให้เห็นถึงความแม่นยำที่ดีขึ้นและลดภาพหลอนเมื่อเทียบกับแบบจำลองภาษามาตรฐาน คำตอบที่แม่นยำและเกี่ยวข้องถูกสร้างขึ้นผ่านวิธีการ RAG ทำให้เป็นเครื่องมือที่มีค่าในการตอบคำถามทางการแพทย์

โครงการนี้ได้รับใบอนุญาตภายใต้ใบอนุญาต MIT

สำหรับข้อสงสัยใด ๆ โปรดติดต่อฉันที่ [[email protected]]

ขอขอบคุณเป็นพิเศษสำหรับนักพัฒนาที่ Meta AI สำหรับการมีส่วนร่วมของพวกเขาในครอบครัว Llama 2 แบบจำลองภาษาขนาดใหญ่ โครงการนี้สร้างขึ้นจากการทำงานของพวกเขาโดยมีวัตถุประสงค์เพื่อมีส่วนร่วมในการพัฒนาแบบจำลองภาษาที่รับผิดชอบในโดเมนทางการแพทย์