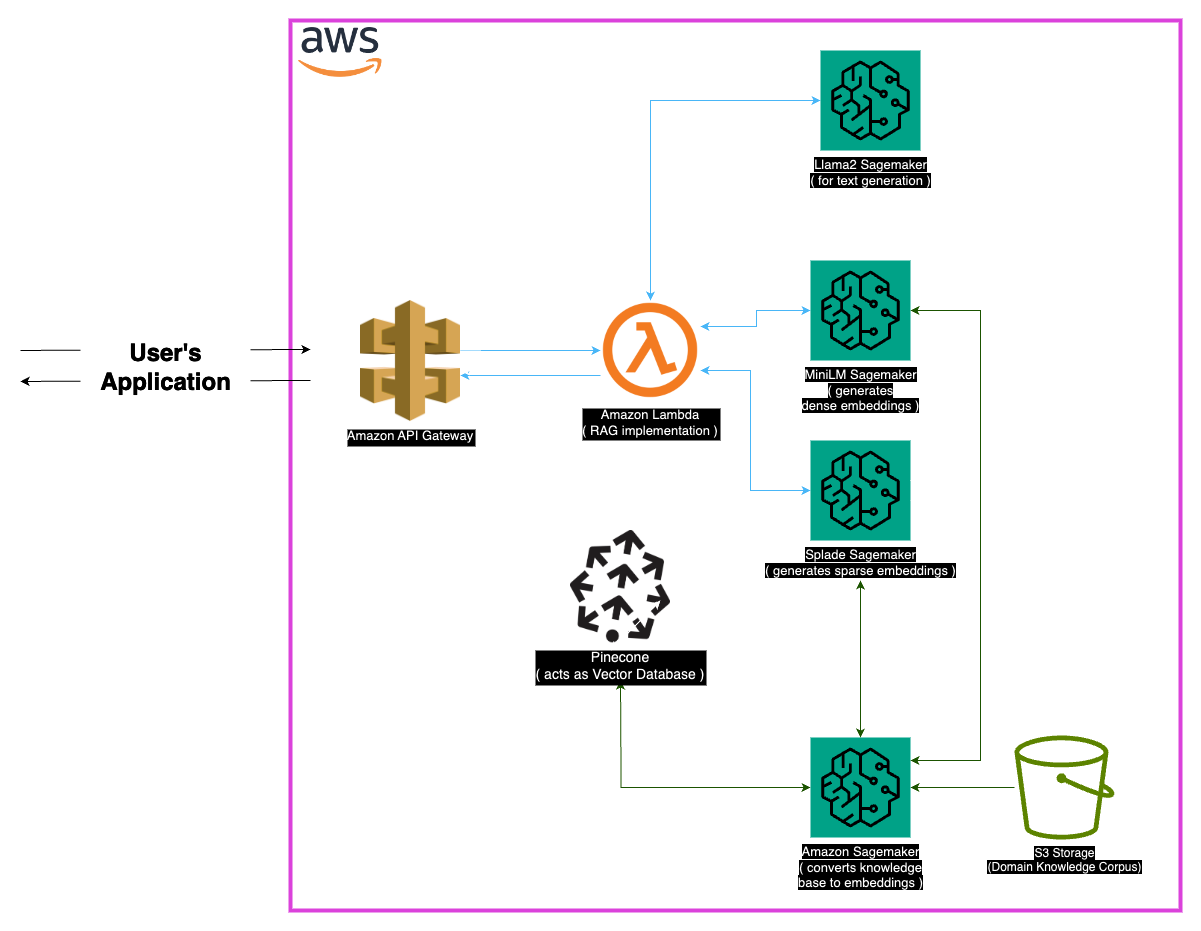

LLAMA-2-7B로 구동되는 최첨단 의료 질문 응답 시스템 인 Medllama-QA를 탐색하십시오. 이 저장소는 검색 증강 생성 (RAG) 및 고급 임베딩을 활용하여 정확하고 맥락 적으로 정확한 답변을 제공하여 환각을 줄입니다. Medllama-QA는 Minilm, Splade, Pinecone 및 Sagemaker를 포함한 강력한 기술 스택을 통해 의료 QA의 정확도와 관련성을 높여 표준 언어 모델에 비해 우수한 성능을 보여줍니다.

의료 분야는 질문 응답 시스템의 정밀도를 요구하며,이 저장소는 LLAMA-2-7B 모델을 활용하는 정교한 솔루션을 제시합니다. 이 시스템은 검색 증강 생성 (RAG) 접근법을 통해 선별 된 의료 지식 기반을 LLAMA-2-7B와 통합하여 상황에 따라 의학적으로 정확한 반응을 보장합니다. 이 모델은 삽입과 Sagemaker 및 Pinecone의 계산 능력을 활용함으로써 큰 언어 모델의 과제를 해결하여 환각 감소와 정확한 관련 답변을 약속합니다.

'PubMed'데이터 세트는 의료 지식의 방대한 저수지 역할을합니다. 모델 윈도우 크기의 한계를 고려할 때 청킹 전략은 대형 텍스트 데이터 세트를 관리 가능한 부분으로 나누어 모델이 상황에 맞는 정보를 효과적으로 처리하고 이해할 수있게합니다.

임베딩

밀집된 임베딩 (Minilm) : Minilm에서 생성 된 텍스트 데이터의 소형 표현은 모든 텍스트에 대해 고정 크기 벡터를 제공하여 균일 성을 보장합니다. 이 임베딩은 의료 텍스트에서 필수 정보를 캡처하여 모델이 입력 데이터를 효과적으로 이해하고 처리 할 수 있도록합니다.

스파스 임베딩 (Splade) : 대부분의 값이없는 고차원 벡터로 특징 지어지며, Splade의 드문 임베드는 데이터에서 미묘한 관계를 캡처합니다. 이 접근법을 통해 모델은 의료 텍스트에서 복잡한 세부 사항을 캡처하여 정확하고 상황에 맞는 답변을 제공 할 수있는 능력을 향상시킬 수 있습니다.

벡터 스토어

검색 증강 생성 (RAG) 접근법의 핵심은 벡터 스토어에 있으며, 이는 임베딩을 저장하고 빠른 검색을 촉진하는 데 중요한 역할을합니다. 고차원 벡터를 관리하고 쿼리하는 데 최적화를 위해 선택된 PENECONE은 RAG 접근의 효과에 필수적입니다. PENECONE의 효율성은 빠른 유사성 검색을 보장하고 모델이 의미 적으로 관련된 콘텐츠를 빠르게 검색 할 수 있도록합니다.

Huggingface : 언어 모델을 관리하고 미세 조정하기위한 Huggingface 라이브러리의 기능을 활용 하여이 프로젝트는 LLAMA-2-7B를 포함한 풍부한 미리 훈련 된 모델의 이점을 얻습니다.

PENECONE : 벡터 인덱스로 PENECONE을 사용하면 텍스트 데이터를 나타내는 고차원 벡터의 효율적인 저장, 관리 및 쿼리를 보장합니다. 그 기능은 헝겊 접근법을 지원하는 데 중추적입니다.

SAGEMAKER : SAGEMAKER의 계산 능력은 임베딩 생성, 검색 및 전반적인 모델 개발과 같은 작업에 활용됩니다. Sagemaker는 기계 학습 모델을 규모로 배포하고 관리하기위한 완벽한 환경을 제공합니다.

LLAMA2 : Meta AI가 개발 한 LLAMA-2 모델은이 프로젝트의 기초를 형성합니다. 매개 변수 크기가 큰 LLAMA-2-7B는 의료 질문 응답을위한 주요 생성 모델 역할을합니다.

검색 증강 생성 (RAG) :이 혁신적인 접근법은 LLAMA-2-7B의 고유 한 지식과 선별 된 의료 지식 기반을 결합합니다. 효율적인 검색을 위해 고밀고 희소 한 임베딩의 통합은 정확하고 관련성 있고 비 균열 된 반응을 보장합니다.

의료 데이터의 광범위한 특성을 고려하면 특정 모서리 사례가 발생할 수 있습니다. 정확한 응답을 보장하기 위해 모델의 교육 데이터를 벗어난 쿼리를 처리해야합니다. 또한이 시스템은 모호한 쿼리를 처리하고 의미있는 출력을 제공 할 수있을 정도로 강력해야합니다.

현재 구현은 강력하지만 항상 향상의 여지가 있습니다. 가능한 개선으로는 상황에 맞는 이해를 높이기위한 청킹 전략을 정제하고 성능 향상을위한 추가 임베드를 탐색하는 것이 포함됩니다. 의료 텍스트 처리 및 언어 모델의 발전에 대한 지속적인 연구를 통합하여 시스템의 기능을 더욱 향상시킬 수 있습니다.

다음 종속성이 설치되었는지 확인하십시오.

다음 단계에 따라 시스템을 사용하십시오.

종속성을 설치하십시오.

MedLlama-QA.ipynb 를 실행하십시오 이 시스템은 표준 언어 모델에 비해 개선 된 정확도와 환각 감소를 나타냅니다. 정확하고 관련된 답변은 Rag 접근법을 통해 생성되므로 의학적 질문 응답에서 귀중한 도구가됩니다.

이 프로젝트는 MIT 라이센스에 따라 라이센스가 부여됩니다.

문의 사항은 [[email protected]]으로 저에게 연락하십시오.

Llama 2 대형 언어 모델 제품군에 대한 기여에 대해 Meta AI의 개발자들에게 특별한 감사를드립니다. 이 프로젝트는 의료 영역에서 언어 모델의 책임있는 개발에 기여하기 위해 그들의 작업을 기반으로합니다.