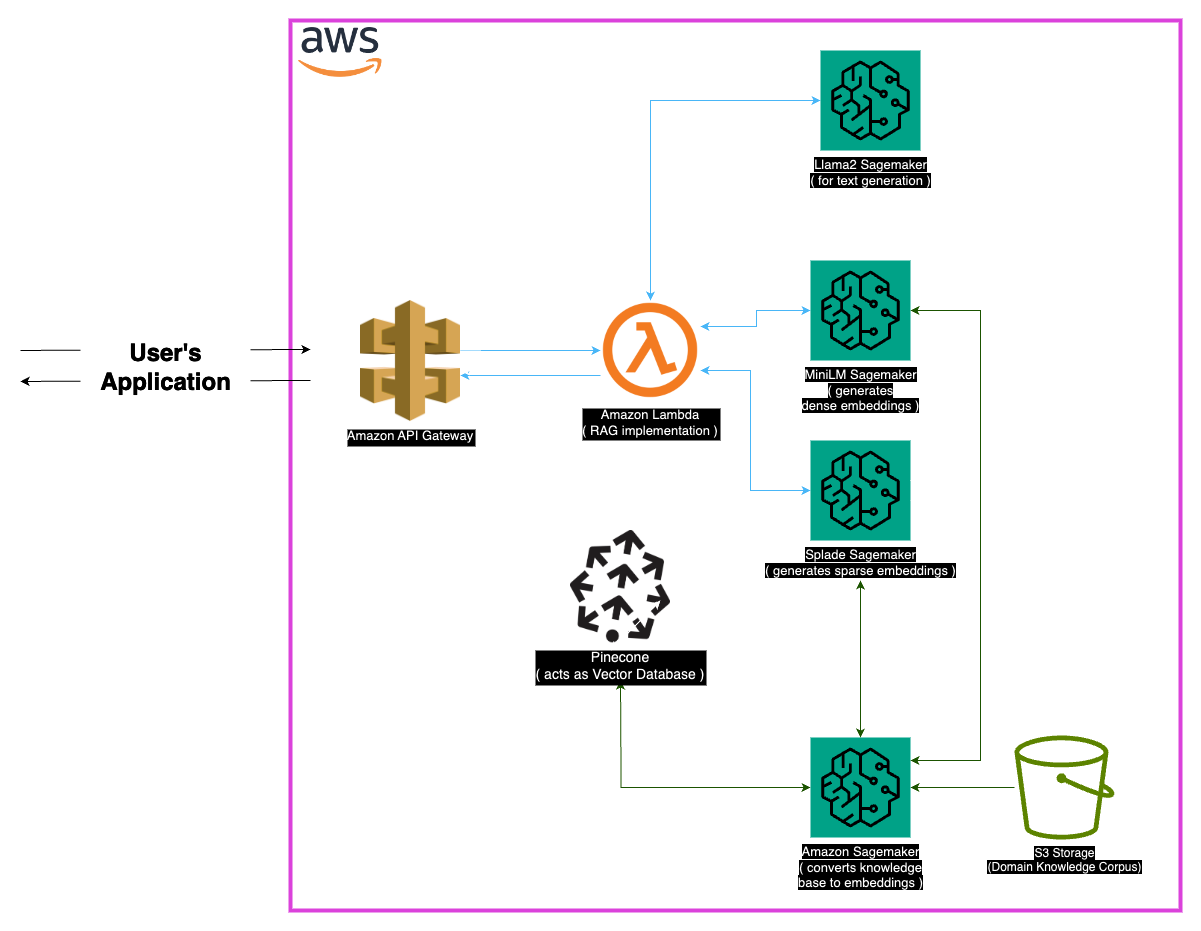

Исследуйте Medllama-QA, передовую систему медицинской помощи, управляемую Llama-2-7B. Используя извлечение дополненного генерации (RAG) и передовых встраиваний, этот репозиторий предоставляет точные, контекстуально точные ответы, уменьшая галлюцинации. С помощью надежного технического стека, включая Minilm, Splade, Pinecone и Sagemaker, Medllama-QA достигает повышенной точности и актуальности в медицинском капитале, демонстрируя превосходную производительность по сравнению со стандартными языковыми моделями.

Медицинская область требует точности в вопросительных системах, и в этом хранилище представлено сложное решение, использующее модель Llama-2-7B. Благодаря подходу к извлечению дополненного поколения (RAG) эта система интегрирует кураторскую базу медицинских знаний с Llama-2-7B, обеспечивая контекстуальные и медицинские реакции. Используя встраиваемые и вычислительную силу Sagemaker и Pinecone, эта модель решает проблемы крупных языковых моделей, обещающих уменьшенные галлюцинации и точные, соответствующие ответы.

Набор данных «PubMed» служит обширным резервуаром медицинских знаний. Учитывая ограничения размеров моделей, стратегия поднятия разбивает большие наборы текстовых данных на управляемые части, позволяя модели эффективно обрабатывать и понимать контекстную информацию.

Внедрения

Плотные встраивания (MINILM) : компактные представления текстовых данных, сгенерированные из MINILM, обеспечивают векторы фиксированного размера для каждого фрагмента текста, обеспечивая однородность. Эти встраиваемые встраиваемые снимают важную информацию из медицинских текстов, позволяя модели эффективно понимать и обрабатывать входные данные.

Sparse Entgeddings (Splade) : характеризуется высокоразмерными векторами с в основном нулевыми значениями, Sparse Sparse Entgeddings захватывает нюансированные отношения в данных. Этот подход позволяет модели захватить сложные детали в медицинских текстах, улучшая ее способность предоставлять точные и контекстуально релевантные ответы.

Векторный магазин

Ядро подхода из поиска дополненного поколения (RAG) заключается в векторном магазине, который играет решающую роль в хранении вторжений и облегчении быстрого поиска. Pinecone, выбранный для его оптимизации в управлении и запросе высокоразмерных векторов, является неотъемлемой частью эффективности подхода RAG. Эффективность PineCone обеспечивает быстрый поиск сходства и позволяет модели быстро извлекать семантически связанный контент.

Huggingface : Использование возможностей библиотеки Huggingface для управления и тонкой настройки языковых моделей, этот проект выигрывает от множества предварительно обученных моделей, включая Llama-2-7B.

Pinecone : использование Pinecone в качестве векторного индекса обеспечивает эффективное хранение, управление и запросы высокоразмерных векторов, представляющих текстовые данные. Его возможности имеют ключевую роль в поддержке подхода Rag.

SageMaker : вычислительное мастерство SageMaker используется для таких задач, как встраивание генерации, поиск и общая разработка модели. SageMaker предоставляет бесшовную среду для развертывания и управления моделями машинного обучения в масштабе.

Llama2 : модель Llama-2, разработанная Meta AI, является основой этого проекта. Llama-2-7B с большим размером параметров служит основной генеративной моделью для медицинского ответа.

Поиск дополненного поколения (RAG) : Этот инновационный подход сочетает в себе присущие знания Llama-2-7B с кураторской базой медицинских знаний. Интеграция плотных и разреженных встраиваний, наряду с Pinecone для эффективного поиска, обеспечивает точные, актуальные и не галлизированные ответы.

Учитывая обширный характер медицинских данных, могут возникнуть определенные случаи краев. Очень важно обрабатывать запросы, которые выходят за пределы учебных данных модели, чтобы обеспечить точные ответы. Кроме того, система должна быть достаточно надежной, чтобы обработать неоднозначные запросы и обеспечить значимые результаты.

Хотя текущая реализация является надежной, всегда есть место для улучшения. Возможные улучшения включают в себя уточнение стратегии обучения для лучшего контекстного понимания и изучение дополнительных встроенных встроений для повышения производительности. Постоянные исследования в области обработки медицинской текстовой обработки и достижений в языковых моделях могут быть включены для дальнейшего расширения возможностей системы.

Убедитесь, что следующие зависимости установлены:

Следуйте этим шагам, чтобы использовать систему:

Установить зависимости.

MedLlama-QA.ipynb Система демонстрирует улучшенную точность и снижение галлюцинаций по сравнению со стандартными языковыми моделями. Точные и соответствующие ответы генерируются с помощью подхода RAG, что делает его ценным инструментом в области медицинского ответа.

Этот проект лицензирован по лицензии MIT.

Для любых запросов, пожалуйста, свяжитесь со мной по адресу [[email protected]].

Особая благодарность разработчикам в Meta AI за их вклад в семейство Llama 2 крупных языковых моделей. Этот проект основан на их работе, направленная на то, чтобы внести свой вклад в ответственное развитие языковых моделей в медицинской области.