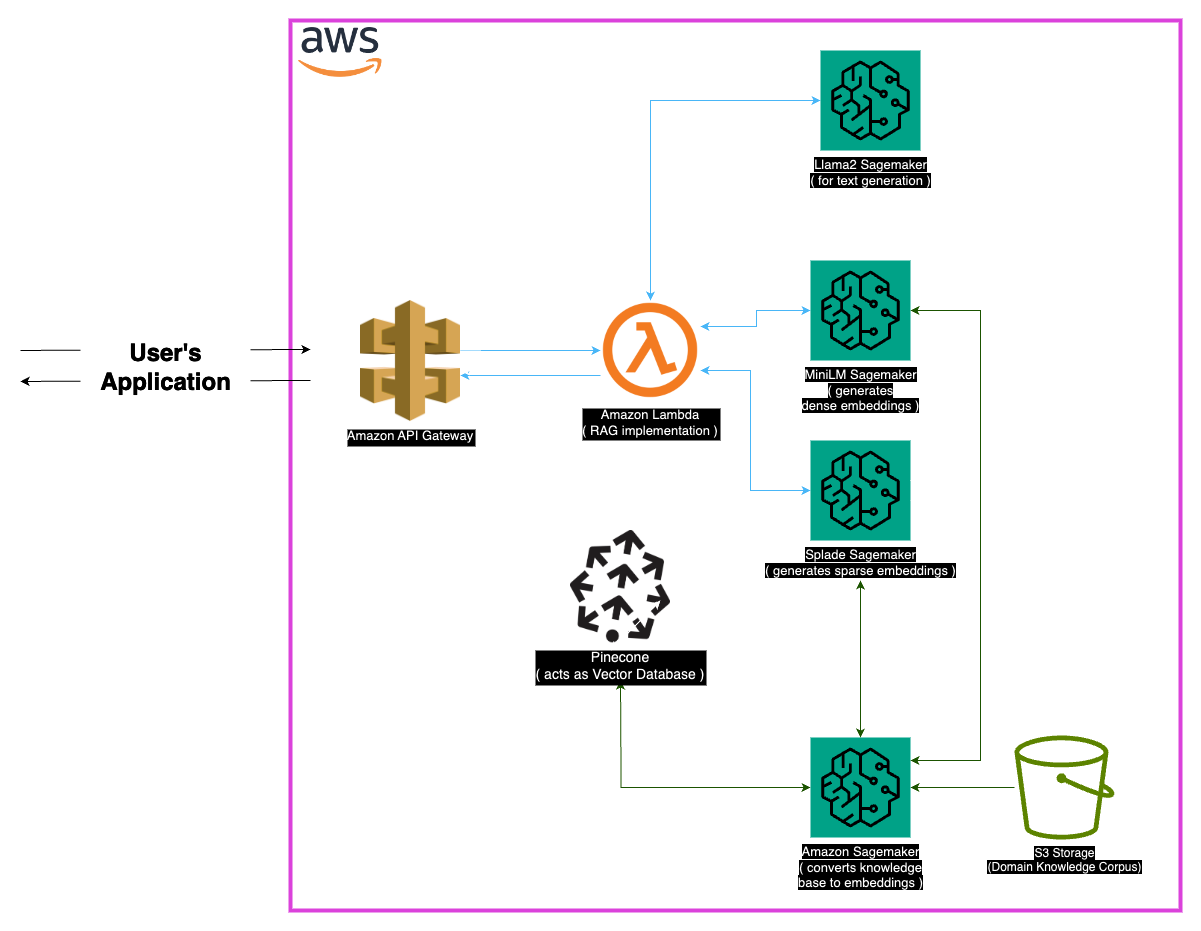

Explore Medllama-QA,这是一种由Llama-2-7B提供动力的尖端医疗询问系统。该存储库利用检索增强发电(RAG)和先进的嵌入方式,可提供精确的,上下文准确的答案,减少幻觉。 Medllama-QA凭借Minilm,Splade,Pinecone和Sagemaker在内的强大技术堆栈,在医疗质量检查中实现了提高的准确性和相关性,与标准语言模型相比,表现出了出色的性能。

医疗领域要求在提问系统中精确,该存储库提供了一个利用Llama-2-7b模型的复杂解决方案。通过检索增强生成(RAG)方法,该系统将精选的医学知识库与Llama-2-7B整合在一起,从而确保上下文和医学上准确的响应。通过利用嵌入式和萨吉酮和松果的计算能力,该模型解决了大型语言模型的挑战,有望减少幻觉和确切的相关答案。

“ PubMed”数据集是医学知识的庞大储藏。鉴于模型窗口大小的局限性,块策略将大型文本数据集分解为可管理的部分,从而使模型能够有效地处理和理解上下文信息。

嵌入

密集的嵌入(Minilm) :由Minilm生成的文本数据的紧凑表示,为每片文本提供固定尺寸的向量,以确保均匀性。这些嵌入从医学文本中捕获基本信息,从而使模型可以有效地理解和处理输入数据。

稀疏嵌入(splade) :以高维向量为特征,其稀疏嵌入的稀疏嵌入捕获了数据中的细微关系。这种方法使该模型能够在医学文本中捕获复杂的细节,从而增强了其提供准确且相关的答案的能力。

向量商店

检索增强产生(RAG)方法的核心在于矢量商店,该商店在存储嵌入和促进快速检索方面起着至关重要的作用。 Pinecone因其在管理和查询高维矢量方面的优化而被选为抹布方法的有效性不可或缺。 Pinecone的效率可确保快速相似性搜索,并使模型能够快速检索与语义相关的内容。

Huggingface :利用Huggingface库的功能来管理和微调语言模型,该项目受益于包括Llama-2-7B在内的许多预培训模型。

Pinecone :使用Pinecone作为向量索引,可确保代表文本数据的高维向量的有效存储,管理和查询。它的功能在支持抹布方法方面至关重要。

Sagemaker :萨吉式制造商的计算能力是针对嵌入,检索和整体模型开发等任务的。 SageMaker提供了一个无缝的环境,用于大规模部署和管理机器学习模型。

Llama2 :由Meta AI开发的Llama-2模型构成了该项目的基础。 Llama-2-7B具有较大的参数大小,是医疗问题的主要生成模型。

检索增强发电(RAG) :这种创新的方法将Llama-2-7B的固有知识与精选的医学知识基础相结合。密集和稀疏嵌入的整合以及可有效检索的松果,可确保精确,相关和非凝固的响应。

考虑到医疗数据的广泛性质,可能会出现某些边缘情况。处理范围超出模型训练数据以确保准确响应的查询至关重要。此外,系统应足够强大,可以处理模棱两可的查询并提供有意义的输出。

虽然当前的实现是强大的,但总有增强的空间。可能的改进包括完善块策略,以更好地理解上下文理解并探索其他嵌入,以提高性能。可以纳入医学文本处理和语言模型进步的持续研究,以进一步增强系统的功能。

确保安装以下依赖关系:

请按照以下步骤使用系统:

安装依赖项。

MedLlama-QA.ipynb 与标准语言模型相比,该系统表现出提高的精度和幻觉的提高。精确和相关的答案是通过抹布方法产生的,使其成为医疗询问的有价值的工具。

该项目已根据MIT许可获得许可。

有关任何查询,请通过[[email protected]与我联系。

特别感谢Meta AI的开发人员对Llama 2大型语言模型家族的贡献。该项目以他们的工作为基础,旨在为医学领域中语言模型的负责任发展做出贡献。