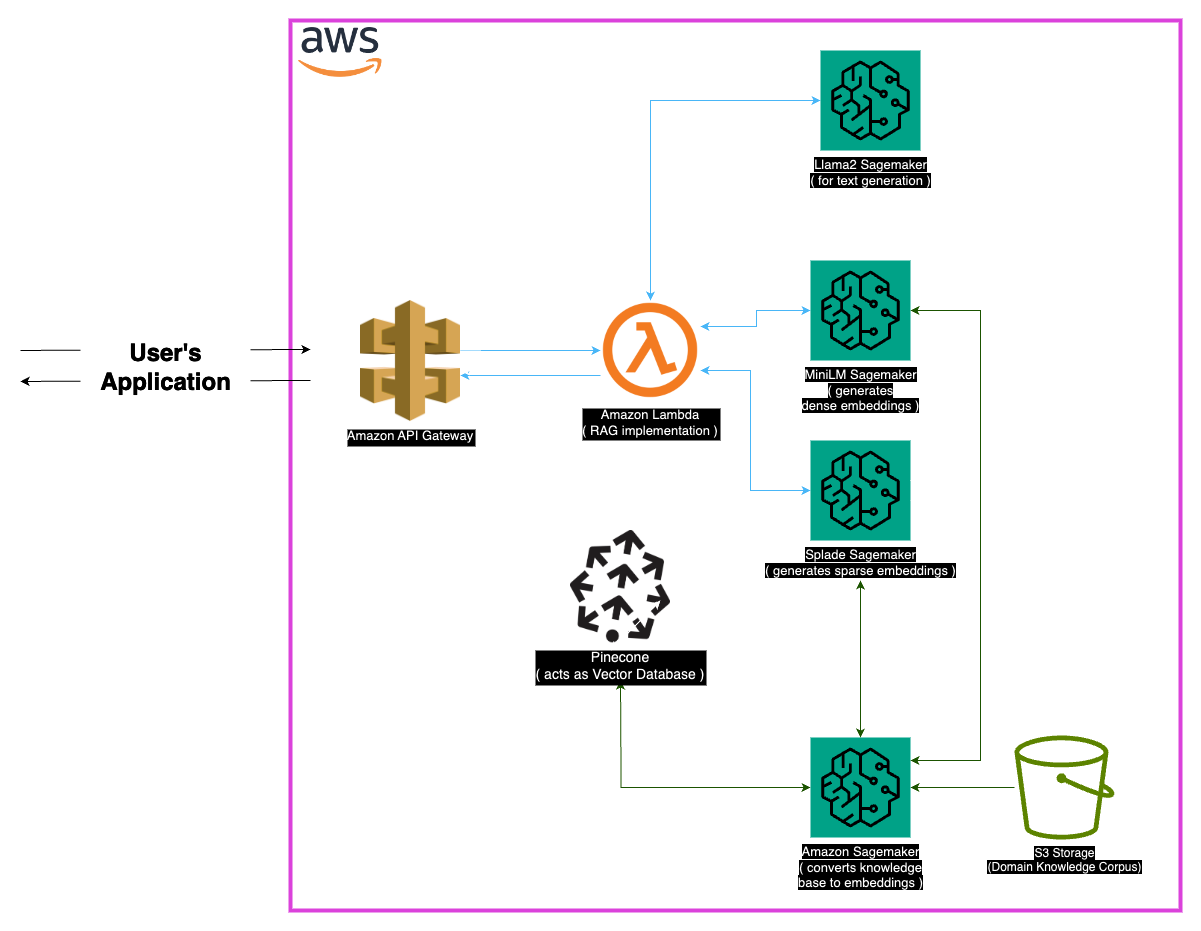

Llama-2-7bを搭載した最先端の医療質問システムであるMedllama-Qaを探索してください。検索拡張生成(RAG)と高度な埋め込みを活用するこのリポジトリは、正確で文脈的に正確な回答を提供し、幻覚を減らします。 Minilm、Splade、Pinecone、Sagemakerを含む堅牢な技術スタックを使用して、Medllama-QAは医療QAの精度と関連性の向上を実現し、標準的な言語モデルと比較して優れた性能を示します。

医療分野は、問題を回避するシステムの精度を必要とし、このリポジトリはLlama-2-7Bモデルを活用する洗練されたソリューションを提示します。検索拡張生成(RAG)アプローチを通じて、このシステムはキュレーションされた医療知識ベースをLlama-2-7Bと統合し、文脈的かつ医学的に正確な応答を確保します。このモデルは、埋め込みとセージメーカーとPineconeの計算能力を利用することにより、大規模な言語モデルの課題に対処し、幻覚と関連する正確で関連する回答を約束します。

「PubMed」データセットは、医学的知識の膨大な貯水池として機能します。モデルウィンドウサイズの制限を考えると、チャンク戦略により、大きなテキストデータセットを管理可能な部分に分解し、モデルがコンテキスト情報を効果的に処理および理解できるようにします。

埋め込み

密な埋め込み(ミニルム) :ミニルムから生成されたテキストデータのコンパクトな表現は、すべてのテキストに固定サイズのベクトルを提供し、均一性を確保します。これらの埋め込みは、医療テキストから重要な情報をキャプチャし、モデルが入力データを効果的に理解して処理できるようにします。

スパース埋め込み(Splade) :ほとんどゼロ値を持つ高次元ベクトルを特徴とするSpladeのスパース埋め込みは、データの微妙な関係をキャプチャします。このアプローチにより、モデルは医療テキストの複雑な詳細をキャプチャし、正確で文脈的に関連する回答を提供する能力を高めることができます。

ベクトルストア

検索拡張生成(RAG)アプローチの中核は、ベクターストアにあり、埋め込みを保存し、迅速な検索を促進する上で重要な役割を果たします。 Pineconeは、高次元ベクトルの管理と照会に最適化するために選択され、RAGアプローチの有効性に不可欠です。 Pineconeの効率により、類似性の迅速な検索が保証され、モデルが意味的に関連するコンテンツを迅速に取得できるようにします。

Huggingface :Huggingface Libraryの機能を活用して、言語モデルの管理と微調整モデルのために、このプロジェクトはLlama-2-7bを含む豊富な事前訓練を受けたモデルから恩恵を受けます。

Pinecone :ベクトルインデックスとして松ぼっくりを使用すると、テキストデータを表す高次元ベクトルの効率的なストレージ、管理、およびクエリが保証されます。その機能は、RAGアプローチをサポートする上で極めて重要です。

Sagemaker :Sagemakerの計算能力は、生成、検索、全体的なモデル開発などのタスクを利用しています。 Sagemakerは、機械学習モデルを大規模に展開および管理するためのシームレスな環境を提供します。

LLAMA2 :Meta AIによって開発されたLlama-2モデルは、このプロジェクトの基礎を形成しています。パラメーターサイズが大きいLlama-2-7Bは、医療質問を回答するための主要な生成モデルとして機能します。

検索拡張生成(RAG) :この革新的なアプローチは、Llama-2-7Bの固有の知識とキュレーションされた医療知識ベースを組み合わせています。高密度およびまばらな埋め込みの統合と、効率的な検索のためのPineconeとともに、正確で、関連性のある、非ホリューチン化されていない応答が保証されます。

医療データの広範な性質を考慮すると、特定のエッジケースが発生する可能性があります。正確な応答を確保するために、モデルのトレーニングデータの外側にあるクエリを処理することが不可欠です。さらに、システムは、あいまいなクエリを処理し、意味のある出力を提供するのに十分堅牢である必要があります。

現在の実装は堅牢ですが、常に強化の余地があります。改善の可能性には、コンテキストの理解を深めるためのチャンク戦略の改良と、パフォーマンスを改善するための追加の埋め込みを探ることが含まれます。医療テキスト処理の継続的な研究と言語モデルの進歩を組み込むために、システムの能力をさらに高めることができます。

次の依存関係がインストールされていることを確認してください。

これらの手順に従って、システムを使用します。

依存関係をインストールします。

MedLlama-QA.ipynbを実行しますこのシステムは、標準的な言語モデルと比較して、精度が向上し、幻覚の減少を示します。正確で関連する回答は、RAGアプローチを通じて生成され、医学的な質問をすることで貴重なツールになります。

このプロジェクトは、MITライセンスの下でライセンスされています。

お問い合わせについては、[[email protected]]までご連絡ください。

大規模な言語モデルのラマ2ファミリに貢献してくれたメタAIの開発者に感謝します。このプロジェクトは、医療ドメインの言語モデルの責任ある開発に貢献することを目指して、彼らの仕事に基づいています。