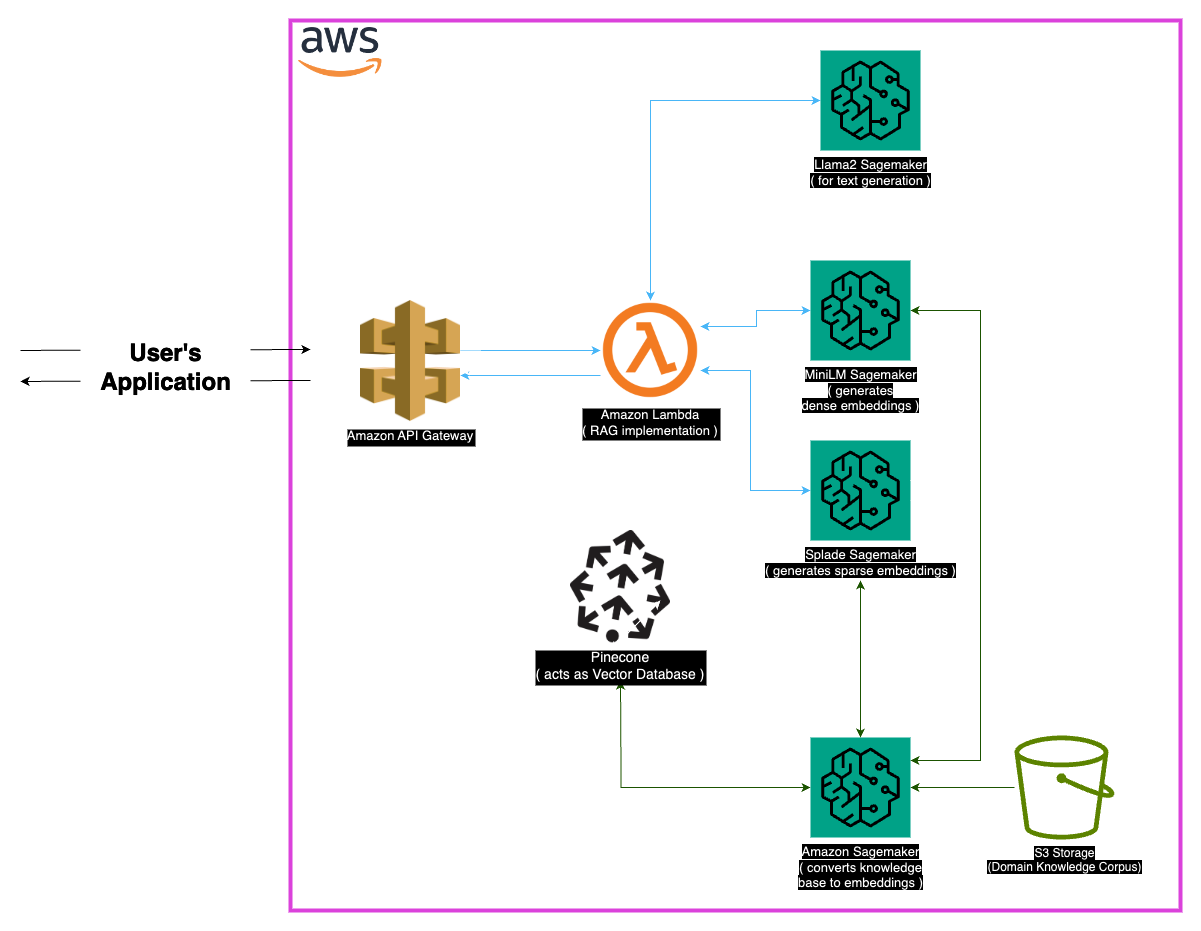

استكشاف Medllama-QA ، وهو نظام تجريب طبي متطور مدعوم من LLAMA-2-7B. الاستفادة من الاسترجاع المعزز (RAG) والتضمينات المتقدمة ، يوفر هذا المستودع إجابات دقيقة ودقيقة في السياق ، مما يقلل من الهلوسة. من خلال مكدس تقني قوي بما في ذلك Minilm و Splade و Pinecone و Sagemaker ، يحقق Medllama-QA الدقة المعززة والأهمية في ضمان الجودة الطبية ، وعرض الأداء المتفوق بالمقارنة مع نماذج اللغة القياسية.

يتطلب المجال الطبي الدقة في أنظمة الإجابة على الأسئلة ، ويقدم هذا المستودع حلًا متطورًا يستفيد من نموذج LLAMA-2-7B. من خلال نهج الجيل المعزز للاسترجاع (RAG) ، يدمج هذا النظام قاعدة المعرفة الطبية المنسقة مع LLAMA-2-7B ، مما يضمن استجابات دقيقة من الناحية السياقية والطبية. من خلال استخدام التضمينات والقوة الحسابية لـ SageMaker و Pinecone ، يعالج هذا النموذج تحديات نماذج اللغة الكبيرة ، ووعود الهلوسة المنخفضة والإجابات الدقيقة ذات الصلة.

تعمل مجموعة بيانات "PubMed" كخزان شاسع للمعرفة الطبية. بالنظر إلى قيود أحجام نوافذ النموذج ، تقوم استراتيجية التقطيع بتقسيم مجموعات البيانات النصية الكبيرة إلى أجزاء يمكن التحكم فيها ، مما يتيح النموذج من معالجة المعلومات السياقية وفهمها بشكل فعال.

التضمين

تضمينات كثيفة (MINILM) : تمثيلات مضغوطة للبيانات النصية ، التي يتم إنشاؤها من MINILM ، توفر متجهات ذات حجم ثابت لكل نص ، مما يضمن التوحيد. تلتقط هذه التضمينات معلومات أساسية من النصوص الطبية ، مما يسمح للنموذج بفهم ومعالجة بيانات الإدخال بشكل فعال.

التضمينات المتفرقة (splade) : تتميز ناقلات عالية الأبعاد ذات قيم صفر في الغالب ، تلتقط تضمينات Splade علاقات دقيقة في البيانات. يمكّن هذا النهج النموذج من التقاط تفاصيل معقدة في النصوص الطبية ، مما يعزز قدرته على توفير إجابات دقيقة وذات صلة بالسياق.

متجر المتجهات

يكمن جوهر نهج الجيل المعزز للاسترجاع (RAG) في متجر Vector ، الذي يلعب دورًا حاسمًا في تخزين التضمينات وتسهيل الاستردادات السريعة. Pinecone ، الذي تم اختياره لتحسينه في إدارة المتجهات عالية الأبعاد والاستعلام عنها ، جزء لا يتجزأ من فعالية نهج الخرقة. تضمن كفاءة Pinecone عمليات البحث السريع للتشابه وتمكين النموذج من استرداد المحتوى المرتبط بشكل دلالي بسرعة.

Luggingface : الاستفادة من إمكانات مكتبة Huggingface لإدارة نماذج اللغات وصقلها ، يستفيد هذا المشروع من ثروة من النماذج التي تم تدريبها مسبقًا ، بما في ذلك LLAMA-2-7B.

Pinecone : يضمن استخدام Pinecone كفهرس ناقل التخزين والإدارة والاستعلام عن ناقلات عالية الأبعاد تمثل البيانات النصية. قدراتها محورية في دعم نهج الخرقة.

Sagemaker : يتم تسخير البراعة الحسابية لـ Sagemaker للمهام مثل تضمين توليد واسترجاع وتطوير النموذج العام. يوفر Sagemaker بيئة سلسة لنشر وإدارة نماذج التعلم الآلي على نطاق واسع.

LLAMA2 : يشكل نموذج LLAMA-2 ، الذي طورته META AI ، أساس هذا المشروع. Llama-2-7b ، مع حجم المعلمة الكبير ، بمثابة النموذج التوليدي الأساسي للاستعداد للأسئلة الطبية.

الجيل المعزز للاسترجاع (RAG) : يجمع هذا النهج المبتكر بين المعرفة الكامنة في LLAMA-2-7B مع قاعدة المعرفة الطبية المنسقة. يضمن دمج التضمينات الكثيفة والتفريقة ، إلى جانب pinecone لاسترجاعها الفعال ، استجابات دقيقة وذات صلة وغير محفوظة.

بالنظر إلى الطبيعة الواسعة للبيانات الطبية ، قد تنشأ بعض حالات الحافة. من الضروري التعامل مع الاستعلامات التي تقع خارج بيانات تدريب النموذج لضمان استجابات دقيقة. بالإضافة إلى ذلك ، يجب أن يكون النظام قويًا بما يكفي للتعامل مع الاستعلامات الغامضة وتوفير مخرجات ذات معنى.

على الرغم من أن التنفيذ الحالي قوي ، إلا أن هناك دائمًا مجال للتعزيز. تشمل التحسينات المحتملة تحسين استراتيجية التقطيع لتحسين فهم السياق واستكشاف تضمينات إضافية لتحسين الأداء. يمكن دمج الأبحاث المستمرة في معالجة النصوص الطبية والتطورات في نماذج اللغة لتعزيز قدرات النظام.

تأكد من تثبيت التبعيات التالية:

اتبع هذه الخطوات لاستخدام النظام:

تثبيت التبعيات.

MedLlama-QA.ipynb يعرض النظام دقة محسنة وخفض الهلوسة مقارنة بنماذج اللغة القياسية. يتم إنشاء إجابات دقيقة وذات الصلة من خلال نهج الخرقة ، مما يجعلها أداة قيمة في إجابة الأسئلة الطبية.

هذا المشروع مرخص بموجب ترخيص معهد ماساتشوستس للتكنولوجيا.

للحصول على أي استفسارات ، يرجى الاتصال بي على [[email protected]].

شكر خاص للمطورين في Meta AI على مساهماتهم في عائلة Llama 2 من نماذج اللغة الكبيرة. يعتمد هذا المشروع على عملهم ، بهدف المساهمة في التطوير المسؤول لنماذج اللغة في المجال الطبي.