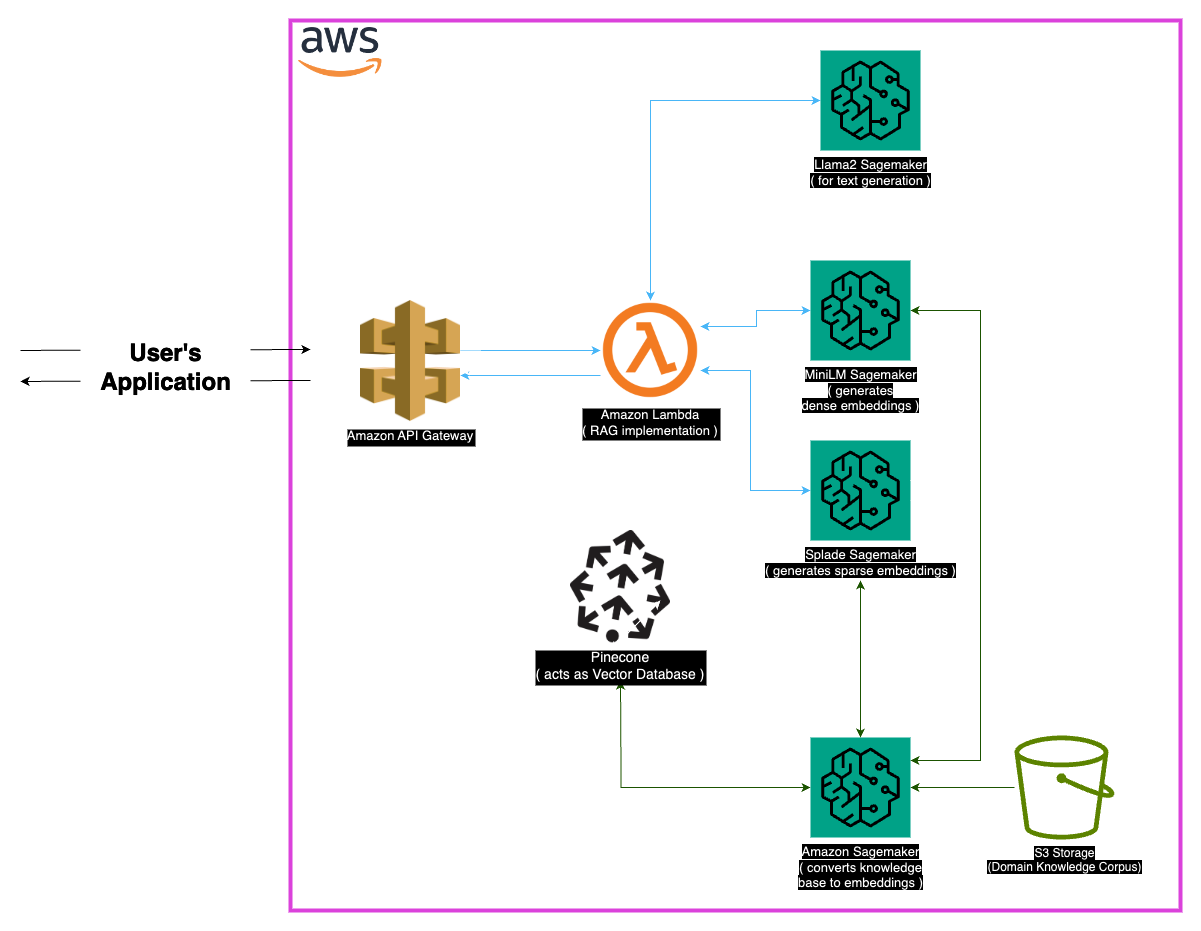

Explore o Medllama-Qa, um sistema de afastamento de perguntas médicas de ponta alimentado por llama-2-7b. Alavancando a geração aumentada de recuperação (RAG) e incorporações avançadas, este repositório oferece respostas precisas e contextualmente precisas, reduzindo alucinações. Com uma pilha de tecnologia robusta, incluindo minilm, splade, pinecone e sagemaker, o Medllama-QA alcança precisão e relevância aprimoradas no controle de qualidade médica, apresentando desempenho superior em comparação com modelos de linguagem padrão.

O campo médico exige precisão nos sistemas de resposta a perguntas, e este repositório apresenta uma solução sofisticada que alavancava o modelo LLAMA-2-7B. Através da abordagem de geração aumentada de recuperação (RAG), este sistema integra uma base de conhecimento médico com curadoria com llama-2-7b, garantindo respostas contextualmente e clinicamente precisas. Ao utilizar incorporações e o poder computacional do Sagemaker e Pinecone, este modelo aborda os desafios de grandes modelos de linguagem, promissores alucinações reduzidas e respostas precisas e relevantes.

O conjunto de dados 'PubMed' serve como um vasto reservatório de conhecimento médico. Dadas as limitações dos tamanhos das janelas do modelo, uma estratégia de chunking divide os grandes conjuntos de dados de texto em partes gerenciáveis, permitindo que o modelo processe e compreenda informações contextuais de maneira eficaz.

Incorporação

Incorporações densas (minilm) : representações compactas dos dados de texto, geradas a partir do minilm, fornecem vetores de tamanho fixo para cada peça de texto, garantindo uniformidade. Essas incorporações capturam informações essenciais de textos médicos, permitindo que o modelo compreenda e processe dados de entrada de maneira eficaz.

INCLIMEIRAS ESCOLHAS (Splade) : Caracterizadas por vetores de alta dimensão com valores principalmente zero, as incorporações esparsas de Splade capturam relacionamentos diferenciados nos dados. Essa abordagem permite que o modelo capture detalhes complexos em textos médicos, aprimorando sua capacidade de fornecer respostas precisas e contextualmente relevantes.

Loja de vetores

O núcleo da abordagem de geração aumentada de recuperação (RAG) está na loja de vetores, que desempenha um papel crucial no armazenamento de incorporações e na facilitação de recuperações rápidas. Pinecone, escolhido por sua otimização no gerenciamento e consulta de vetores de alta dimensão, é parte integrante da eficácia da abordagem do RAG. A eficiência da Pinecone garante pesquisas rápidas de similaridade e permite que o modelo recupere o conteúdo semanticamente relacionado rapidamente.

Huggingface : alavancando os recursos da Biblioteca Huggingface para gerenciar e ajustar modelos de idiomas, este projeto se beneficia de uma riqueza de modelos pré-treinados, incluindo LLAMA-2-7B.

Pinecone : o uso do Pinecone como um índice vetorial garante armazenamento, gerenciamento e consulta eficientes de vetores de alta dimensão que representam dados textuais. Suas capacidades são fundamentais para apoiar a abordagem do RAG.

Sagemaker : A proeza computacional do Sagemaker é aproveitada para tarefas como incorporação de geração, recuperação e desenvolvimento geral do modelo. A Sagemaker fornece um ambiente contínuo para implantar e gerenciar modelos de aprendizado de máquina em escala.

LLAMA2 : O modelo LLAMA-2, desenvolvido pela Meta AI, forma a base deste projeto. O LLAMA-2-7B, com seu grande tamanho de parâmetro, serve como o modelo generativo primário para a resposta à pergunta médica.

Geração aumentada de recuperação (RAG) : Esta abordagem inovadora combina o conhecimento inerente da llama-2-7b com uma base de conhecimento médico com curadoria. A integração de incorporações densas e esparsas, juntamente com a Pinecone para recuperação eficiente, garante respostas precisas, relevantes e não halluxas.

Considerando a natureza extensa dos dados médicos, certos casos de borda podem surgir. É essencial lidar com consultas que ficam fora dos dados de treinamento do modelo para garantir respostas precisas. Além disso, o sistema deve ser robusto o suficiente para lidar com consultas ambíguas e fornecer saídas significativas.

Embora a implementação atual seja robusta, sempre há espaço para aprimoramento. Possíveis melhorias incluem refinar a estratégia de Chunking para uma melhor compreensão contextual e exploração de incorporações adicionais para melhorar o desempenho. Pesquisas em andamento em processamento e avanços de texto médico em modelos de idiomas podem ser incorporados para aprimorar ainda mais os recursos do sistema.

Verifique se as seguintes dependências estão instaladas:

Siga estas etapas para usar o sistema:

Instalar dependências.

MedLlama-QA.ipynb O sistema exibe maior precisão e alucinações reduzidas em comparação com modelos de linguagem padrão. As respostas precisas e relevantes são geradas através da abordagem do RAG, tornando-a uma ferramenta valiosa na resposta à pergunta médica.

Este projeto está licenciado sob a licença do MIT.

Para qualquer pergunta, entre em contato comigo em [[email protected]].

Agradecimentos especiais aos desenvolvedores da Meta AI por suas contribuições para a família Llama 2 de grandes modelos de idiomas. Este projeto baseia -se em seu trabalho, com o objetivo de contribuir para o desenvolvimento responsável de modelos de idiomas no domínio médico.