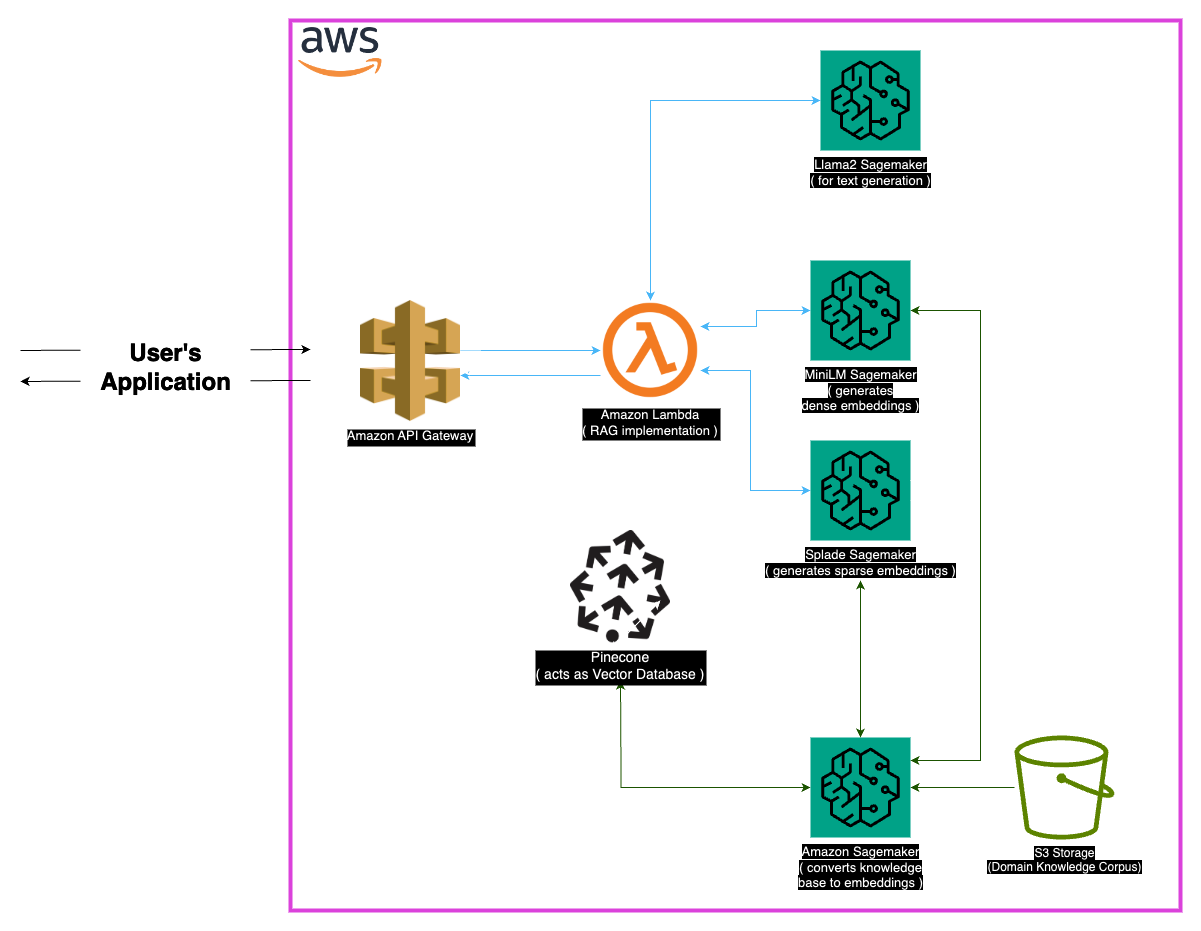

Explore Medllama-Qa, un sistema de preguntas médicas de respuesta a la vanguardia impulsado por Llama-2-7B. Aprovechando la generación aumentada de recuperación (RAG) e incrustaciones avanzadas, este repositorio ofrece respuestas precisas y contextualmente precisas, reduciendo las alucinaciones. Con una sólida pila tecnológica que incluye minilm, Splade, Pinecone y SageMaker, Medllama-Qa logra una mayor precisión y relevancia en el control de calidad médico, que muestra un rendimiento superior en comparación con los modelos de idiomas estándar.

El campo de la medicina exige precisión en los sistemas de preguntas sobre la pregunta, y este repositorio presenta una solución sofisticada que aprovecha el modelo LLAMA-2-7B. A través del enfoque de generación aumentada (RAG) de recuperación, este sistema integra una base de conocimiento médico curado con LLAMA-2-7B, asegurando respuestas contextuales y médicamente precisas. Al utilizar las integridades y el poder computacional de Sagemaker y Pinecone, este modelo aborda los desafíos de los modelos de idiomas grandes, prometiendo alucinaciones reducidas y respuestas precisas y relevantes.

El conjunto de datos 'PubMed' sirve como un vasto depósito de conocimiento médico. Dadas las limitaciones de los tamaños de las ventanas del modelo, una estrategia de fábrica desglosa los grandes conjuntos de datos de texto en porciones manejables, lo que permite que el modelo procese y comprenda la información contextual de manera efectiva.

Incrustaciones

Incremedios densos (minilm) : las representaciones compactas de los datos de texto, generados a partir del minilm, proporcionan vectores de tamaño fijo para cada pieza de texto, asegurando la uniformidad. Estas incrustaciones capturan información esencial de textos médicos, lo que permite que el modelo comprenda y procese los datos de entrada de manera efectiva.

Incremedios escasos (Splade) : caracterizados por vectores de alta dimensión con valores en su mayoría cero, las embebidos escasos de Splade capturan relaciones matizadas en los datos. Este enfoque permite al modelo capturar detalles intrincados en textos médicos, mejorando su capacidad para proporcionar respuestas precisas y contextualmente relevantes.

Tienda de vectores

El núcleo del enfoque de generación aumentada de recuperación (RAG) se encuentra en la tienda Vector, que juega un papel crucial en el almacenamiento de integridades y facilita las recuperaciones rápidas. Pinecone, elegido para su optimización en la gestión y consulta de vectores de alta dimensión, es parte integral de la efectividad del enfoque RAG. La eficiencia de Pinecone garantiza búsquedas de similitud rápida y permite que el modelo recupere el contenido semánticamente relacionado rápidamente.

Huggingface : Aprovechando las capacidades de la Biblioteca Huggingface para administrar y ajustar modelos de idiomas, este proyecto se beneficia de una gran cantidad de modelos previamente capacitados, incluido LLAMA-2-7B.

Pinecone : el uso de pinecone como índice vectorial garantiza un almacenamiento eficiente, gestión y consulta de vectores de alta dimensión que representan datos textuales. Sus capacidades son fundamentales para apoyar el enfoque de RAG.

Sagemaker : la destreza computacional de Sagemaker se aprovecha de tareas como la generación de incrustación, la recuperación y el desarrollo general del modelo. Sagemaker proporciona un entorno perfecto para implementar y administrar modelos de aprendizaje automático a escala.

LLAMA2 : El modelo LLAMA-2, desarrollado por Meta AI, forma la base de este proyecto. Llama-2-7B, con su gran tamaño de parámetro, sirve como el modelo generativo principal para la respuesta de preguntas médicas.

Generación aumentada de recuperación (RAG) : este enfoque innovador combina el conocimiento inherente de LLAMA-2-7B con una base de conocimiento médico curado. La integración de incrustaciones densas y escasas, junto con Pinecone para una recuperación eficiente, garantiza respuestas precisas, relevantes y no talucinadas.

Teniendo en cuenta la naturaleza extensa de los datos médicos, pueden surgir ciertos casos de borde. Es esencial manejar consultas que caen fuera de los datos de capacitación del modelo para garantizar respuestas precisas. Además, el sistema debe ser lo suficientemente robusto como para manejar consultas ambiguas y proporcionar salidas significativas.

Si bien la implementación actual es robusta, siempre hay espacio para mejorar. Las posibles mejoras incluyen la refinación de la estrategia de fragmentación para una mejor comprensión contextual y explorar integridades adicionales para un mejor rendimiento. La investigación continua en el procesamiento de textos médicos y los avances en modelos de idiomas se pueden incorporar para mejorar aún más las capacidades del sistema.

Asegúrese de que se instalen las siguientes dependencias:

Siga estos pasos para usar el sistema:

Instalar dependencias.

MedLlama-QA.ipynb El sistema exhibe una precisión mejorada y alucinaciones reducidas en comparación con los modelos de idiomas estándar. Se generan respuestas precisas y relevantes a través del enfoque RAG, por lo que es una herramienta valiosa en la respuesta de preguntas médicas.

Este proyecto tiene licencia bajo la licencia MIT.

Para cualquier consulta, comuníquese conmigo en [[email protected]].

Un agradecimiento especial a los desarrolladores de Meta AI por sus contribuciones a la familia Llama 2 de modelos de idiomas grandes. Este proyecto se basa en su trabajo, con el objetivo de contribuir al desarrollo responsable de los modelos de idiomas en el dominio médico.