TutorKD

1.0.0

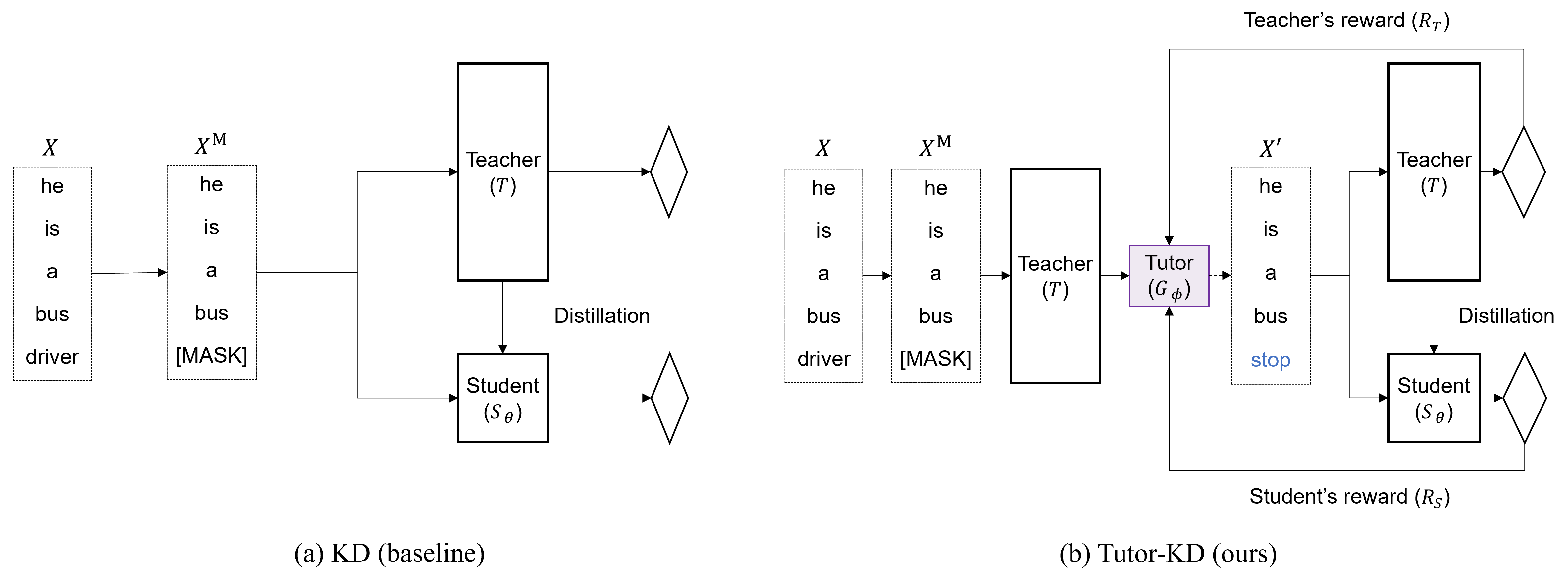

該存儲庫是關於Tutor-KD長論文:輔導可以幫助學生學習更好的學習:通過在EMNLP 2022中發布的Tutor Network來改善BERT的知識蒸餾。在該項目中,我們有興趣可以減輕傳播樣本,從而減輕不正確的教師預測和學生的重複學習。

準備數據文件夾中的培訓前語料庫(Wikipedia和BookCorpus)。使用python preprocess.py 。

--data_path :包含預處理示例(醃製文件)的目錄。--raw_data_path :包含原始文本示例的目錄。 最後,使用python distillation.py進行蒸餾。

--config :學生模型架構。從:一半,Extreme-12,Ext-6,Ext-2選擇模型體系結構--lr :設定學習率。--epochs :設置時期的數量。--batch_size :設置批處理大小,以一次進行進行。--step_batch_size :設置每個步驟更新的批次大小(如果GPU的內存足夠,請設置batch_size和step_batch_size相同。--data_path :一個包含預處理示例的目錄。--model_save_path :設置保存學生模型的目錄有關使用Tutor-KD的幫助或問題,請提交GitHub問題。

有關與Tutor-kd相關的個人通訊,請聯繫Junho Kim <[email protected]> 。