TutorKD

1.0.0

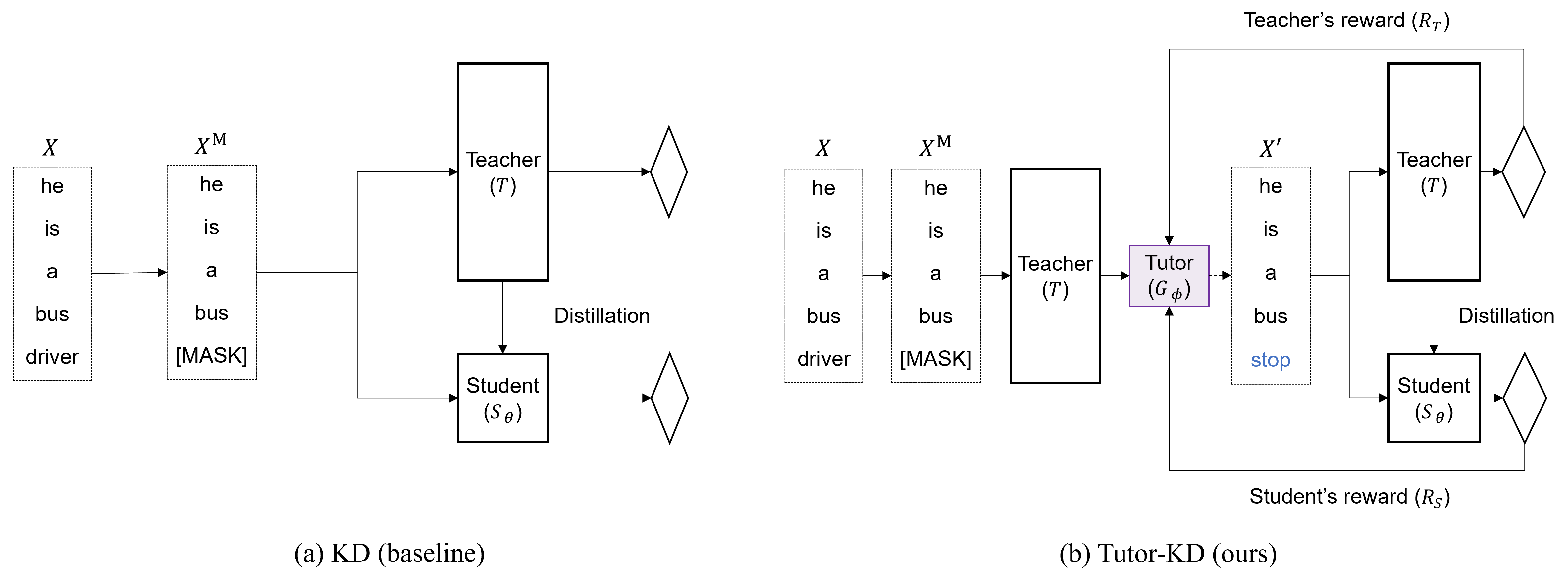

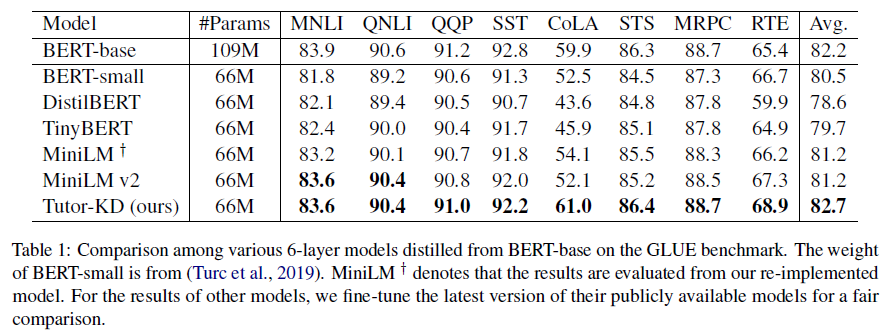

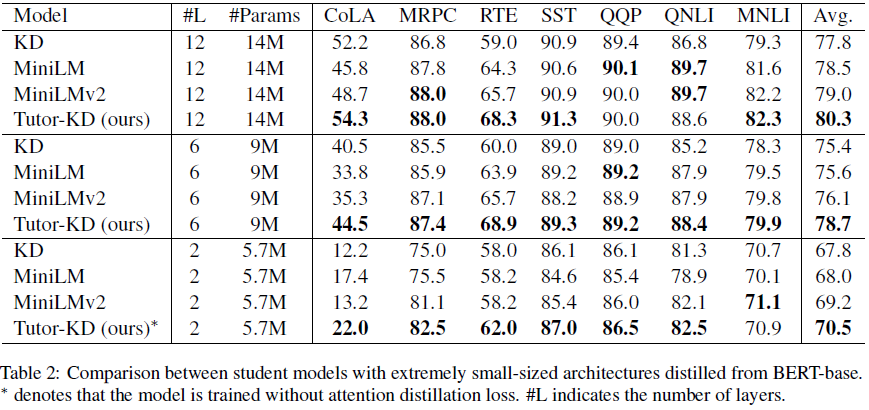

Repositori ini adalah tentang Tutor-KD Panjang kertas: Bimbingan membantu siswa belajar lebih baik: meningkatkan distilasi pengetahuan untuk Bert dengan jaringan tutor yang diterbitkan dalam EMNLP 2022. Dalam proyek ini, kami tertarik untuk menghasilkan sampel yang traning yang dapat mengurangi prediksi guru yang salah dan pembelajaran berulang untuk siswa.

Siapkan korpora pra-pelatihan (Wikipedia dan Bookcorpus) di folder data. Gunakan python preprocess.py .

--data_path : Direktori yang berisi contoh pra-diproses (file acar).--raw_data_path : Direktori yang berisi contoh teks mentah. Akhirnya, gunakan python distillation.py untuk distilasi.

--config : Arsitektur Model Siswa. Pilih Arsitektur Model dari: Half, Extreme-12, Ext-6, Ext-2--lr : Tetapkan tingkat pembelajaran.--epochs : Tetapkan jumlah zaman.--batch_size : Atur ukuran batch untuk melakukan sekaligus.--step_batch_size : Atur ukuran batch untuk memperbarui per setiap langkah (jika memori GPU sudah cukup, atur batch_size dan step_batch_size sama.--data_path : Direktori yang berisi contoh yang telah diproses sebelumnya.--model_save_path : Setel direktori untuk menyimpan model siswa Untuk bantuan atau masalah menggunakan Tutor-KD, silakan kirimkan masalah GitHub.

Untuk komunikasi pribadi yang terkait dengan Tutor-KD, silakan hubungi Junho Kim <[email protected]> .