TutorKD

1.0.0

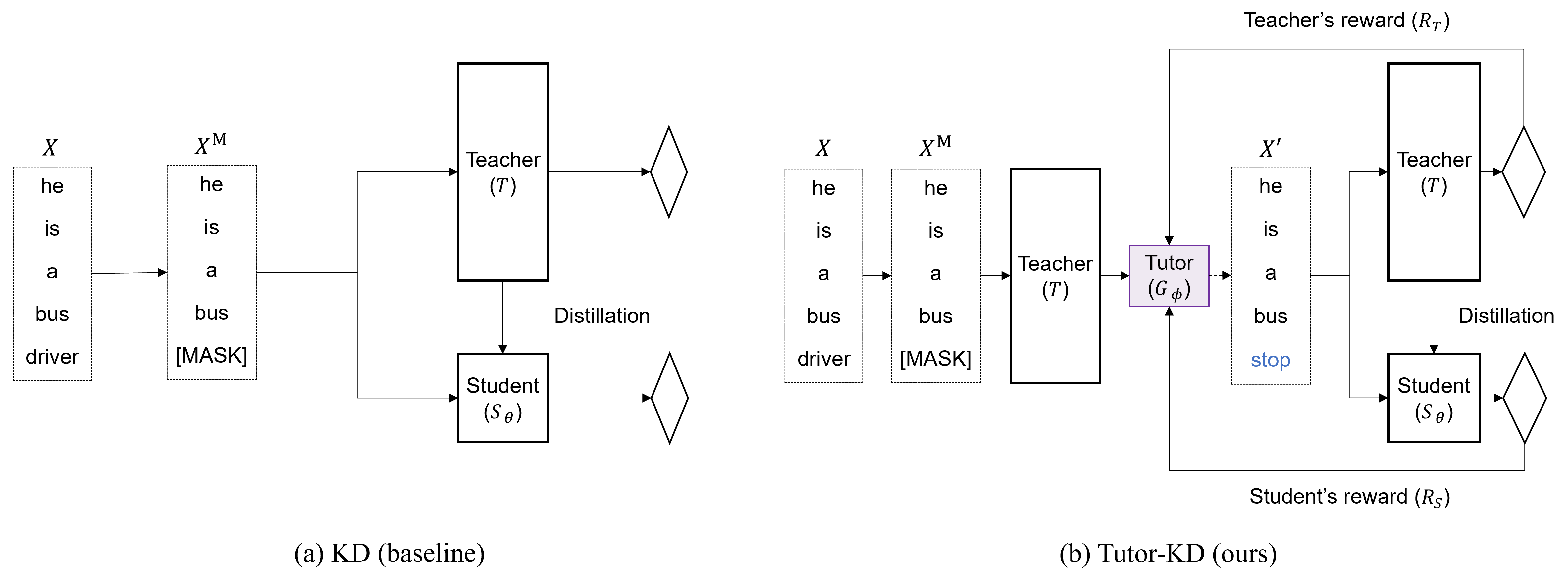

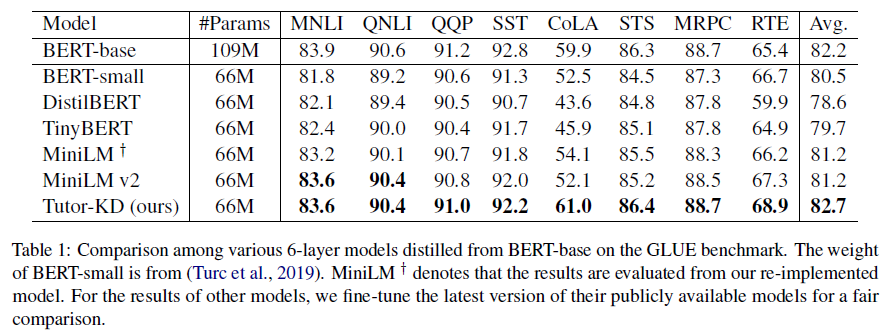

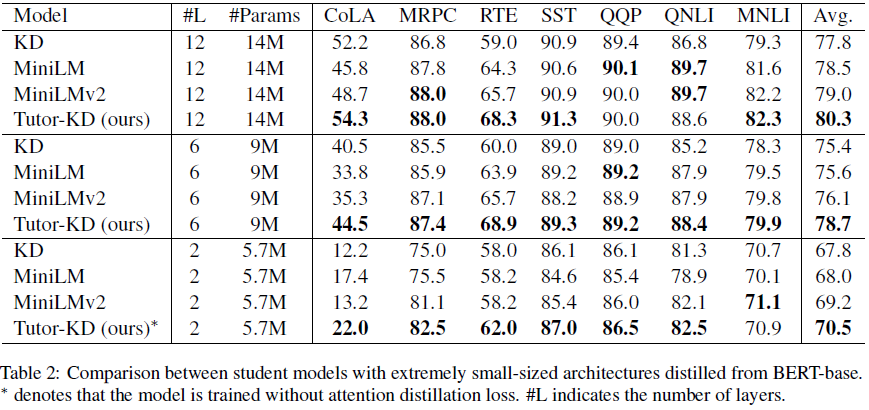

이 저장소는 Tutor-KD Long Paper에 관한 것입니다. 튜터링은 학생들이 더 잘 배우는 데 도움이됩니다. EMNLP 2022에 게시 된 교사 네트워크를 통해 BERT의 지식 증류 개선.이 프로젝트에서는 학생을위한 잘못된 교사 예측 및 반복적 학습을 완화 할 수있는 트랜싱 샘플을 생성하는 데 관심이 있습니다.

데이터 폴더에서 사전 훈련 Corpora (Wikipedia 및 BookCorpus)를 준비하십시오. python preprocess.py 사용하십시오.

--data_path : 사전 처리 된 예제 (피클 파일)가 포함 된 디렉토리.--raw_data_path : 원시 텍스트 예제가 포함 된 디렉토리. 마지막으로 증류를 위해 python distillation.py 사용하십시오.

--config : 학생 모델 아키텍처. Half, Extreme-12, Ext-6, Ext-2에서 모델 아키텍처를 선택하십시오--lr : 학습 속도를 설정하십시오.--epochs : 에포크 수를 설정하십시오.--batch_size : 한 번에 전도를 위해 배치 크기를 설정하십시오.--step_batch_size : 각 단계마다 업데이트 할 배치 크기를 설정하십시오 (GPU의 메모리가 충분한 경우 Batch_size 및 step_batch_size를 동일하게 설정하십시오.--data_path : 사전 처리 된 예제를 포함하는 디렉토리.--model_save_path : 학생 모델 저장을위한 디렉토리 설정 Tutor-KD를 사용하는 도움이나 문제는 Github 문제를 제출하십시오.

Tutor-KD와 관련된 개인 커뮤니케이션은 Junho kim <[email protected]> 에 문의하십시오.