TutorKD

1.0.0

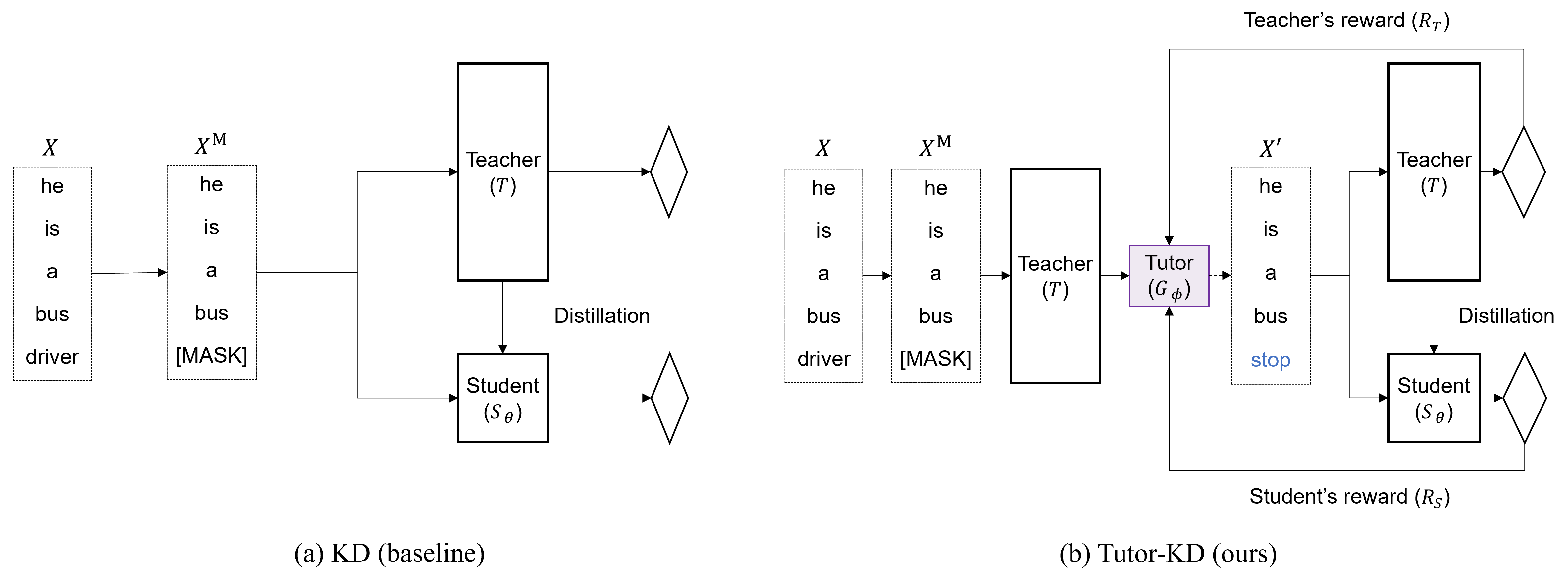

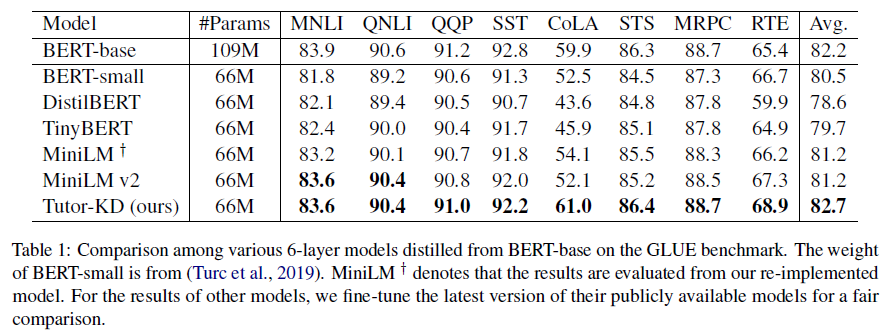

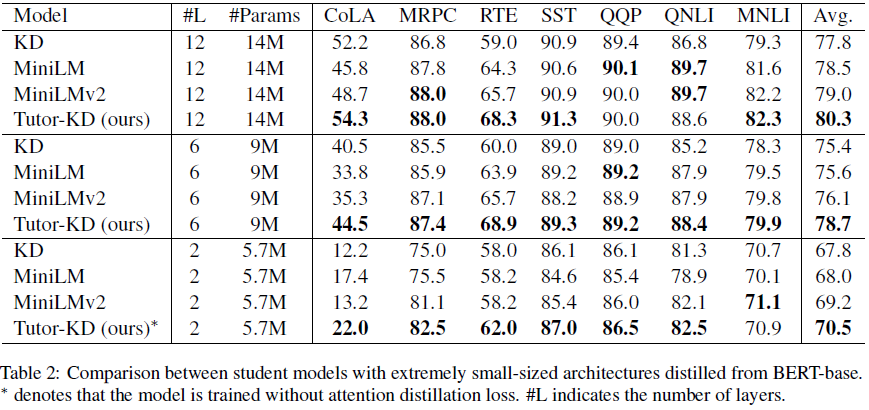

Этот репозиторий посвящена длинной статье Tutor-KD: репетиторство помогает студентам лучше учиться: улучшение дистилляции знаний для Bert с сетью репетиторов, опубликованной в EMNLP 2022. В этом проекте мы заинтересованы в создании образцов транирования, которые могут смягчить неверные прогнозы учителей и повторяющееся обучение для студентов.

Подготовьте корпорацию перед тренировкой (Википедия и BookCorpus) в папке данных. Используйте python preprocess.py .

--data_path : каталог, содержащий предварительно обработанные примеры (маринованный файл).--raw_data_path : каталог, содержащий примеры необработанного текста. Наконец, используйте python distillation.py для дистилляции.

--config : архитектура студенческой модели. Выберите «Архитектура модели» из: половина, экстремальность-12, ext-6, ext-2--lr : установите скорость обучения.--epochs : установить количество эпох.--batch_size : установите размер партии для проведения сразу.--step_batch_size : Установите размер партии для обновления на каждом шаге (если достаточно графического процессора, установите то же самое.--data_path : каталог, содержащий предварительно обработанные примеры.--model_save_path : установить каталог для сохранения модели студента Для получения помощи или проблем с использованием Tutor-KD, пожалуйста, отправьте проблему GitHub.

Для личного общения, связанного с Tutor-KD, пожалуйста, свяжитесь с Junho Kim <[email protected]> .