TutorKD

1.0.0

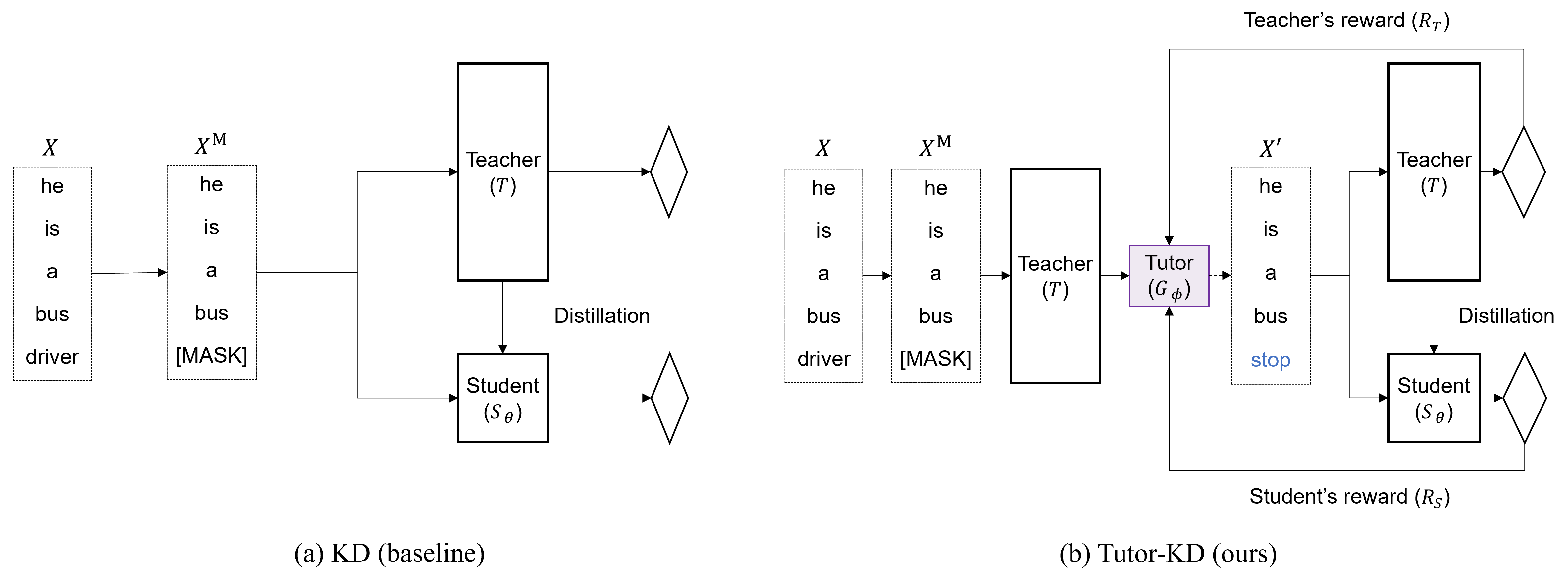

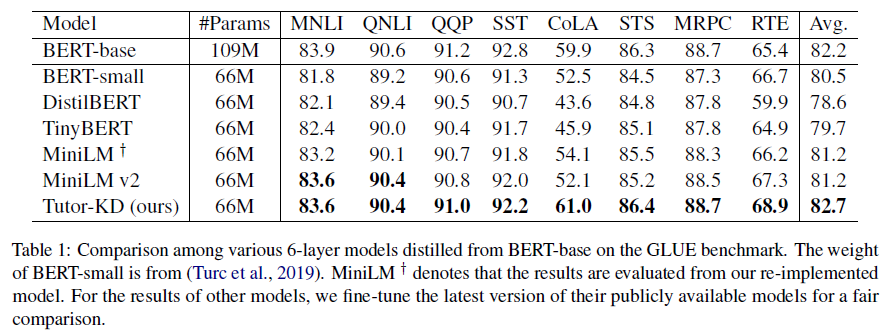

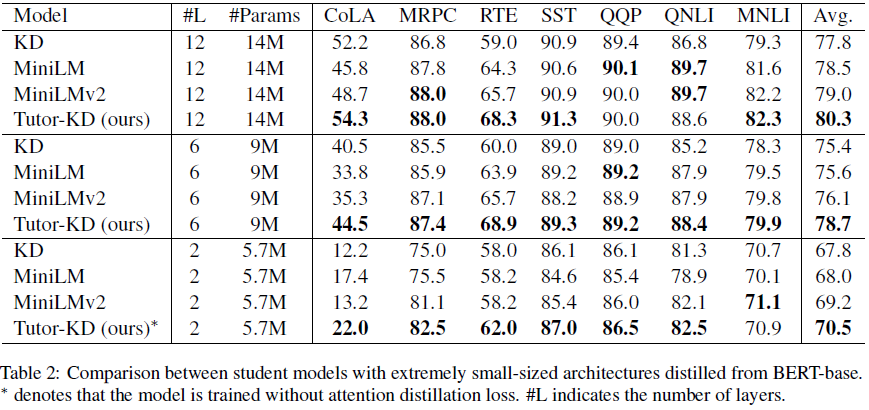

Este repositório é sobre papel longo-KD Long: tutoria ajuda os alunos a aprender melhor: melhorando a destilação do conhecimento para Bert com a rede de tutores publicada no EMNLP 2022. Neste projeto, estamos interessados em gerar as amostras de transing que podem mitigar as previsões incorretas dos professores e o aprendizado repetitivo para o aluno.

Prepare a corporação pré-treinamento (Wikipedia e Bookcorpus) na pasta de dados. Use python preprocess.py .

--data_path : um diretório contendo exemplos pré-processados (arquivo de picles).--raw_data_path : um diretório contendo exemplos de texto bruto. Finalmente, use python distillation.py para destilação.

--config : Uma arquitetura de modelo de estudante. Escolha a arquitetura do modelo de: metade, extrema-12, ext-6, ext-2--lr : defina a taxa de aprendizado.--epochs : defina o número de épocas.--batch_size : Defina o tamanho do lote para conduzir de uma só vez.--step_batch_size : Defina o tamanho do lote para atualização por cada etapa (se a memória da GPU for suficiente, defina o batch_size e o step_batch_size o mesmo.--data_path : um diretório contendo exemplos pré-processados.--model_save_path : defina o diretório para salvar o modelo do aluno Para obter ajuda ou problemas usando o tutor-kD, envie um problema do GitHub.

Para comunicação pessoal relacionada ao tutor-kD, entre em contato com Junho kim <[email protected]> .