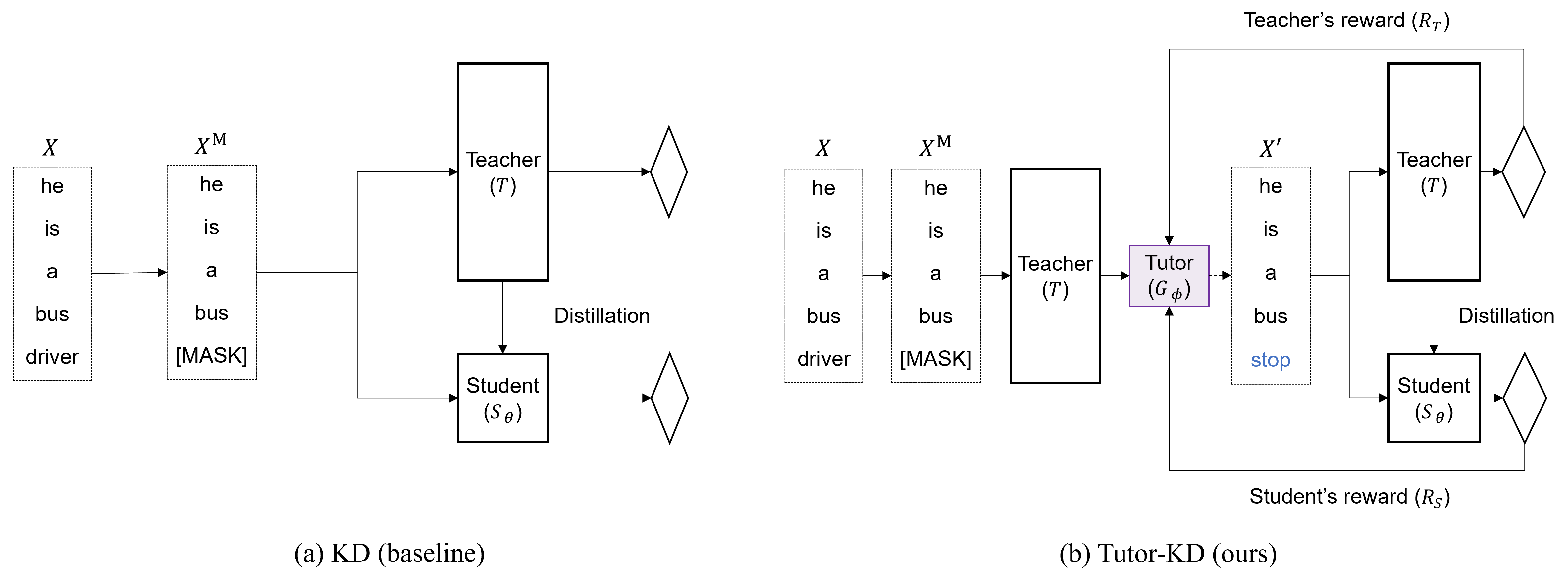

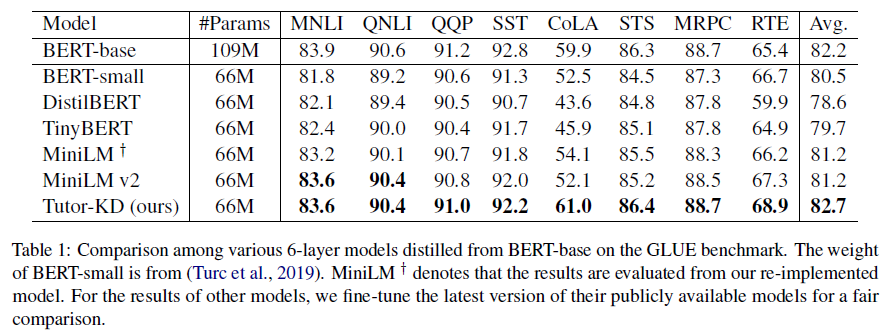

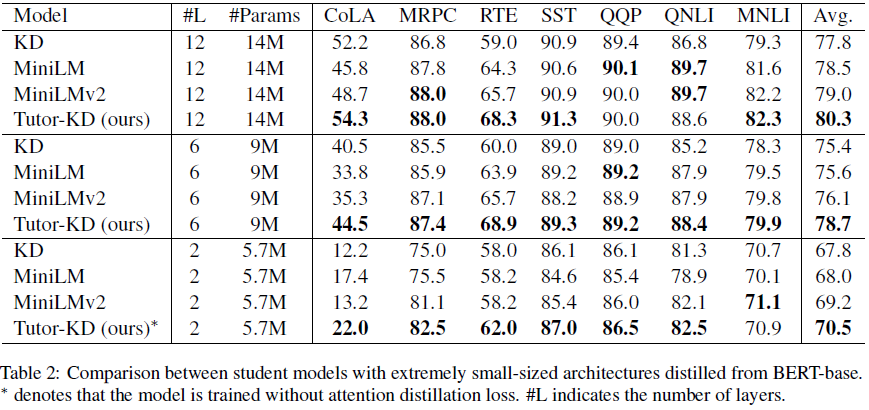

Este repositorio se trata de Tutor-KD Long Paper: La tutoría ayuda a los estudiantes a aprender mejor: mejorar la destilación de conocimiento para Bert con Tutor Network publicada en EMNLP 2022. En este proyecto, estamos interesados en generar las muestras de transmisión que pueden mitigar las predicciones incorrectas de los maestros y el aprendizaje repetitivo para el estudiante.

Prepare los corpus (Wikipedia y BookCorpus) previos al entrenamiento en la carpeta de datos. Use python preprocess.py .

--data_path : un directorio que contiene ejemplos preprocesados (archivo de encurtido).--raw_data_path : un directorio que contiene ejemplos de texto sin procesar. Finalmente, use python distillation.py para la destilación.

--config : una arquitectura de modelo de estudiante. Elija la arquitectura del modelo de: Half, Extreme-12, Ext-6, Ext-2--lr : Establezca la tasa de aprendizaje.--epochs : Establezca el número de épocas.--batch_size : configure el tamaño del lote para realizar una vez.--step_batch_size : configure el tamaño de lotes para actualizar por cada paso (si la memoria de GPU es suficiente, configure el Batch_Size y Step_Batch_Size lo mismo.--data_path : un directorio que contiene ejemplos preprocesados.--model_save_path : configure el directorio para guardar el modelo de estudiante Para obtener ayuda o problemas con Tutor-KD, envíe un problema de GitHub.

Para la comunicación personal relacionada con Tutor-KD, comuníquese con Junho Kim <[email protected]> .