TutorKD

1.0.0

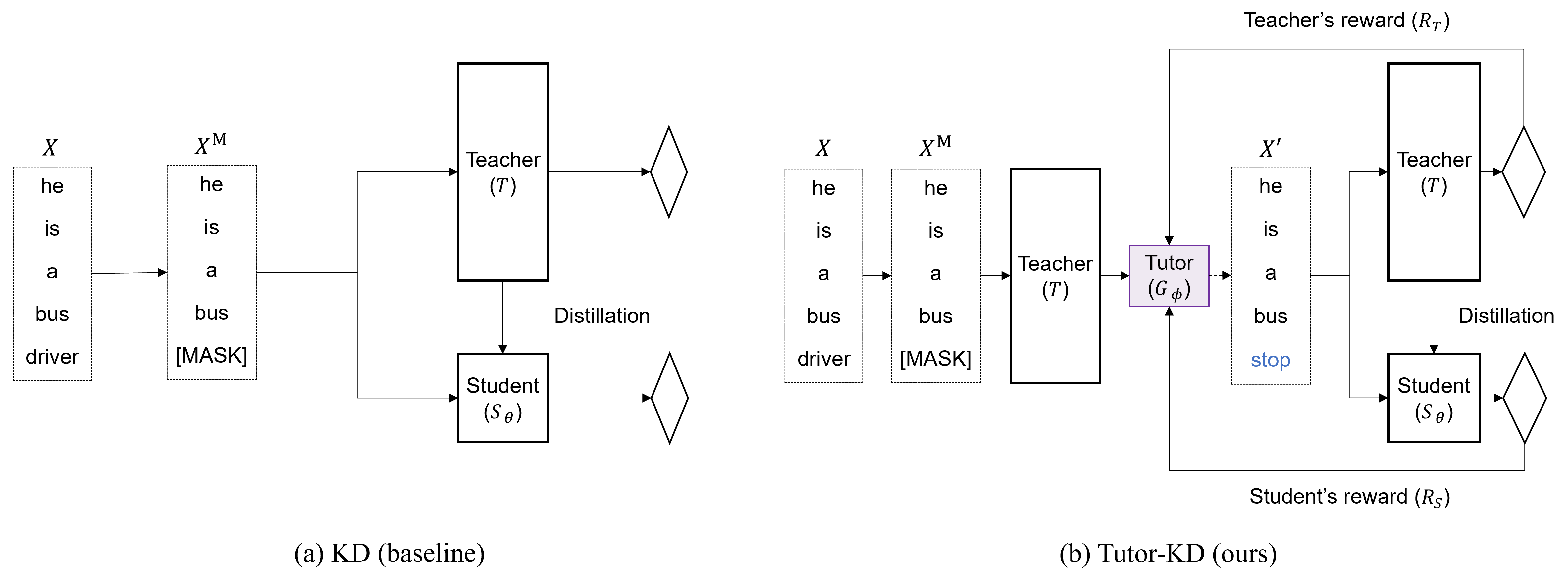

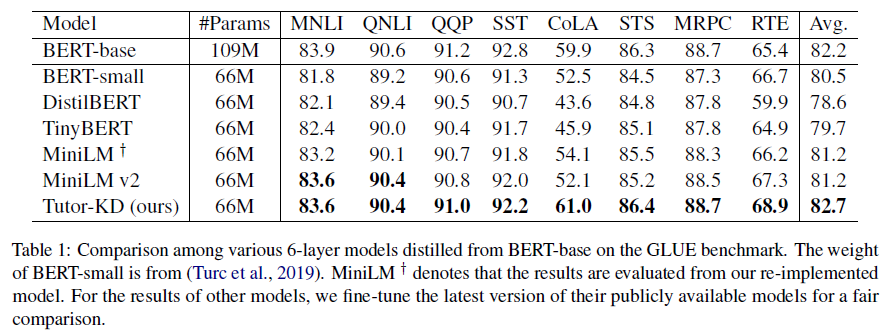

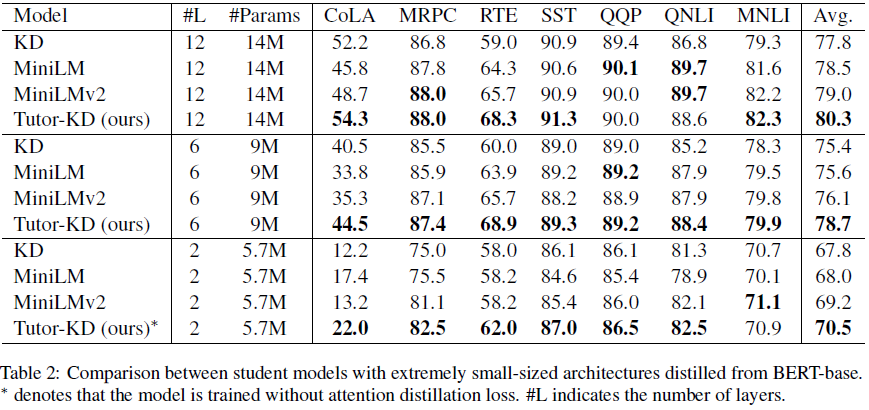

พื้นที่เก็บข้อมูลนี้เกี่ยวกับ Tutor-KD Long Paper: Tutoring ช่วยให้นักเรียนเรียนรู้ได้ดีขึ้น: การปรับปรุงการกลั่นความรู้สำหรับ Bert ด้วยเครือข่ายครูสอนพิเศษที่ตีพิมพ์ใน EMNLP 2022 ในโครงการนี้เราสนใจที่จะสร้างตัวอย่าง traning ซึ่งสามารถลดการคาดการณ์ของครูที่ไม่ถูกต้องและการเรียนรู้ซ้ำ ๆ สำหรับนักเรียน

เตรียม Corpora ก่อนการฝึกอบรม (Wikipedia และ Bookcorpus) ในโฟลเดอร์ข้อมูล ใช้ python preprocess.py

--data_path : ไดเรกทอรีที่มีตัวอย่างที่ประมวลผลล่วงหน้า (ไฟล์ดอง)--raw_data_path : ไดเรกทอรีที่มีตัวอย่างข้อความดิบ ในที่สุดใช้ python distillation.py สำหรับการกลั่น

--config : สถาปัตยกรรมแบบจำลองนักเรียน เลือกสถาปัตยกรรมแบบจำลองจาก: ครึ่ง, Extreme-12, ext-6, ext-2--lr : กำหนดอัตราการเรียนรู้--epochs : ตั้งค่าจำนวนยุค--batch_size : ตั้งค่าขนาดแบทช์สำหรับการดำเนินการในครั้งเดียว--step_batch_size : ตั้งค่าขนาดแบทช์สำหรับการอัปเดตต่อแต่ละขั้นตอน (หากหน่วยความจำของ GPU เพียงพอให้ตั้ง batch_size และ step_batch_size เดียวกัน--data_path : ไดเรกทอรีที่มีตัวอย่างที่ประมวลผลล่วงหน้า--model_save_path : ตั้งค่าไดเรกทอรีสำหรับการบันทึกโมเดลนักเรียน สำหรับความช่วยเหลือหรือปัญหาโดยใช้ Tutor-KD โปรดส่งปัญหา GitHub

สำหรับการสื่อสารส่วนบุคคลที่เกี่ยวข้องกับ Tutor-KD กรุณาติดต่อ Junho Kim <[email protected]>