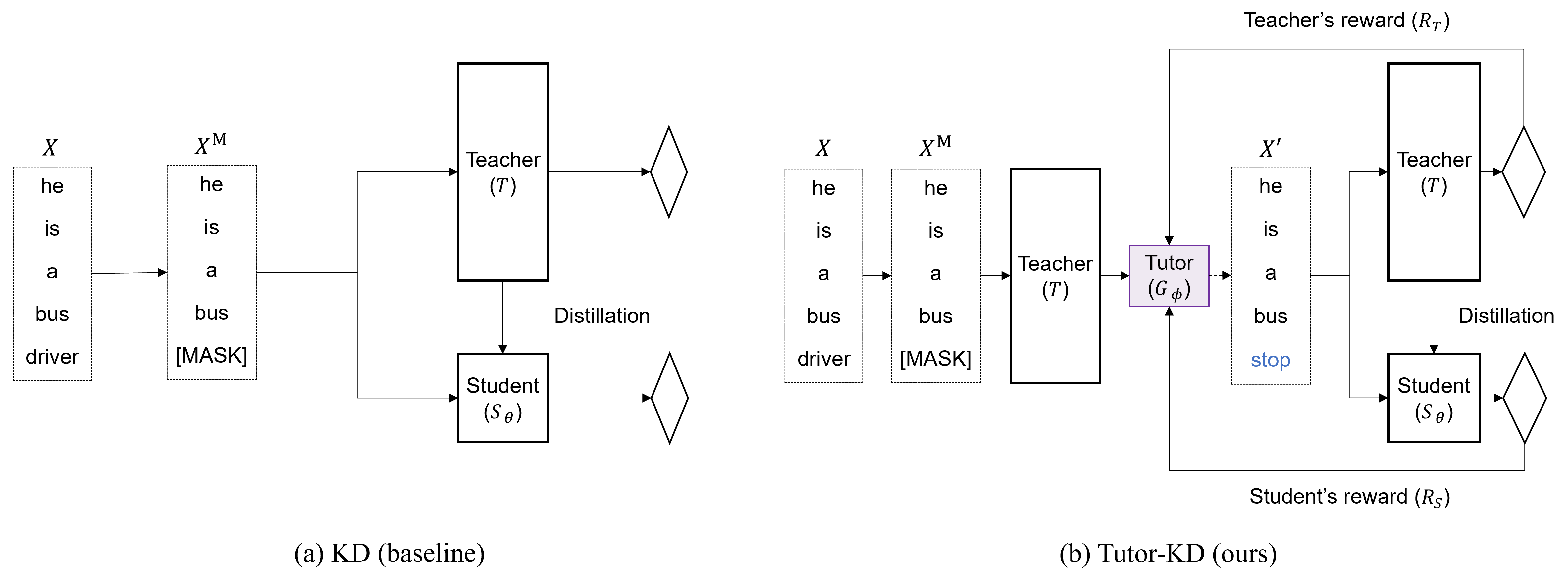

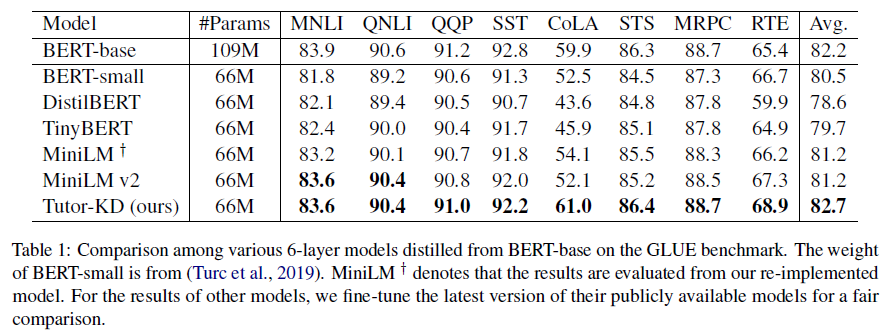

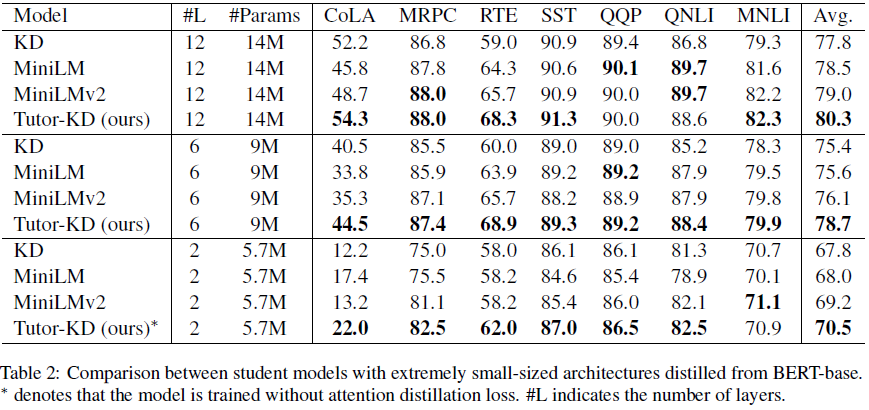

In diesem Repository geht es um Tutor-KD-Long Paper: Nachhilfe von Tutores hilft den Schülern, besser zu lernen: Verbesserung der Wissensdestillation für Bert mit Tutor-Netzwerk, die in EMNLP 2022 veröffentlicht wurde. In diesem Projekt sind wir daran interessiert, die Traning-Stichproben zu generieren, die die falschen Vorhersagen der Lehrer mindern und sich wiederholend lernen können.

Bereiten Sie die Voraussetzungskorpora (Wikipedia und Bookcorpus) im Datenordner vor. Verwenden Sie python preprocess.py .

--data_path : Ein Verzeichnis mit vorverarbeiteten Beispielen (Pickle-Datei).--raw_data_path : Ein Verzeichnis, das Beispiele für Rohtext enthält. Verwenden Sie schließlich python distillation.py zur Destillation.

--config : Eine Studentenmodellarchitektur. Wählen Sie die Modellarchitektur aus: halb, extrem-12, ext-6, ext-2--lr : Legen Sie die Lernrate fest.--epochs : Stellen Sie die Anzahl der Epochen fest.--batch_size : Stellen Sie die Stapelgröße für das gleichzeitige Durchführen fest.--step_batch_size : Setzen Sie die Stapelgröße für die Aktualisierung pro Schritt (Wenn der Speicher von GPU ausreicht, setzen Sie die batch_size und step_batch_size dasselbe.--data_path : Ein Verzeichnis mit vorverarbeiteten Beispielen.--model_save_path : Setzen Sie das Verzeichnis für das Speichern des Schülermodells Für Hilfe oder Probleme mit Tutor-KD senden Sie bitte ein GitHub-Problem.

Für persönliche Mitteilung im Zusammenhang mit Tutor-KD wenden Sie sich bitte an Junho Kim <[email protected]> .