tying wv and wc

1.0.0

“綁定單詞向量和單詞分類器:語言建模的損失框架”的實現

本文試圖利用單詞的多樣性來訓練深層神經網絡。

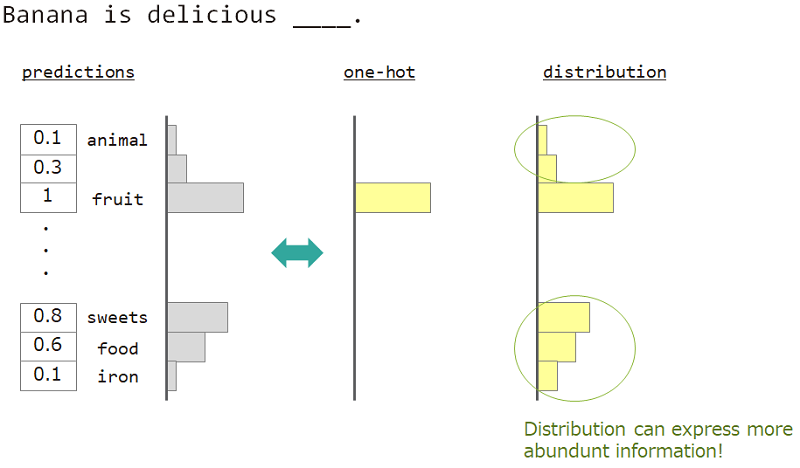

在語言建模(單詞序列的預測)中,我們想表達單詞含義的多樣性。

例如,當預測“香蕉是美味的___”旁邊的單詞時,答案是“水果”,但“ sweets”,“食物”也可以。但是,普通的一旋向量教學不適合實現它。因為任何類似的詞都被忽略了,但是確切的答案詞。

如果我們不能使用一局,而是“分發”,我們可以教這個品種。

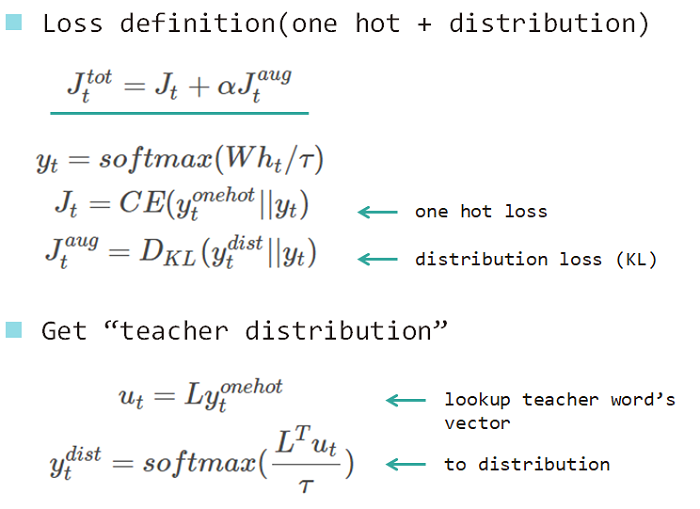

因此,我們使用“單詞的分佈”來教授模型。此分佈是從答案單詞獲得的,並嵌入了查找矩陣。

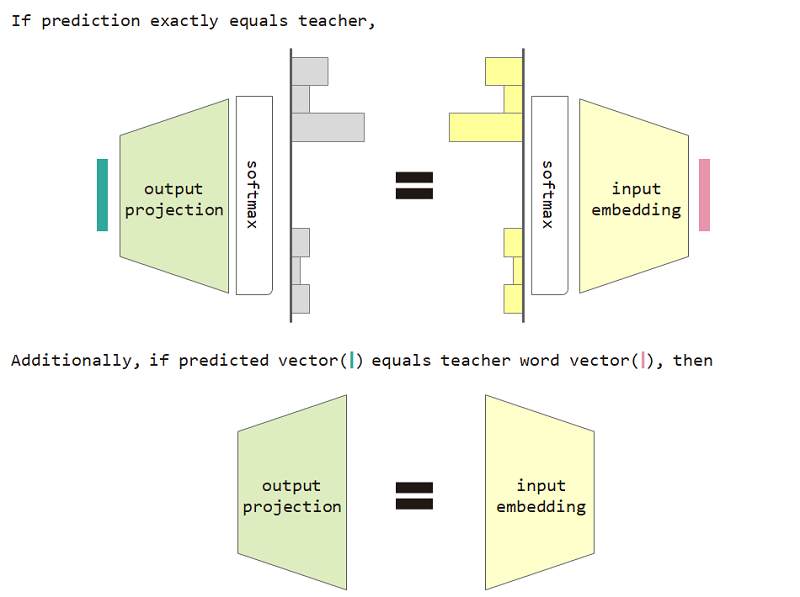

如果我們使用此分佈類型損失,那麼我們可以證明輸入嵌入和輸出投影矩陣之間的等效性。

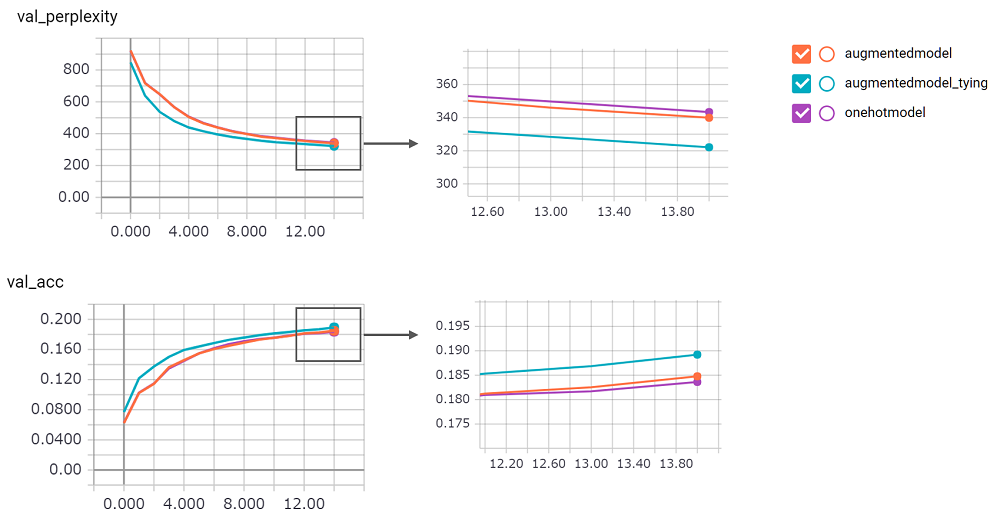

使用分佈類型損失和輸入嵌入和輸出投影等價限制可改善模型的困惑。

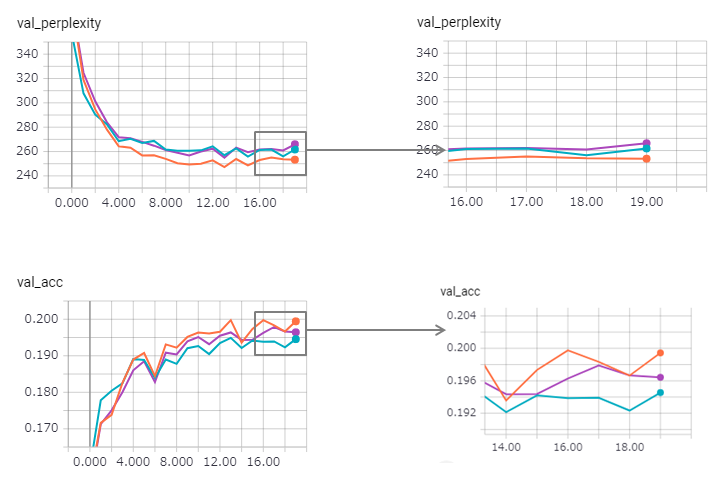

perplexity得分很高,我對其實施不信心。我在等拉請求!augmentedmodel比基線( onehotmodel )更好,並且augmentedmodel_tying表現優於基線!python train.py進行此實驗我實施了狀態LSTM版本。其結果如下。

複雜性得到改善(但Zaggy),而綁定的方法略有失去其效果。

在keras中使用狀態的LSTM太難了(尤其是驗證集中的reset_states ),因此可能包含一定的限制。

順便說一句,Pytorch示例已經使用了綁定方法!不要害怕使用它!