該存儲庫包含來自巴基斯坦各種新聞網站的大量新聞文章。數據集涵蓋了不同類別,包括:

我們評估了幾種大型語言模型(LLMS),以從刮擦的新聞文章中生成問答對:

我們的案例研究表明,儘管Llama2提供了最佳質量,但與GPT型號相比較慢。 T5-small雖然很快,但在準確性和重複方面有局限性。因此,我們使用GPT-3.5 Turbo和GPT-4來生成更實質性的數據集。

該數據集是開源的,可用於:

此外,我們在此數據集上還進行了微調的小駱駝。

| Llama2 | T5-small | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

| GPT-3.5-Turbo | GPT-4 | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

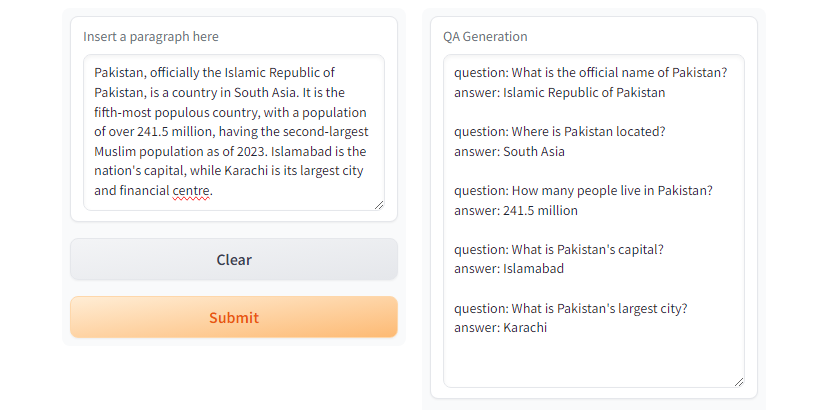

GPT3.5-Turbo和GPT4產生所需的響應。 圖。使用

圖。使用T5-small的Gradio演示

git clone https://github.com/faizan1234567/QALLM.git

cd QALLM使用Python Venv創建虛擬環境

python3 -m venv qa_llm

source qa_llm/bin/activate另外,您可以使用Anaconda軟件包管理器

conda create -n qa_llm python=3.8.10 -y

conda activate qa_llm現在安裝所有必需的依賴項

pip install --upgrade pip

pip install -r requirements.txtQA生成,請確保讀取和理解配置並根據需要替換適當的值。

python create_alpaca_format_dataset.py --chunk_size 5000 --dataset < path >並運行質量檢查

python qa_generator.py --model T5-small --cfg cfg/qa_generator.yaml在notebooks目錄下有一個run_qa_llm_repo.ipynb ,可以在Google Colab,Kaggle,漸變,漸變或使用GPU的本地機器上安裝和運行質量檢查。

如果您發現數據集可用於微調,研究和開發目的,請出演並引用回購:

穆罕默德·法贊(Muhammad Faizan)和薩娜·紮法爾(Sana Zafar)

@misc{QALLM,

title={NewsQA: News Dataset for QA Generation},

authors={Muhammad Faizan and Sana Zafar},

howpublished = { url {https://github.com/faizan1234567/QALLM}},

year={2024}

}[1]。快速而有力的刮擦和網絡爬網框架。砂紙。 (nd)。 https://scrapy.org/

[2]。 https://huggingface.co/thebloke/llama-2-70b-ggml。 (nd)。

[3]。 Ushio,A.,Alva-Manchego,F。和Camacho-Collados,J。 (2023)。基於LM的問答生成方法的經驗比較。 ARXIV預印型ARXIV:2305.17002。

[4]。 Openai的GPT-3.5 Turbo,Platform.openai.com/docs/models/gpt-3-5-turbo。 2024年7月28日訪問。