Este repositório contém um grande conjunto de dados de artigos de notícias raspados em vários sites de notícias paquistaneses. O conjunto de dados abrange diversas categorias, incluindo:

Avaliamos vários modelos de idiomas grandes (LLMs) para gerar pares de perguntas e respostas a partir dos artigos de notícias raspados:

Nosso estudo de caso revelou que, embora o LLAMA2 oferece a melhor qualidade, ele é mais lento em comparação com os modelos GPT. T5-small , embora rápido, tem limitações de precisão e duplicação. Consequentemente, usamos GPT-3.5 Turbo e GPT-4 para gerar um conjunto de dados mais substancial.

Este conjunto de dados é de código aberto e pode ser usado para:

Além disso, temos uma pequena llama de ajuste fino neste conjunto de dados.

| Llama2 | T5-small | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

| GPT-3.5-Turbo | GPT-4 | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

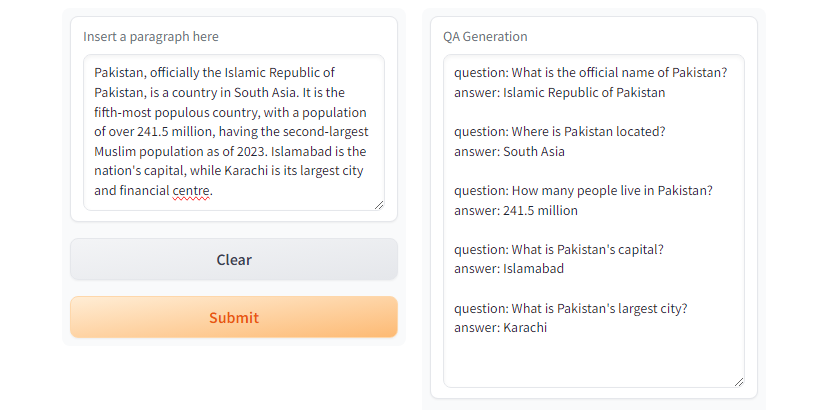

GPT3.5-Turbo e GPT4 gera resposta desejada. Fig. Gradio Demo usando

Fig. Gradio Demo usando T5-small

git clone https://github.com/faizan1234567/QALLM.git

cd QALLMCrie um ambiente virtual usando Python Venv

python3 -m venv qa_llm

source qa_llm/bin/activateComo alternativa, você pode usar o Anaconda Package Manager

conda create -n qa_llm python=3.8.10 -y

conda activate qa_llmAgora instale todas as dependências necessárias

pip install --upgrade pip

pip install -r requirements.txtGeração de controle de qualidade, certifique -se de ler e entender as configurações e substituir os valores apropriados conforme necessário.

python create_alpaca_format_dataset.py --chunk_size 5000 --dataset < path >e executar a geração de controle de qualidade

python qa_generator.py --model T5-small --cfg cfg/qa_generator.yaml E existe um diretório run_qa_llm_repo.ipynb no notebooks para instalar e executar o controle de qualidade no Google Colab, Kaggle, Gradient ou Machine local com GPU.

Se você achar o conjunto de dados útil para fins de ajuste fino, de pesquisa e desenvolvimento, por favor, estrela e cite o repositório:

Muhammad Faizan e Sana Zafar

@misc{QALLM,

title={NewsQA: News Dataset for QA Generation},

authors={Muhammad Faizan and Sana Zafar},

howpublished = { url {https://github.com/faizan1234567/QALLM}},

year={2024}

}[1]. Uma estrutura rápida e poderosa de raspagem e rastreamento da web. Scrapy. (ND). https://scrapy.org/

[2]. https://huggingface.co/thebloke/llama-2-70b-ggml. (ND).

[3]. Ushio, A., Alva-Manchego, F., & Camacho-Collados, J. (2023). Uma comparação empírica dos métodos de geração de perguntas e respostas baseadas em LM. ARXIV ARXIV ARXIV: 2305.17002.

[4]. GPT-3.5 Turbo, Platform.openai.com/docs/models/GPT-3-5-Turbo. Acesso em 28 de julho de 2024.