يحتوي هذا المستودع على مجموعة بيانات كبيرة من المقالات الإخبارية المكسورة من مختلف مواقع الأخبار الباكستانية. تغطي مجموعة البيانات فئات متنوعة بما في ذلك:

قمنا بتقييم العديد من نماذج اللغة الكبيرة (LLMS) لإنشاء أزواج إجابات أسئلة من المقالات الإخبارية المكثفة:

كشفت دراسة الحالة الخاصة بنا أنه على الرغم من أن LLAMA2 تقدم أفضل جودة ، إلا أنها أبطأ مقارنة بنماذج GPT. T5-small ، على الرغم من سريع ، لديها قيود في الدقة والازدواج. وبالتالي ، استخدمنا GPT-3.5 Turbo و GPT-4 لإنشاء مجموعة بيانات أكثر جوهرية.

مجموعة البيانات هذه مفتوحة المصدر ويمكن استخدامها لـ:

بالإضافة إلى ذلك ، لدينا LAMA TINE تم ضبطه على مجموعة البيانات هذه.

| Llama2 | T5-small | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

| GPT-3.5 توربو | GPT-4 | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

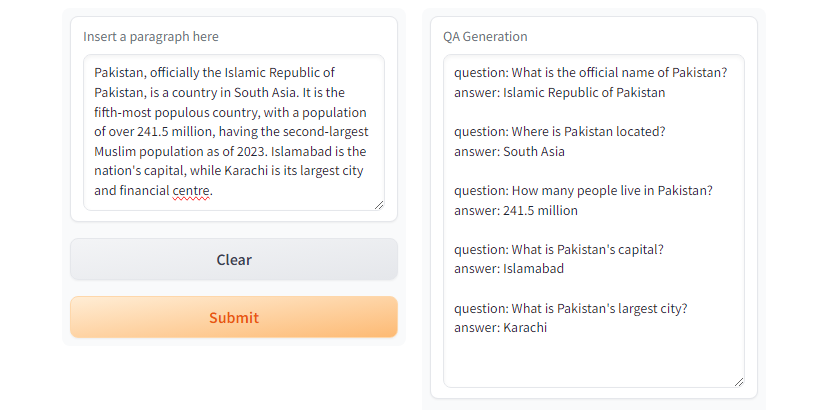

GPT3.5-Turbo و GPT4 يولد الاستجابة المطلوبة. الشكل. تجريبي باستخدام

الشكل. تجريبي باستخدام T5-small

git clone https://github.com/faizan1234567/QALLM.git

cd QALLMإنشاء enviroment افتراضية باستخدام Python Venv

python3 -m venv qa_llm

source qa_llm/bin/activateبدلاً من ذلك ، يمكنك استخدام مدير حزم Anaconda

conda create -n qa_llm python=3.8.10 -y

conda activate qa_llmالآن تثبيت جميع التبعيات المطلوبة

pip install --upgrade pip

pip install -r requirements.txtجيل ضمان الجودة ، تأكد من قراءة وفهم التكوينات واستبدال القيم المناسبة كما هو مطلوب.

python create_alpaca_format_dataset.py --chunk_size 5000 --dataset < path >وتشغيل جيل ضمان الجودة

python qa_generator.py --model T5-small --cfg cfg/qa_generator.yaml وهناك run_qa_llm_repo.ipynb ضمن دليل notebooks لتثبيت QA وتشغيله على Google Colab أو Kaggle أو التدرج أو الجهاز المحلي مع GPU.

إذا وجدت مجموعة البيانات مفيدة لأغراض الضبط والبحث والتطوير ، فيرجى Star & Cite the Repo:

محمد فايزان وسانا ظفر

@misc{QALLM,

title={NewsQA: News Dataset for QA Generation},

authors={Muhammad Faizan and Sana Zafar},

howpublished = { url {https://github.com/faizan1234567/QALLM}},

year={2024}

}[1]. إطار عمل سريع وقوي على شبكة الإنترنت. Scrapy. (اختصار الثاني). https://scrapy.org/

[2]. https://huggingface.co/thebloke/llama-2-70b-ggml. (اختصار الثاني).

[3]. Ushio ، A. ، Alva-Manchego ، F. ، & Camacho-Collados ، J. (2023). مقارنة تجريبية لطرق توليد الأسئلة القائمة على LM. Arxiv preprint Arxiv: 2305.17002.

[4]. Openai's GPT-3.5 Turbo ، platform.openai.com/docs/models/gpt-3-5-turbo. تم الوصول إليه في 28 يوليو 2024.