Ce référentiel contient un grand ensemble de données d'articles de presse arrachés à partir de divers sites d'information pakistanais. L'ensemble de données couvre diverses catégories, notamment:

Nous avons évalué plusieurs grands modèles de langage (LLMS) pour générer des paires de réponses à des questions à partir des articles de presse racinés:

Notre étude de cas a révélé que si LLAMA2 offre la meilleure qualité, elle est plus lente par rapport aux modèles GPT. T5-small , bien que rapide, a des limites de précision et de duplication. Par conséquent, nous avons utilisé GPT-3.5 Turbo et GPT-4 pour générer un ensemble de données plus substantiel.

Cet ensemble de données est open-source et peut être utilisé pour:

De plus, nous avons un petit Llama affiné sur cet ensemble de données.

| Lama2 | T5-petit | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

| GPT-3,5-turbo | Gpt-4 | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

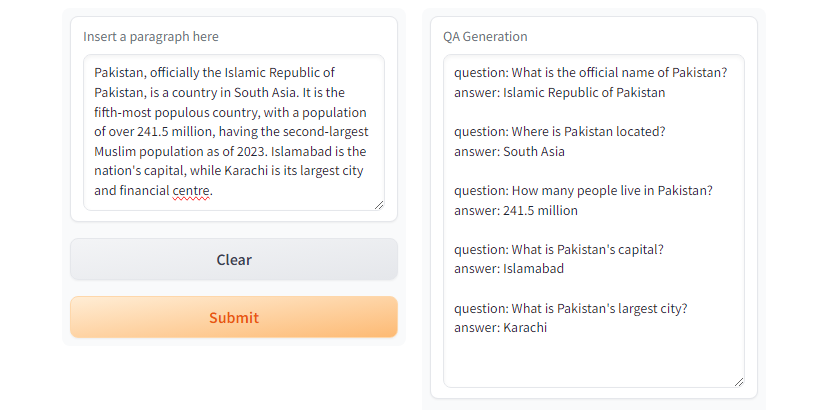

GPT3.5-Turbo et GPT4 génèrent la réponse souhaitée. Fig. Demo Gradio en utilisant

Fig. Demo Gradio en utilisant T5-small

git clone https://github.com/faizan1234567/QALLM.git

cd QALLMCréer un environnement virtuel à l'aide de Python Venv

python3 -m venv qa_llm

source qa_llm/bin/activateAlternativement, vous pouvez utiliser Anaconda Package Manager

conda create -n qa_llm python=3.8.10 -y

conda activate qa_llmInstallez maintenant toutes les dépendances requises

pip install --upgrade pip

pip install -r requirements.txtGénération d'AQ, assurez-vous de lire et de comprendre les configurations et de remplacer les valeurs appropriées selon les besoins.

python create_alpaca_format_dataset.py --chunk_size 5000 --dataset < path >et exécuter la génération QA

python qa_generator.py --model T5-small --cfg cfg/qa_generator.yaml Et il y a un répertoire run_qa_llm_repo.ipynb sous notebooks pour installer et exécuter le QA sur Google Colab, Kaggle, Gradient ou Machine local avec GPU.

Si vous trouvez l'ensemble de données utile à des fins de réglage, de recherche et de développement, veuillez jouer et citer le repo:

Muhammad Faizan et Sana Zafar

@misc{QALLM,

title={NewsQA: News Dataset for QA Generation},

authors={Muhammad Faizan and Sana Zafar},

howpublished = { url {https://github.com/faizan1234567/QALLM}},

year={2024}

}[1]. Un cadre de grattage et de rampage Web rapide et puissant. Scrapie. (nd). https://scrapy.org/

[2]. https://huggingface.co/thebloke/llama-2-70b-ggml. (nd).

[3]. Ushio, A., Alva-Manchego, F., et Camacho-Collados, J. (2023). Une comparaison empirique des méthodes de génération de questions et de réponses basées sur LM. ARXIV PRÉALLAGE ARXIV: 2305.17002.

[4]. GPT-3.5 Turbo d'Openai, Platform.openai.com/docs/models/gpt-3-5-turbo. Consulté le 28 juillet 2024.