Repositori ini berisi set data besar artikel berita yang dikikis dari berbagai situs web berita Pakistan. Dataset mencakup beragam kategori termasuk:

Kami mengevaluasi beberapa model bahasa besar (LLM) untuk menghasilkan pasangan jawaban pertanyaan dari artikel berita yang dikikis:

Studi kasus kami mengungkapkan bahwa sementara LLAMA2 menawarkan kualitas terbaik, itu lebih lambat dibandingkan dengan model GPT. T5-small , meskipun cepat, memiliki keterbatasan dalam akurasi dan duplikasi. Akibatnya, kami menggunakan GPT-3.5 Turbo dan GPT-4 untuk menghasilkan dataset yang lebih substansial.

Dataset ini open-source dan dapat digunakan untuk:

Selain itu, kami memiliki llama kecil yang disempurnakan pada dataset ini.

| Llama2 | T5-Small | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

| GPT-3.5-turbo | GPT-4 | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

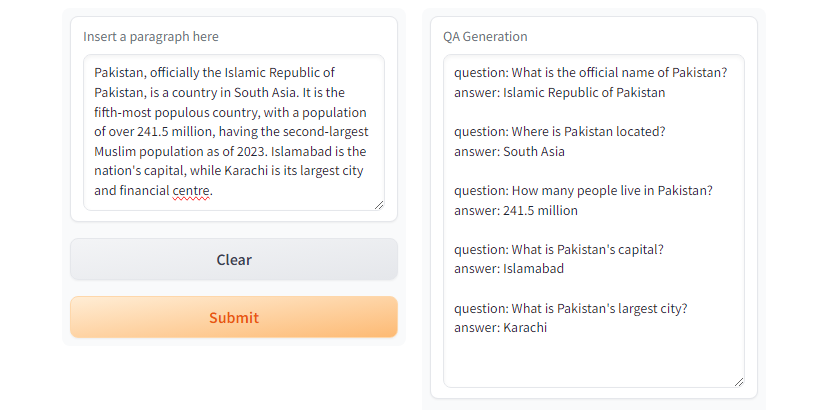

GPT3.5-Turbo dan GPT4 menghasilkan respons yang diinginkan. Gbr. Demo Gradio Menggunakan

Gbr. Demo Gradio Menggunakan T5-small

git clone https://github.com/faizan1234567/QALLM.git

cd QALLMBuat lingkungan virtual menggunakan python venv

python3 -m venv qa_llm

source qa_llm/bin/activateAtau, Anda dapat menggunakan Anaconda Package Manager

conda create -n qa_llm python=3.8.10 -y

conda activate qa_llmSekarang pasang semua dependensi yang diperlukan

pip install --upgrade pip

pip install -r requirements.txtGenerasi QA, pastikan untuk membaca dan memahami konfigurasi dan mengganti nilai yang sesuai sesuai kebutuhan.

python create_alpaca_format_dataset.py --chunk_size 5000 --dataset < path >dan menjalankan generasi QA

python qa_generator.py --model T5-small --cfg cfg/qa_generator.yaml Dan ada run_qa_llm_repo.ipynb di bawah notebooks direktori untuk menginstal dan menjalankan QA di Google Colab, Kaggle, Gradient, atau mesin lokal dengan GPU.

Jika Anda menemukan dataset yang berguna untuk tujuan penyempurnaan, penelitian, dan pengembangan, silakan membintangi & mengutip repo:

Muhammad Faizan dan Sana Zafar

@misc{QALLM,

title={NewsQA: News Dataset for QA Generation},

authors={Muhammad Faizan and Sana Zafar},

howpublished = { url {https://github.com/faizan1234567/QALLM}},

year={2024}

}[1]. Kerangka kerja merayap dan perayapan web yang cepat dan kuat. Gesekan. (nd). https://scrapy.org/

[2]. https://huggingface.co/thebloke/llama-2-70b-ggml. (nd).

[3]. Ushio, A., Alva-Manchego, F., & Camacho-Collados, J. (2023). Perbandingan empiris metode pembuatan tanya jawab berbasis LM. ARXIV Preprint ARXIV: 2305.17002.

[4]. Openai's GPT-3.5 Turbo, platform.openai.com/docs/models/gpt-3-5-TURBO. Diakses 28 Juli 2024.