Этот репозиторий содержит большой набор данных новостных статей, соскобавшихся с различных пакистанских новостных сайтов. Набор данных охватывает различные категории, включая:

Мы оценили несколько крупных языковых моделей (LLMS) для создания пар вопросов-ответов из сокраженных новостных статей:

Наше тематическое исследование показало, что, хотя Llama2 предлагает лучшее качество, оно медленнее по сравнению с моделями GPT. T5-small , хотя и быстрый, имеет ограничения в точности и дублировании. Следовательно, мы использовали GPT-3.5 Turbo и GPT-4 для создания более существенного набора данных.

Этот набор данных является открытым исходным кодом и может быть использован для:

Кроме того, у нас есть тонкая крошечная лама в этом наборе данных.

| Лама2 | T5-Small | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

| GPT-3.5-Turbo | GPT-4 | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

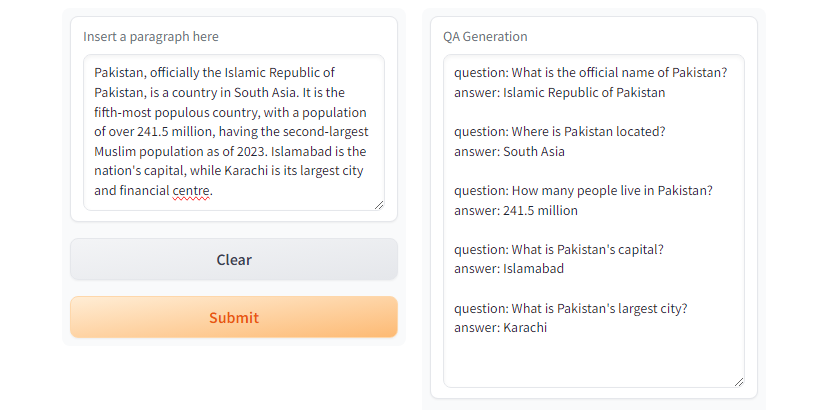

GPT3.5-Turbo и GPT4 генерируют желаемый ответ. Рис. Demo с использованием

Рис. Demo с использованием T5-small

git clone https://github.com/faizan1234567/QALLM.git

cd QALLMСоздать виртуальную среду с использованием Python venv

python3 -m venv qa_llm

source qa_llm/bin/activateВ качестве альтернативы, вы можете использовать диспетчер пакетов Anaconda

conda create -n qa_llm python=3.8.10 -y

conda activate qa_llmТеперь установите все необходимые зависимости

pip install --upgrade pip

pip install -r requirements.txtГенерация QA, обязательно прочитайте и понимаете конфигурации и замените соответствующие значения по мере необходимости.

python create_alpaca_format_dataset.py --chunk_size 5000 --dataset < path >и запустить поколение качества

python qa_generator.py --model T5-small --cfg cfg/qa_generator.yaml И есть run_qa_llm_repo.ipynb в соответствии с каталогом notebooks для установки и запуска QA на Google Colab, Kaggle, Gradient или Local Machine с GPU.

Если вы найдете набор данных полезным для точной настройки, исследований и разработки, пожалуйста, смотрите и цитируйте репо:

Мухаммед Файзан и Сана Зафар

@misc{QALLM,

title={NewsQA: News Dataset for QA Generation},

authors={Muhammad Faizan and Sana Zafar},

howpublished = { url {https://github.com/faizan1234567/QALLM}},

year={2024}

}[1]. Быстрая и мощная царапина и рамка ползания в Интернете. Скрара. (ND). https://scrapy.org/

[2]. https://huggingface.co/thebloke/llama-2-70b-ggml. (ND).

[3]. Ushio, A., Alva-Manchego, F. & Camacho-Collados, J. (2023). Эмпирическое сравнение методов генерации вопросов и ответов на основе LM. Arxiv Preprint arxiv: 2305.17002.

[4]. Openai's GPT-3.5 Turbo, Platform.openai.com/docs/models/gpt-3-5-turbo. Доступ 28 июля 2024 года.