Este repositorio contiene un gran conjunto de datos de artículos de noticias raspados de varios sitios web de noticias paquistaníes. El conjunto de datos cubre diversas categorías que incluyen:

Evaluamos varios modelos de idiomas grandes (LLM) para generar pares de respuesta de preguntas de los artículos de noticias raspados:

Nuestro estudio de caso reveló que si bien LLAMA2 ofrece la mejor calidad, es más lento en comparación con los modelos GPT. T5-small , aunque rápido, tiene limitaciones en precisión y duplicación. En consecuencia, utilizamos GPT-3.5 Turbo y GPT-4 para generar un conjunto de datos más sustancial.

Este conjunto de datos es de código abierto y puede usarse para:

Además, hemos ajustado Tiny Llama en este conjunto de datos.

| Llama2 | T5-pequeña | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

| GPT-3.5-TURBO | GPT-4 | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

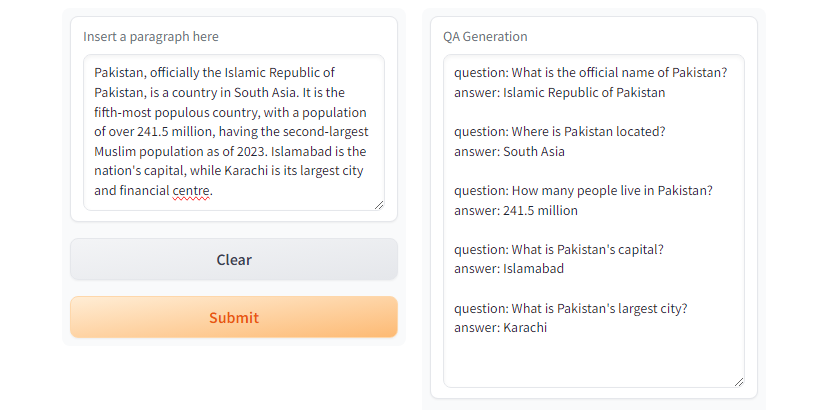

GPT3.5-Turbo y GPT4 genera la respuesta deseada.  Fig. Gradio Demo usando

Fig. Gradio Demo usando T5-small

git clone https://github.com/faizan1234567/QALLM.git

cd QALLMCrea un entorno virtual usando Python Venv

python3 -m venv qa_llm

source qa_llm/bin/activateAlternativamente, puede usar Anaconda Package Manager

conda create -n qa_llm python=3.8.10 -y

conda activate qa_llmAhora instale todas las dependencias requeridas

pip install --upgrade pip

pip install -r requirements.txtGeneración de QA, asegúrese de leer y comprender las configuraciones y reemplazar los valores apropiados según sea necesario.

python create_alpaca_format_dataset.py --chunk_size 5000 --dataset < path >y ejecutar la generación de control de calidad

python qa_generator.py --model T5-small --cfg cfg/qa_generator.yaml Y hay un directorio run_qa_llm_repo.ipynb en el directorio notebooks para instalar y ejecutar el control de calidad en Google Colab, Kaggle, Gradiente o Máquina Local con GPU.

Si encuentra el conjunto de datos útil para ajustar, investigación y fines de desarrollo, estrella y cita el repositorio:

Muhammad Faizan y Sana Zafar

@misc{QALLM,

title={NewsQA: News Dataset for QA Generation},

authors={Muhammad Faizan and Sana Zafar},

howpublished = { url {https://github.com/faizan1234567/QALLM}},

year={2024}

}[1]. Un marco rápido y potente de rasguño y rastreo web. Screapy. (Dakota del Norte). https://scrapy.org/

[2]. https://huggingface.co/thebloke/llama-2-70b-ggml. (Dakota del Norte).

[3]. Ushio, A., Alva-Manch con, F. y Camacho-Collados, J. (2023). Una comparación empírica de los métodos de generación de preguntas y respuestas basados en LM. preimpresión ARXIV ARXIV: 2305.17002.

[4]. GPT-3.5 Turbo, plataforma.openai.com/docs/models/gpt-3-5-turbo. Consultado el 28 de julio de 2024.