พื้นที่เก็บข้อมูลนี้มีชุดข้อมูลขนาดใหญ่ของบทความข่าวที่คัดลอกมาจากเว็บไซต์ข่าวต่าง ๆ ของปากีสถาน ชุดข้อมูลครอบคลุมหมวดหมู่ที่หลากหลายรวมถึง:

เราประเมินแบบจำลองภาษาขนาดใหญ่หลายแบบ (LLMs) สำหรับการสร้างคู่คำถามตอบคำถามจากบทความข่าวที่ถูกคัดลอกมา:

กรณีศึกษาของเราเปิดเผยว่าในขณะที่ LLAMA2 มีคุณภาพดีที่สุดมันช้ากว่าเมื่อเทียบกับรุ่น GPT T5-small แม้ว่าจะเร็ว แต่ก็มีข้อ จำกัด ด้านความแม่นยำและการทำซ้ำ ดังนั้นเราจึงใช้ GPT-3.5 Turbo และ GPT-4 เพื่อสร้างชุดข้อมูลที่สำคัญยิ่งขึ้น

ชุดข้อมูลนี้เป็นโอเพ่นซอร์สและสามารถใช้สำหรับ:

นอกจากนี้เรายังมี Llama เล็ก ๆ ที่ได้รับการปรับแต่งในชุดข้อมูลนี้

| Llama2 | T5-small | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

| GPT-3.5-turbo | GPT-4 | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

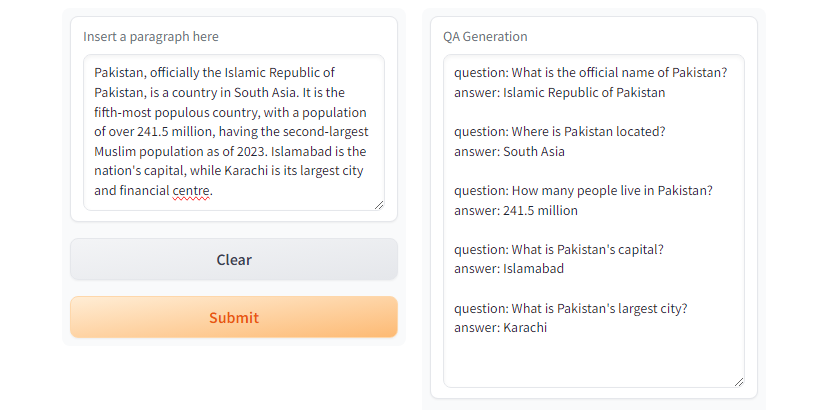

GPT3.5-Turbo และ GPT4 สร้างการตอบสนองที่ต้องการ  รูปที่ Gradio Demo โดยใช้

รูปที่ Gradio Demo โดยใช้ T5-small

git clone https://github.com/faizan1234567/QALLM.git

cd QALLMสร้างสภาพแวดล้อมเสมือนจริงโดยใช้ Python Venv

python3 -m venv qa_llm

source qa_llm/bin/activateหรือคุณสามารถใช้ Anaconda Package Manager

conda create -n qa_llm python=3.8.10 -y

conda activate qa_llmตอนนี้ติดตั้งการพึ่งพาทั้งหมดที่ต้องการ

pip install --upgrade pip

pip install -r requirements.txtการสร้าง QA ตรวจสอบให้แน่ใจว่าได้อ่านและทำความเข้าใจการกำหนดค่าและแทนที่ค่าที่เหมาะสมตามที่ต้องการ

python create_alpaca_format_dataset.py --chunk_size 5000 --dataset < path >และเรียกใช้รุ่น QA

python qa_generator.py --model T5-small --cfg cfg/qa_generator.yaml และมี run_qa_llm_repo.ipynb ภายใต้ไดเรกทอรี notebooks เพื่อติดตั้งและเรียกใช้ QA บน Google Colab, Kaggle, GRADIET หรือเครื่องจักรในท้องถิ่นด้วย GPU

หากคุณพบว่าชุดข้อมูลมีประโยชน์สำหรับการปรับจูนการวิจัยและการพัฒนาอย่างละเอียดโปรดแสดงและอ้างอิง repo:

Muhammad Faizan และ Sana Zafar

@misc{QALLM,

title={NewsQA: News Dataset for QA Generation},

authors={Muhammad Faizan and Sana Zafar},

howpublished = { url {https://github.com/faizan1234567/QALLM}},

year={2024}

}[1]. กรอบการขูดที่รวดเร็วและทรงพลังและการรวบรวมข้อมูลเว็บ การทำลาย (ND) https://scrapy.org/

[2]. https://huggingface.co/thebloke/llama-2-70b-ggml (ND)

[3]. Ushio, A. , Alva-Manchego, F. , & Camacho-Collados, J. (2023) การเปรียบเทียบเชิงประจักษ์ของคำถามและวิธีการสร้างคำตอบที่ใช้ LM arxiv preprint arxiv: 2305.17002

[4]. GPT-3.5 Turbo ของ OpenAi, platform.openai.com/docs/models/gpt-3-5-turbo เข้าถึง 28 กรกฎาคม 2567