이 저장소에는 다양한 파키스탄 뉴스 웹 사이트에서 긁힌 뉴스 기사 데이터 세트가 포함되어 있습니다. 데이터 세트는 다음을 포함한 다양한 범주를 다룹니다.

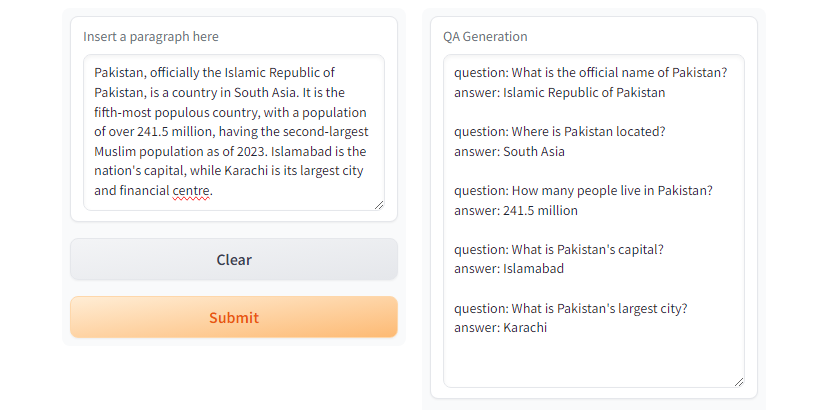

우리는 긁힌 뉴스 기사에서 질문 응답 쌍을 생성하기 위해 몇 가지 대형 언어 모델 (LLM)을 평가했습니다.

우리의 사례 연구에 따르면 LLAMA2는 최상의 품질을 제공하지만 GPT 모델에 비해 느리게 진행됩니다. T5-small 빠르지 만 정확도와 복제에는 한계가 있습니다. 결과적으로, 우리는 GPT-3.5 Turbo 및 GPT-4 사용하여보다 실질적인 데이터 세트를 생성했습니다.

이 데이터 세트는 오픈 소스이며 다음에 사용될 수 있습니다.

또한이 데이터 세트에 미세 조정 된 작은 라마가 있습니다.

| llama2 | T5-Small | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

| GPT-3.5 터보 | GPT-4 | ||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

|

GPT3.5-Turbo 및 GPT4 원하는 응답을 생성합니다.

T5-small 사용한 Gradio 데모

git clone https://github.com/faizan1234567/QALLM.git

cd QALLMPython Venv를 사용하여 가상 환경을 만듭니다

python3 -m venv qa_llm

source qa_llm/bin/activate또는 Anaconda 패키지 관리자를 사용할 수 있습니다

conda create -n qa_llm python=3.8.10 -y

conda activate qa_llm이제 필요한 모든 종속성을 설치하십시오

pip install --upgrade pip

pip install -r requirements.txtQA 생성, 구성을 읽고 이해하고 필요에 따라 적절한 값을 교체하십시오.

python create_alpaca_format_dataset.py --chunk_size 5000 --dataset < path >QA 생성을 실행하십시오

python qa_generator.py --model T5-small --cfg cfg/qa_generator.yaml Google Colab, Kaggle, Gradient 또는 GPU와 함께 로컬 컴퓨터에서 QA를 설치하고 실행할 수있는 notebooks 디렉토리 아래에 run_qa_llm_repo.ipynb 가 있습니다.

미세 조정, 연구 및 개발 목적에 유용한 데이터 세트를 찾으려면 Repo를 Star & Incite를 인용하십시오.

무하마드 파이잔과 사나 자 파르

@misc{QALLM,

title={NewsQA: News Dataset for QA Generation},

authors={Muhammad Faizan and Sana Zafar},

howpublished = { url {https://github.com/faizan1234567/QALLM}},

year={2024}

}[1]. 빠르고 강력한 스크래핑 및 웹 크롤링 프레임 워크. 스크레이프. (nd). https://scrapy.org/

[2]. https://huggingface.co/theblake/llama-2-70b-ggml. (nd).

[3]. Ushio, A., Alva-Manchego, F., & Camacho-Collados, J. (2023). LM 기반 질문 및 답변 세대 방법의 경험적 비교. ARXIV PREPRINT ARXIV : 2305.17002.

[4]. Openai의 GPT-3.5 Turbo, Platform.openai.com/docs/models/gpt-3-5-turbo. 2024 년 7 월 28 일 접근.