PortaSpeech

v0.2.0

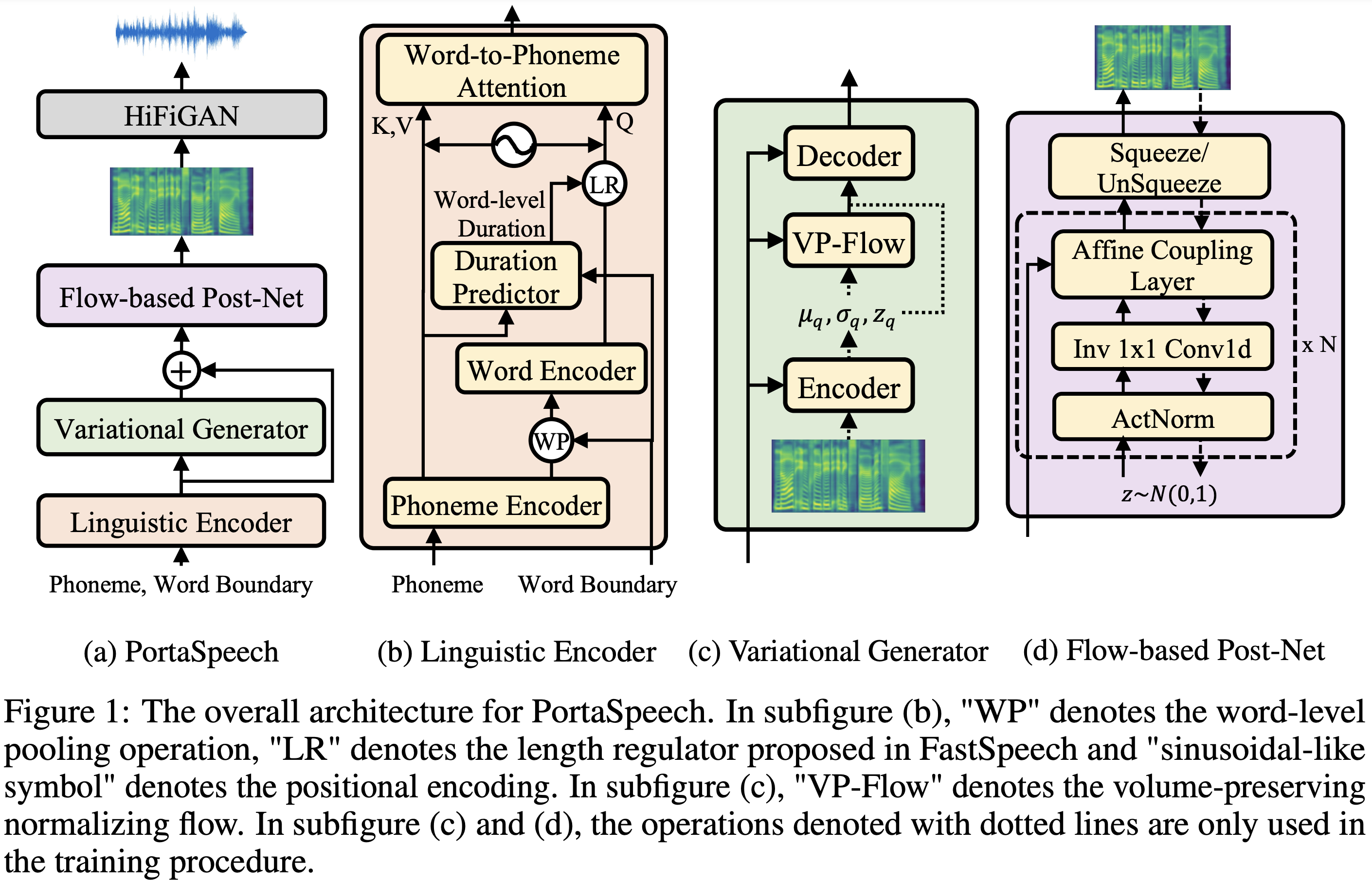

PORTASPEECH的PYTORCH實現:便攜式和高質量的生成文本到語音。

音頻樣本可在 /演示中找到。

| 模塊 | 普通的 | 小的 | 正常(紙) | 小(紙) |

|---|---|---|---|---|

| 全部的 | 24m | 76m | 2180萬 | 6.7m |

| 語言語言編碼器 | 3.7m | 14m | - | - |

| 變性生機體 | 11m | 28m | - | - |

| FlowPostnet | 9.3m | 3.4m | - | - |

數據集是指以下文檔中的數據集的名稱,例如LJSpeech 。

您可以使用

pip3 install -r requirements.txt

此外,還為Docker用戶提供Dockerfile 。

您必須下載驗證的型號,並將它們放入output/ckpt/DATASET/ 。

對於單揚聲器TTS ,運行

python3 synthesize.py --text "YOUR_DESIRED_TEXT" --restore_step RESTORE_STEP --mode single --dataset DATASET

生成的話語將放入output/result/ 。

也支持批次推理,嘗試

python3 synthesize.py --source preprocessed_data/DATASET/val.txt --restore_step RESTORE_STEP --mode batch --dataset DATASET

綜合preprocessed_data/DATASET/val.txt中的所有話語。

可以通過指定所需的持續時間比來控制合成的話語的口語速率。例如,一個人可以將口語率提高20

python3 synthesize.py --text "YOUR_DESIRED_TEXT" --restore_step RESTORE_STEP --mode single --dataset DATASET --duration_control 0.8

請注意,可控性起源於FastSpeech2,而不是PortAspeech的重要利益。

支持的數據集是

跑步

python3 prepare_align.py --dataset DATASET

用於一些準備工作。

對於強制對準,蒙特利爾強制對準器(MFA)用於獲得發音和音素序列之間的比對。此處提供了數據集的預提取對齊。您必須在preprocessed_data/DATASET/TextGrid/中解壓縮文件。或者,您可以自己運行對準器。

之後,通過

python3 preprocess.py --dataset DATASET

培訓您的模型

python3 train.py --dataset DATASET

有用的選項:

--use_amp參數附加到上述命令中。CUDA_VISIBLE_DEVICES=<GPU_IDs> 。使用

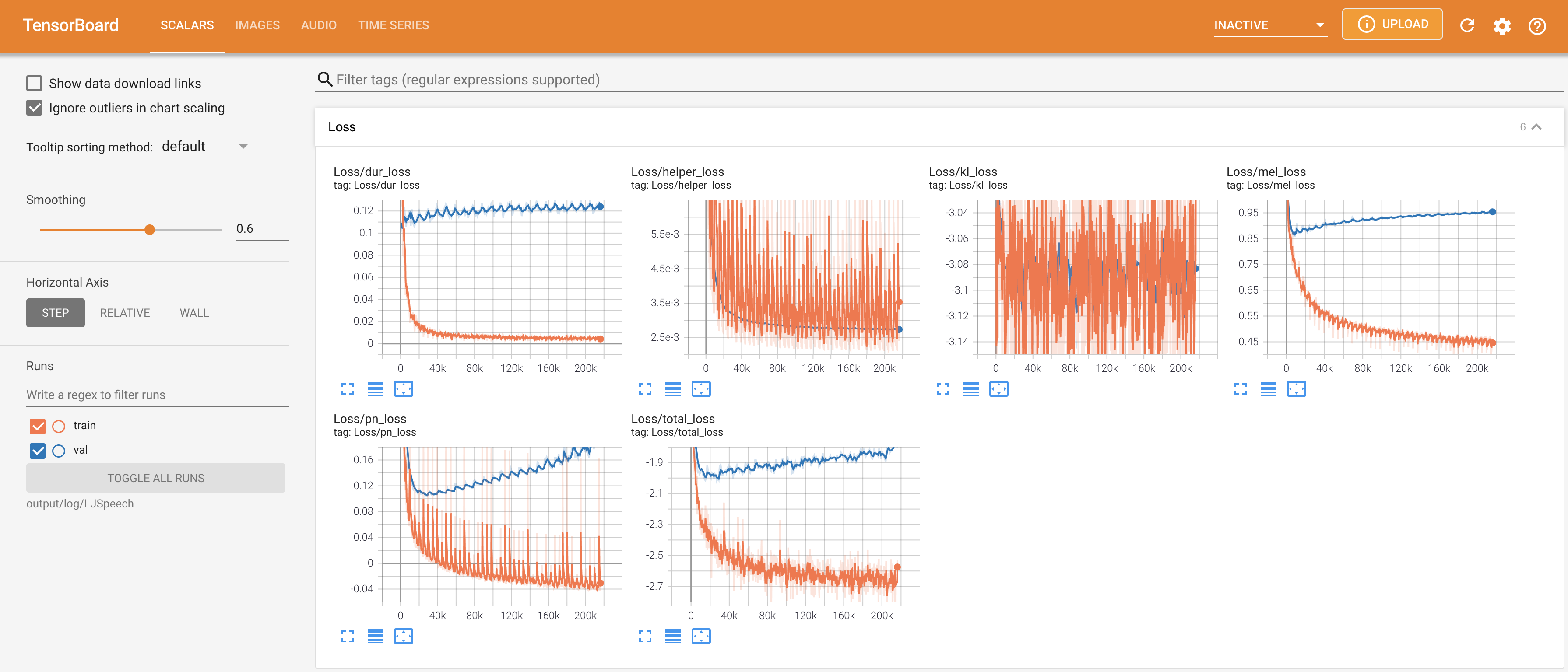

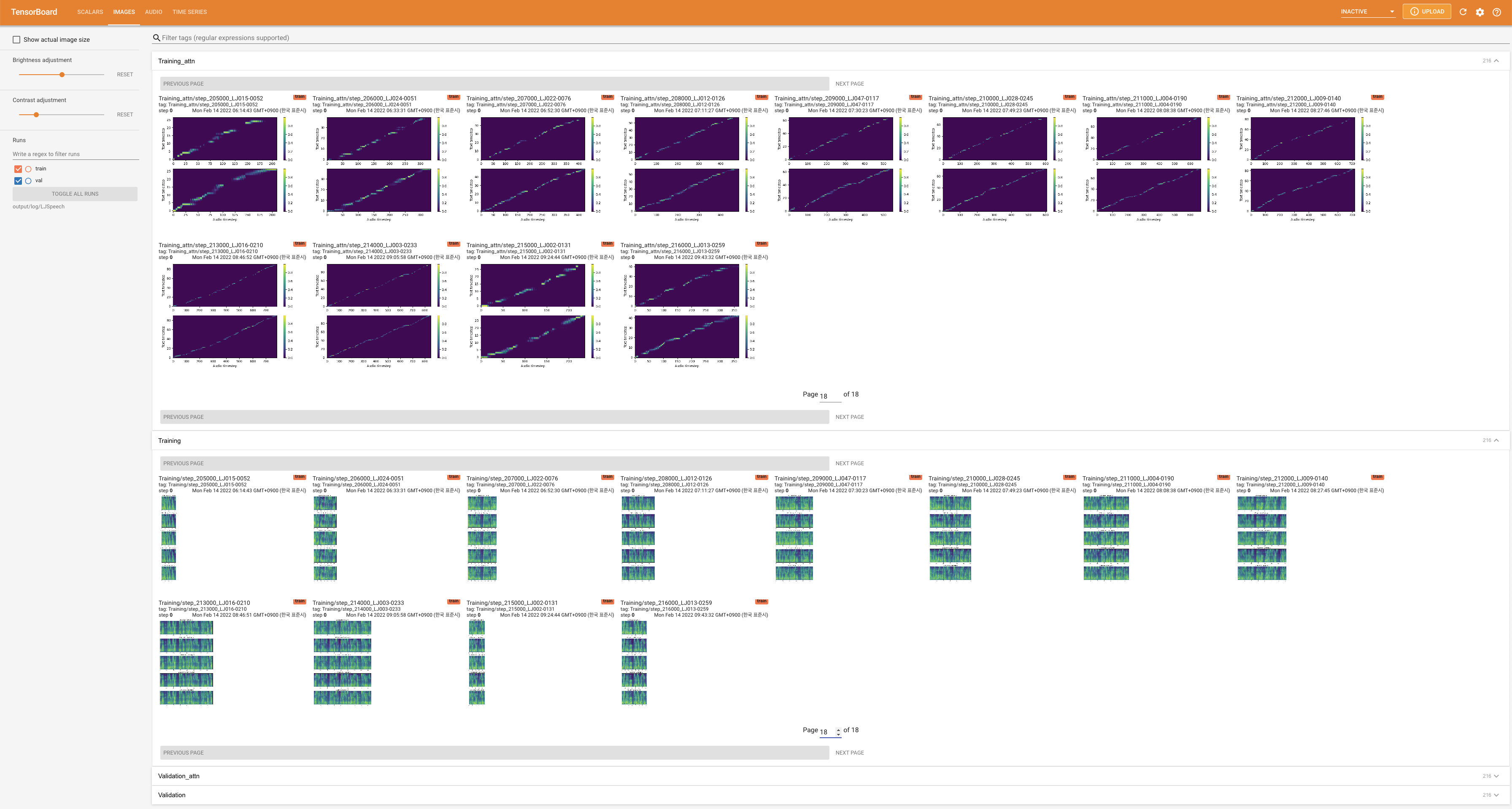

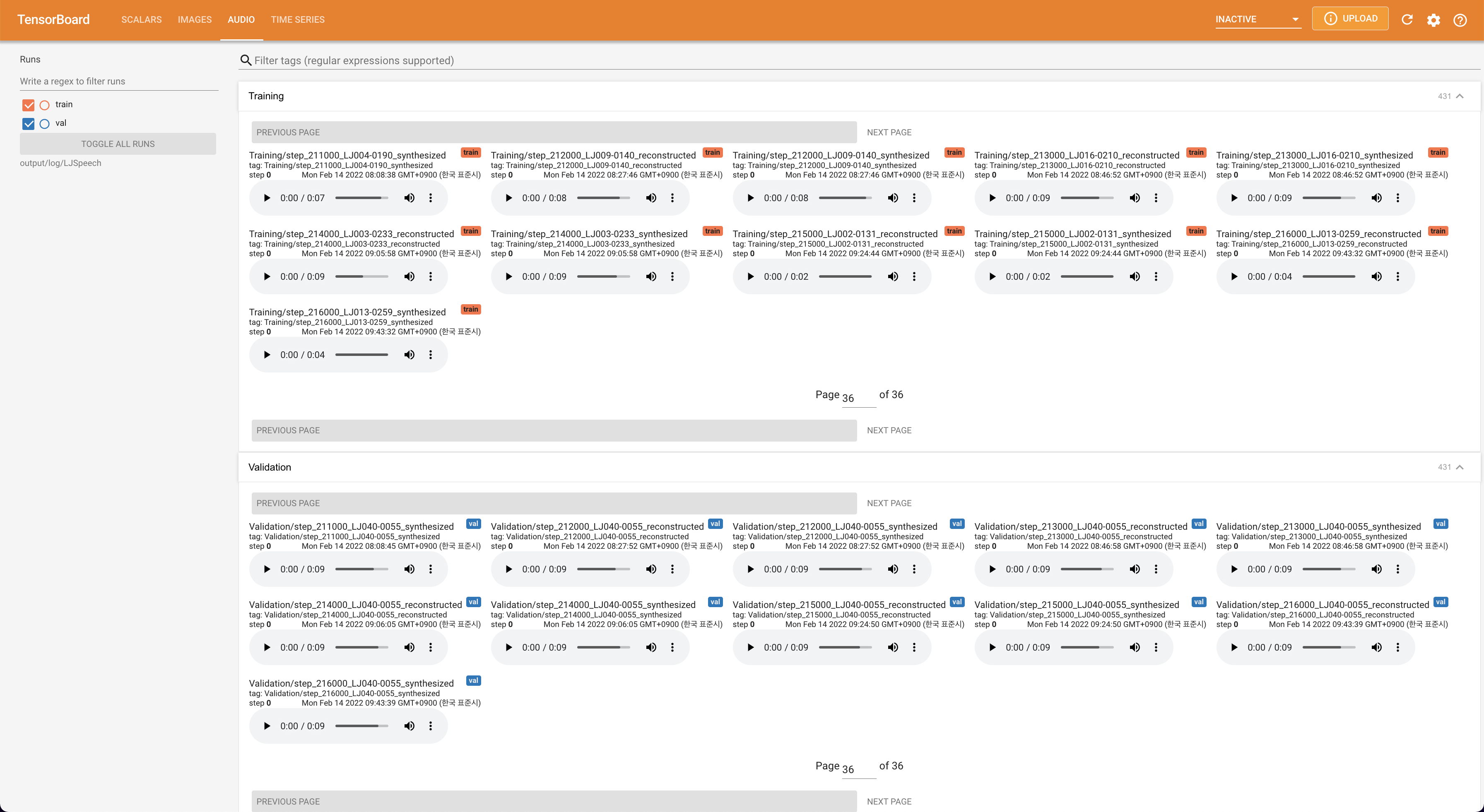

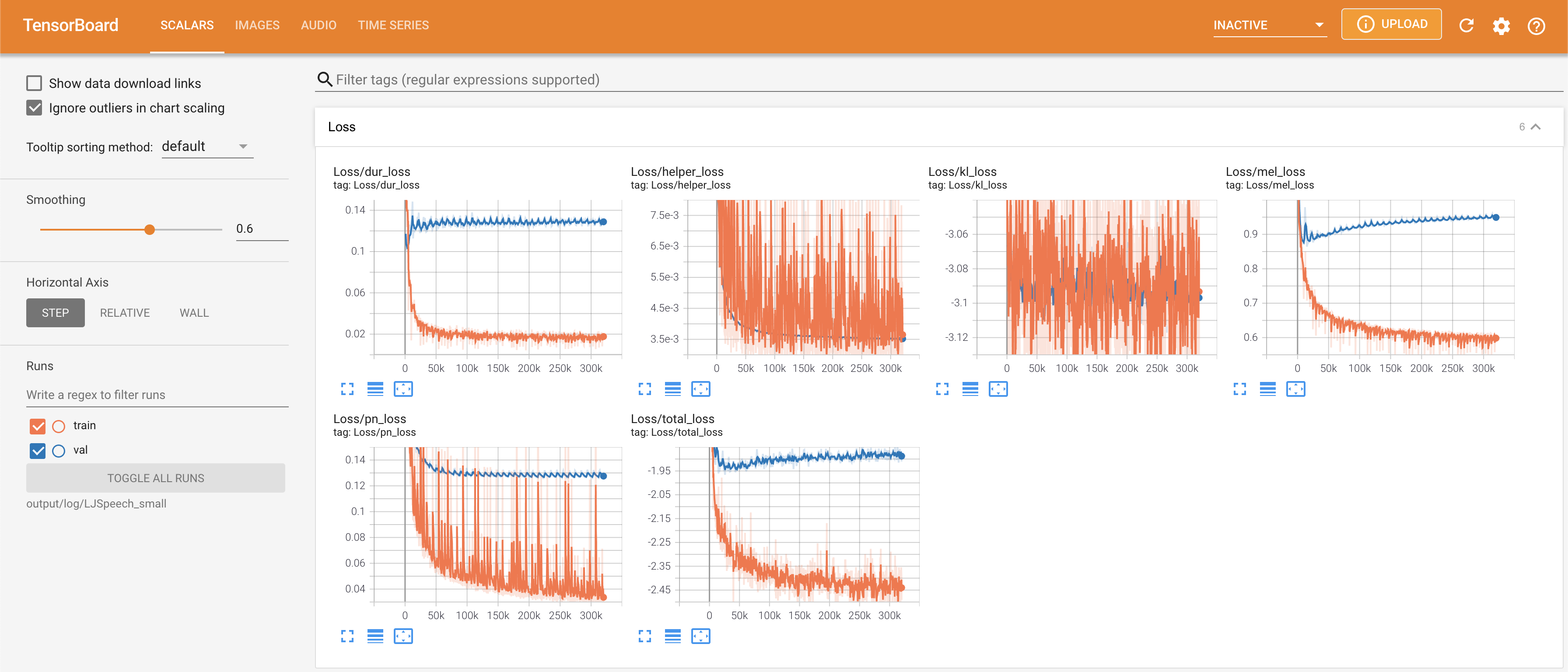

tensorboard --logdir output/log

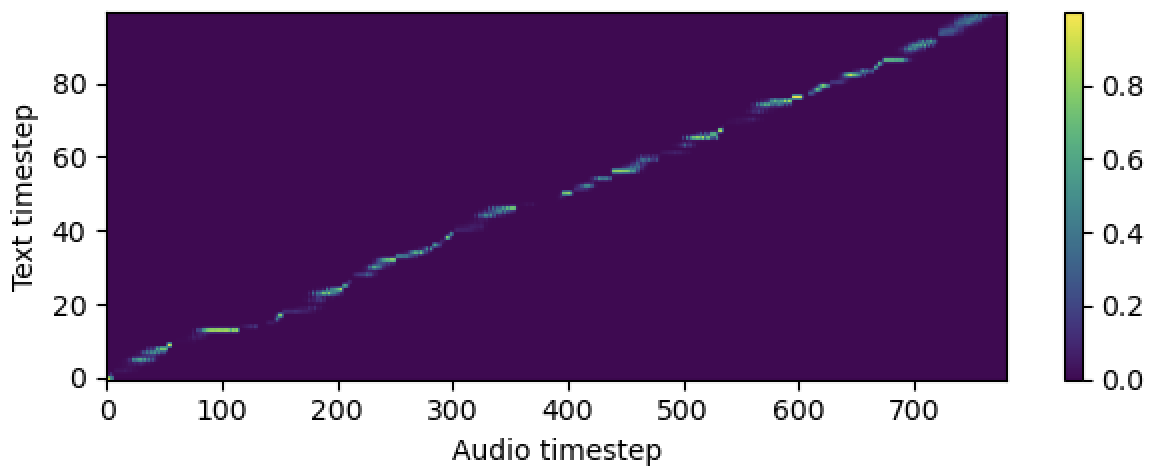

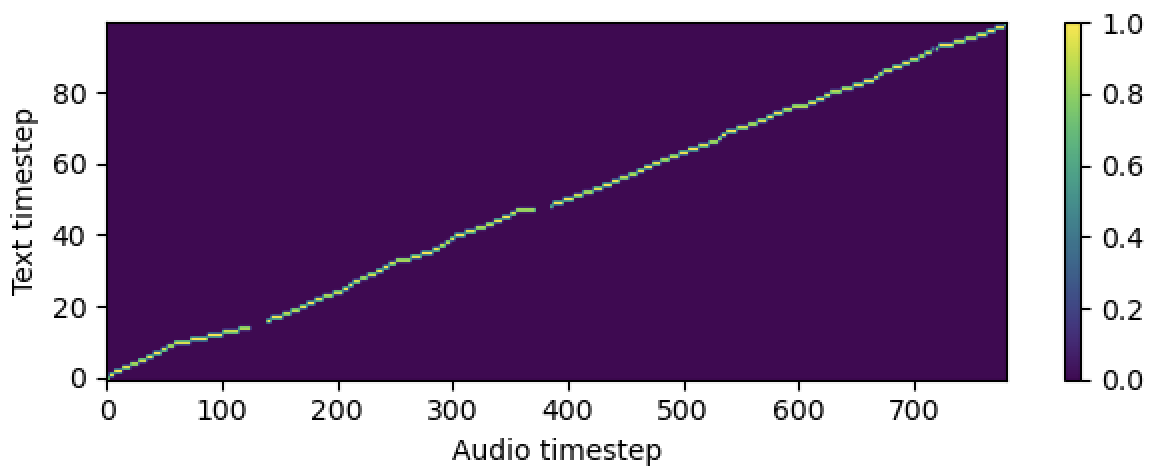

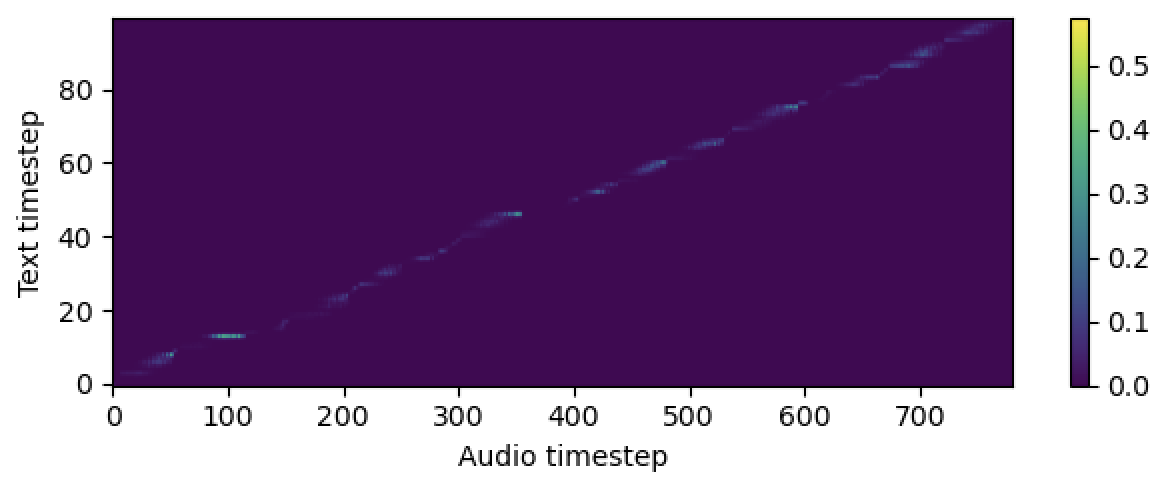

在您的本地主機上提供張板。顯示了損耗曲線,合成的MEL光譜圖和音頻。

# In the train.yaml

aligner :

helper_type : " dga " # ["dga", "ctc", "none"]

請用“引用此存儲庫”的“關於部分”(主頁的右上角)引用此存儲庫。