Pytorch PortAspeech의 구현 : 휴대용 및 고품질 생성 텍스트 음성 연설.

오디오 샘플은 /데모에서 사용할 수 있습니다.

| 기준 치수 | 정상 | 작은 | 정상 (종이) | 작은 (종이) |

|---|---|---|---|---|

| 총 | 24m | 7.6m | 21.8m | 6.7m |

| 언어 계산기 | 3.7m | 1.4m | - | - |

| 변형 알 게이터 | 11m | 2.8m | - | - |

| FlowPostnet | 9.3m | 3.4m | - | - |

데이터 세트는 다음 문서에서 LJSpeech 와 같은 데이터 세트의 이름을 나타냅니다.

파이썬 종속성을 설치할 수 있습니다

pip3 install -r requirements.txt

또한 Dockerfile Docker 사용자에게 제공됩니다.

사전 치료 된 모델을 다운로드하여 output/ckpt/DATASET/ 에 넣어야합니다.

단일 스피커 TTS 의 경우 실행하십시오

python3 synthesize.py --text "YOUR_DESIRED_TEXT" --restore_step RESTORE_STEP --mode single --dataset DATASET

생성 된 발화는 output/result/ 에 넣습니다.

배치 추론도 지원됩니다

python3 synthesize.py --source preprocessed_data/DATASET/val.txt --restore_step RESTORE_STEP --mode batch --dataset DATASET

preprocessed_data/DATASET/val.txt 의 모든 발화를 종합합니다.

합성 된 발화의 말하기 속도는 원하는 지속 시간 비율을 지정하여 제어 할 수 있습니다. 예를 들어, 말하기 속도를 20으로 증가시킬 수 있습니다.

python3 synthesize.py --text "YOUR_DESIRED_TEXT" --restore_step RESTORE_STEP --mode single --dataset DATASET --duration_control 0.8

제어 가능성은 FastSpeech2에서 유래되며 portaspeech의 중요한 관심사는 아닙니다.

지원되는 데이터 세트는입니다

달리다

python3 prepare_align.py --dataset DATASET

일부 준비.

강제 정렬의 경우, 몬트리올 강제 정렬 (MFA)은 발화와 음소 시퀀스 사이의 정렬을 얻는 데 사용됩니다. 데이터 세트에 대한 사전 추출 된 정렬이 여기에 제공됩니다. preprocessed_data/DATASET/TextGrid/ 에서 파일을 압축해야합니다. 또는 혼자서 Aligner를 실행할 수 있습니다.

그 후, 전처리 스크립트를 실행하십시오

python3 preprocess.py --dataset DATASET

모델을 훈련하십시오

python3 train.py --dataset DATASET

유용한 옵션 :

--use_amp 인수를 추가하십시오.CUDA_VISIBLE_DEVICES=<GPU_IDs> 지정하십시오.사용

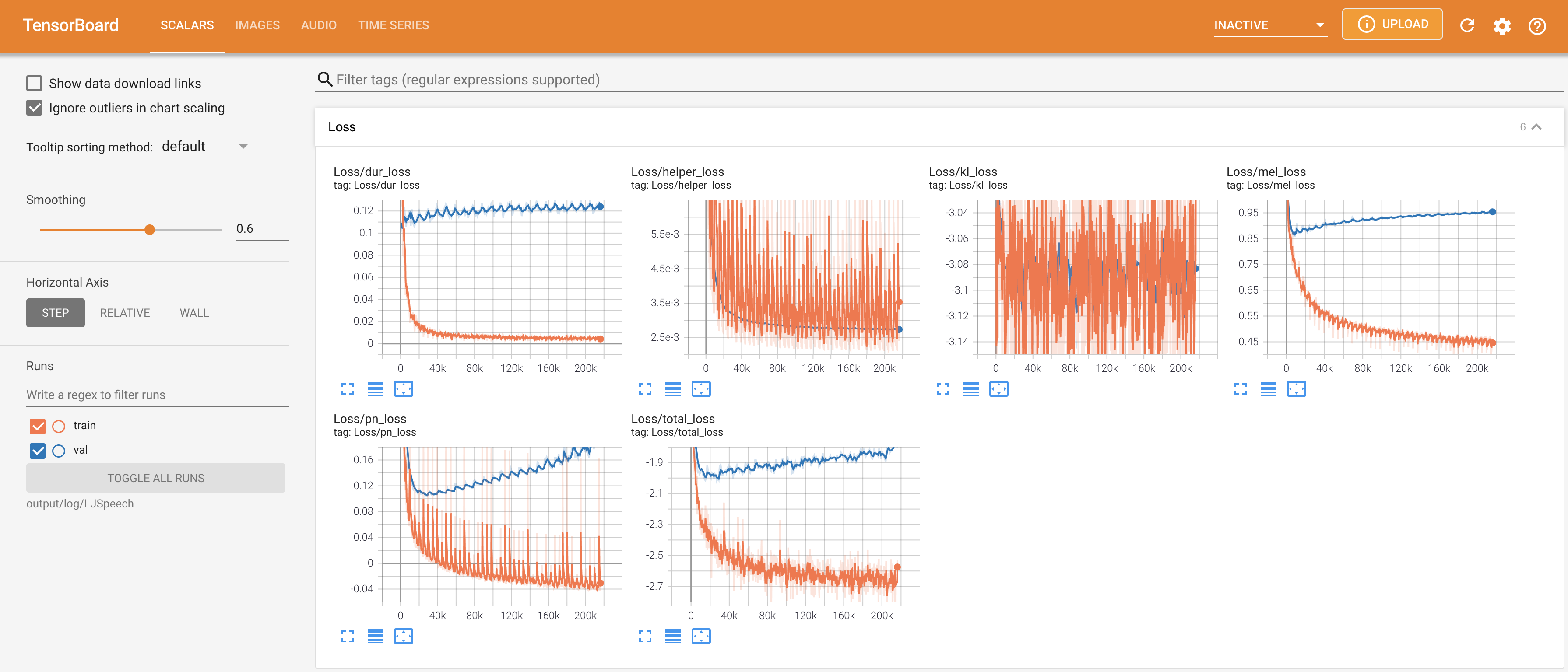

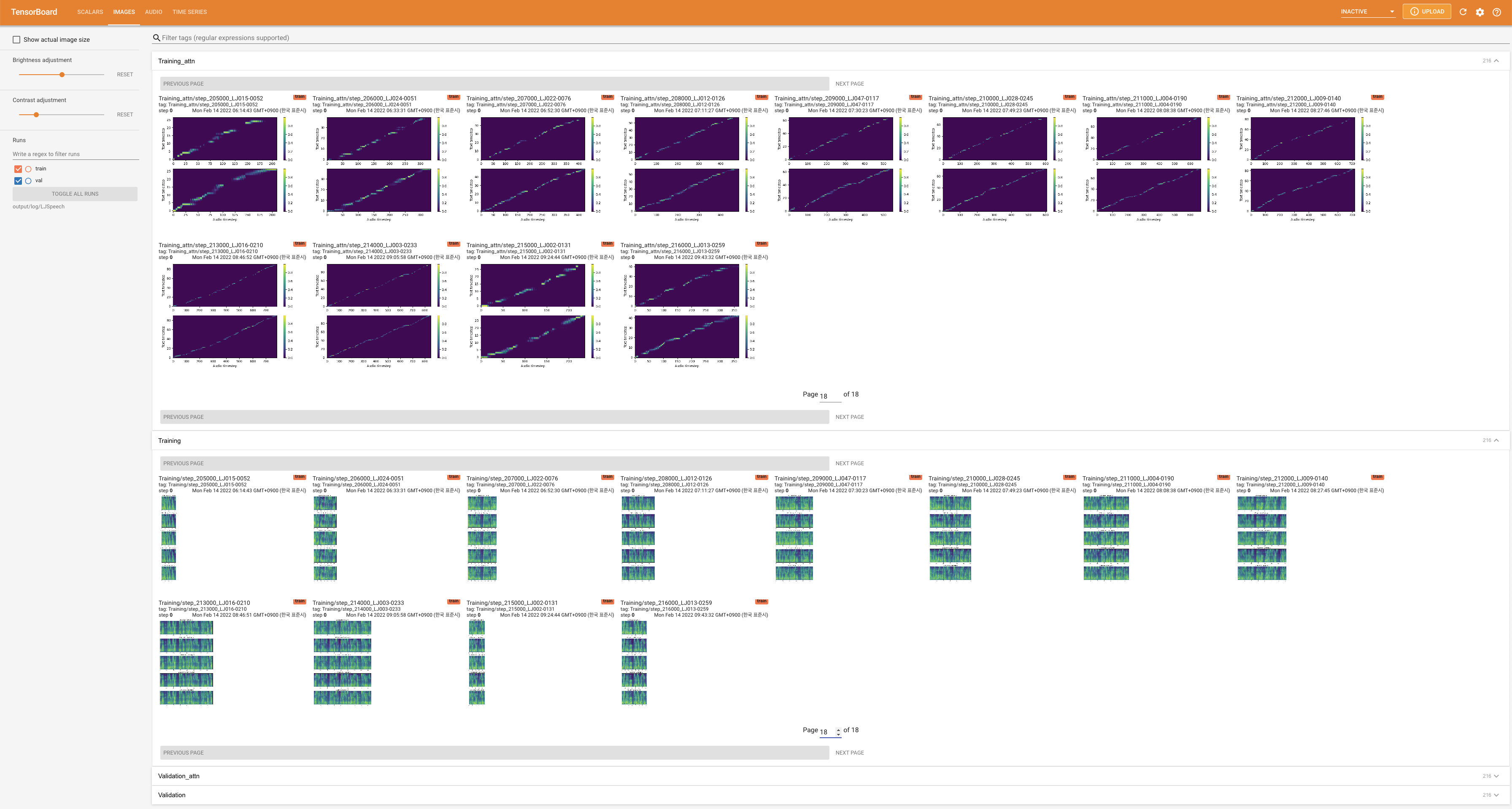

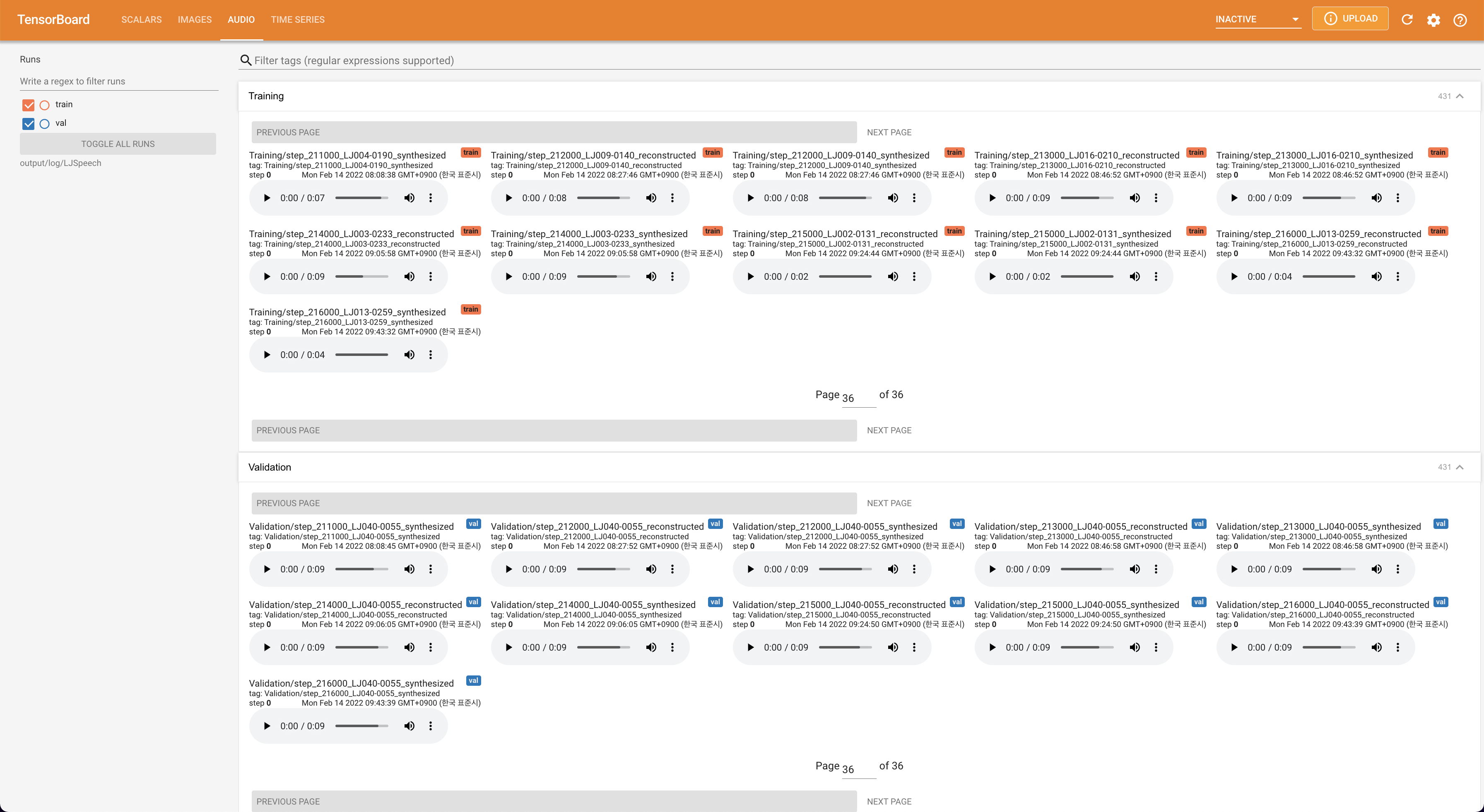

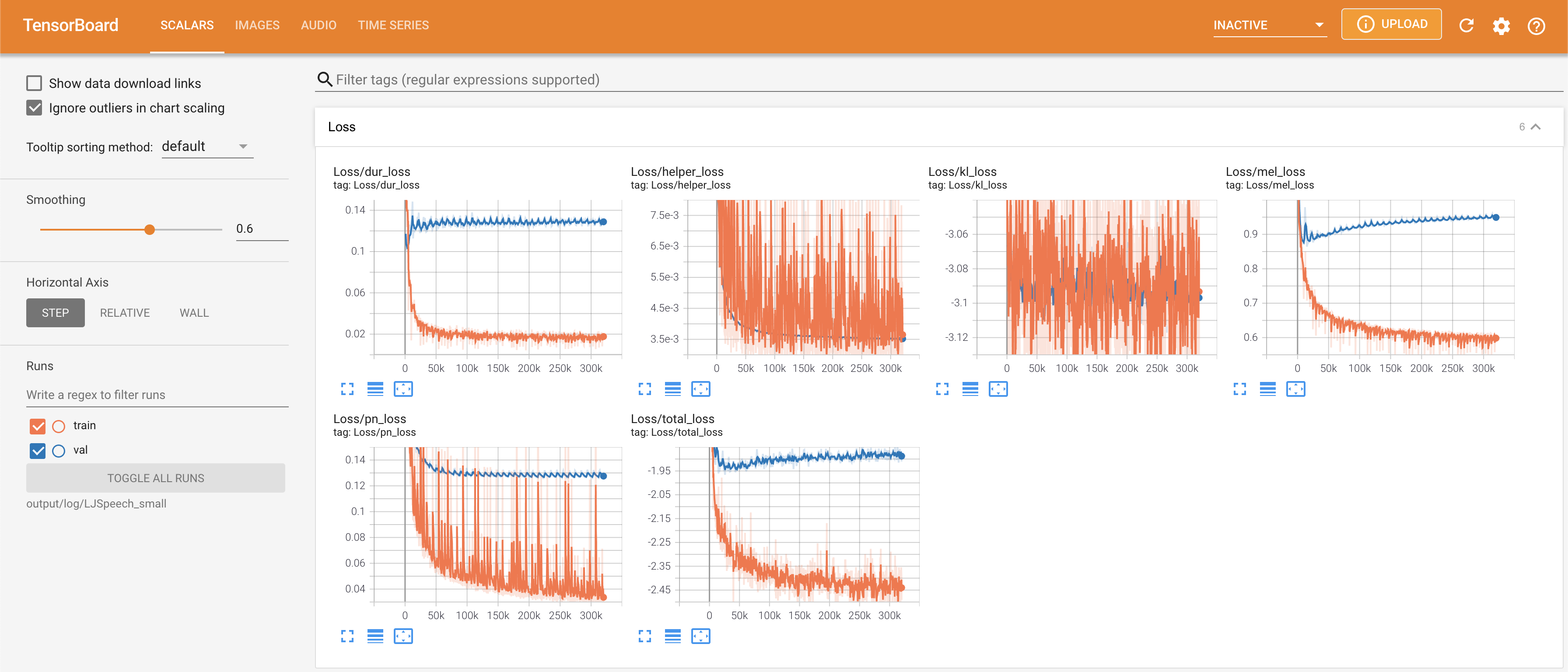

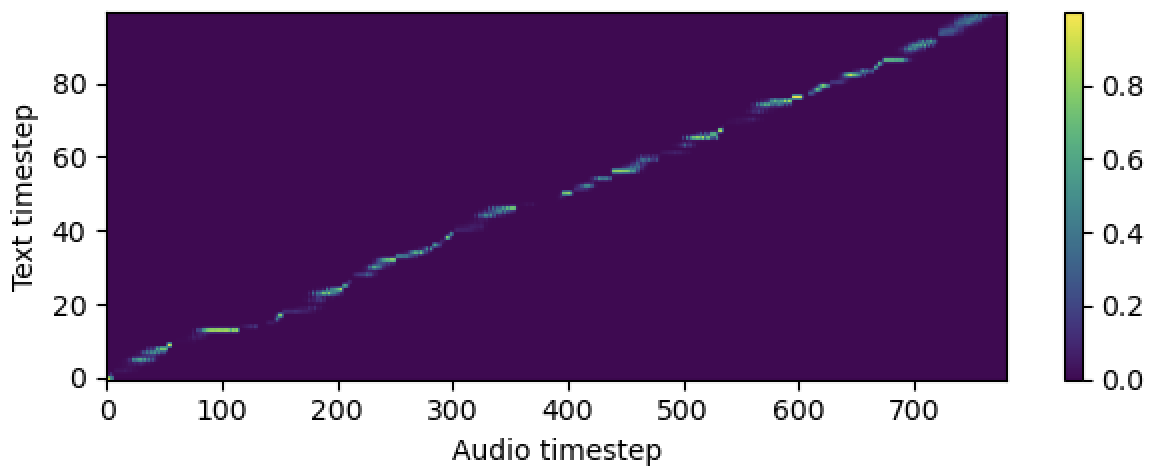

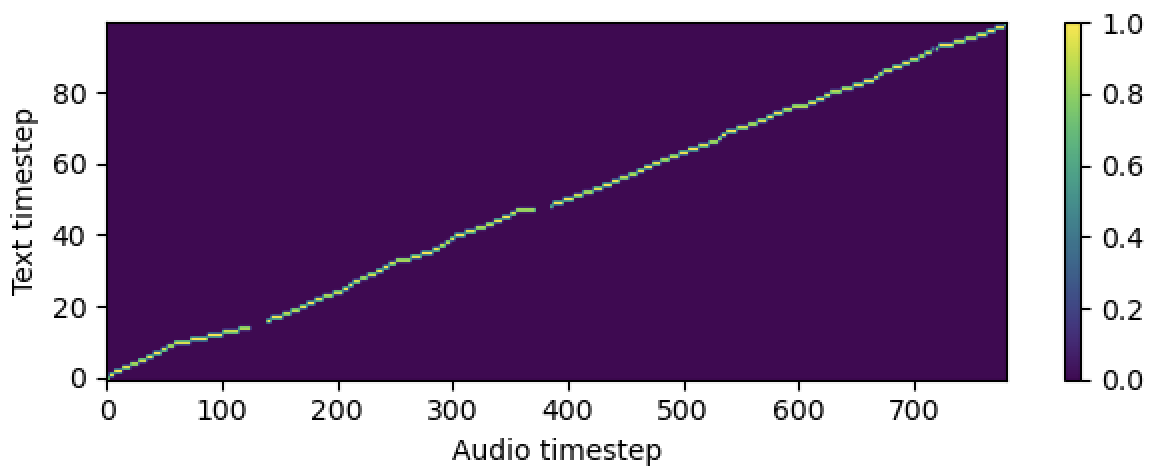

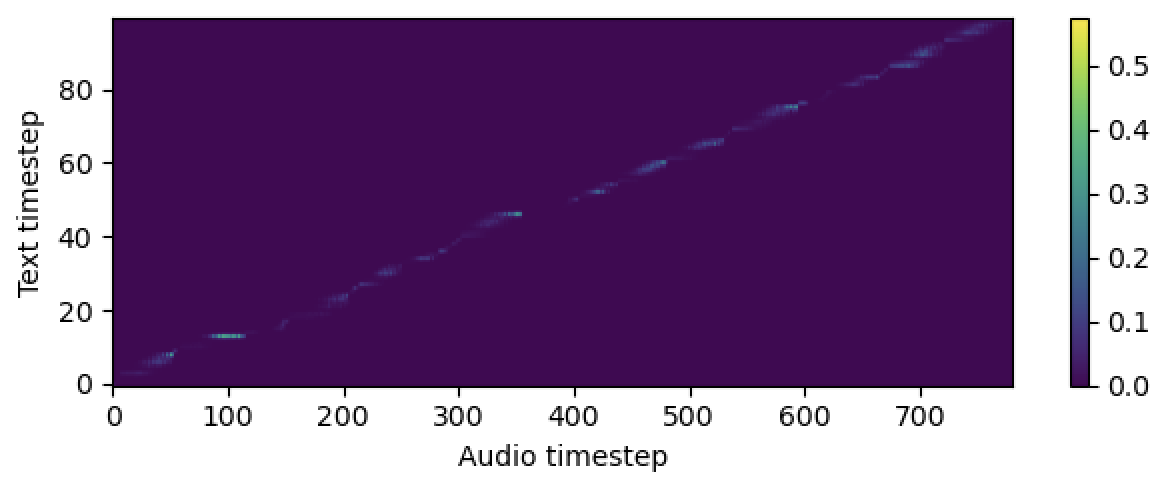

tensorboard --logdir output/log

지역 호스트에서 텐서 보드를 제공합니다. 손실 곡선, 합성 된 멜 스피어 그램 및 오디오가 표시됩니다.

# In the train.yaml

aligner :

helper_type : " dga " # ["dga", "ctc", "none"]

About Section (메인 페이지의 오른쪽 상단)의 "이 저장소 인용"으로이 저장소를 인용하십시오.