ChatLLM Web

v1.0.0

英語 /簡體中文 /日本語

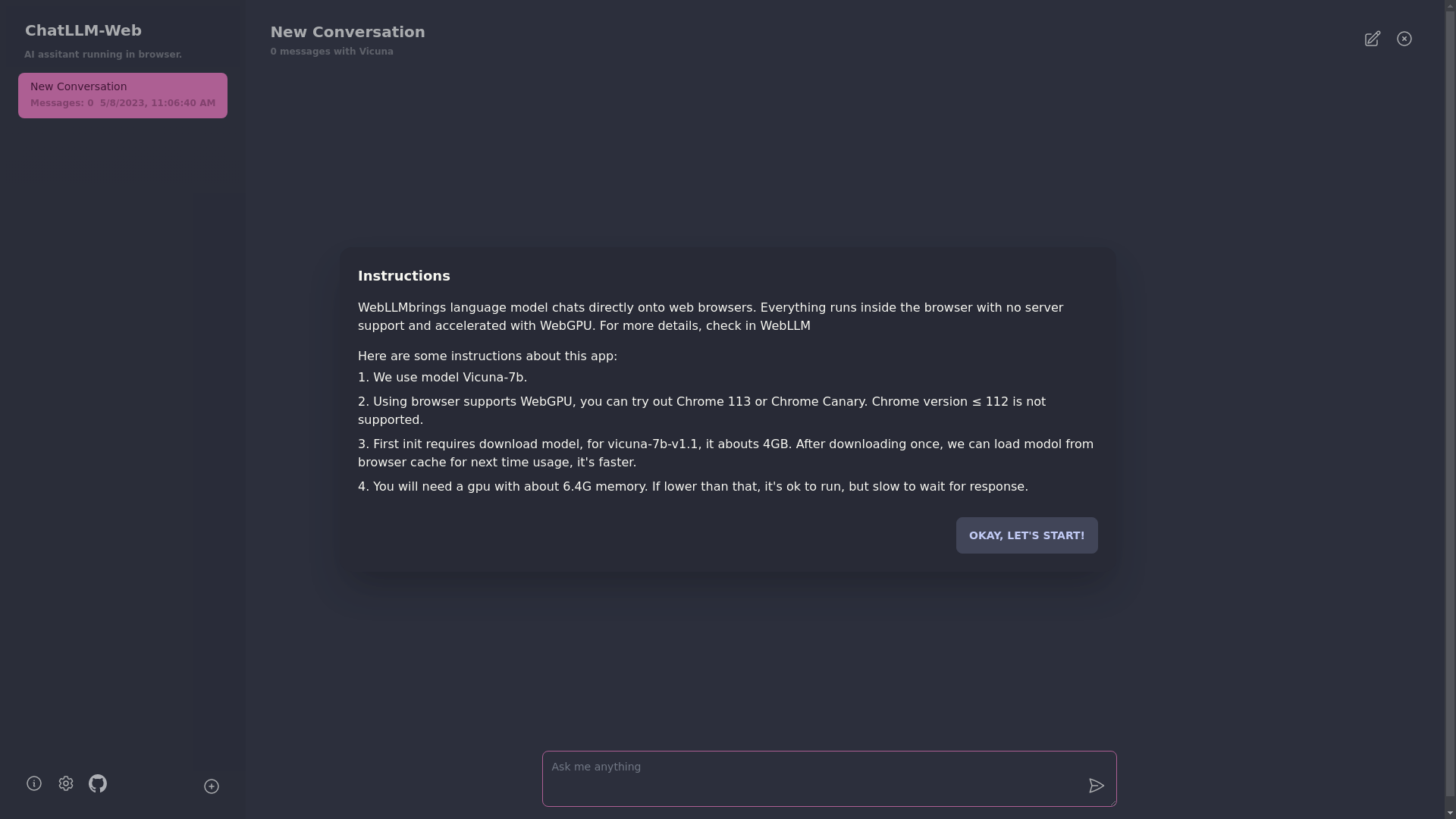

與llm這樣的vicuna聊天,完全,私人且沒有服務器,完全在瀏覽器中與WebGPU聊天。由Web-llm提供支持。

現在嘗試

?一切都在瀏覽器內部運行,沒有服務器支持,並且使用WebGPU加速。

模型在Web工作人員中運行,確保它不會阻止用戶界面並提供無縫體驗。

在不到1分鐘的情況下,通過一鍵在Vercel上易於部署,然後您可以獲得自己的Chatllm Web。

?支持模型緩存,因此您只需要下載一次模型即可。

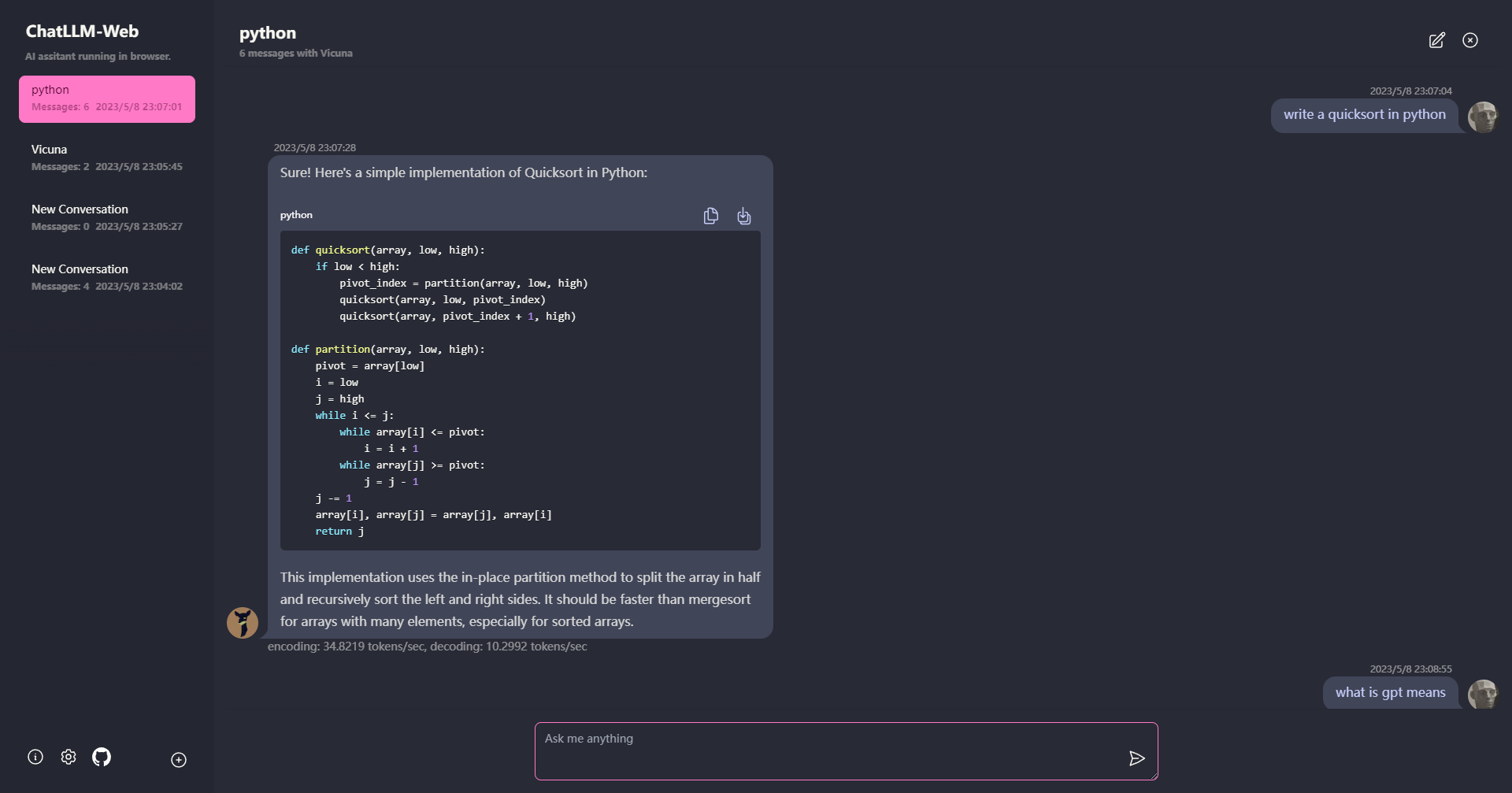

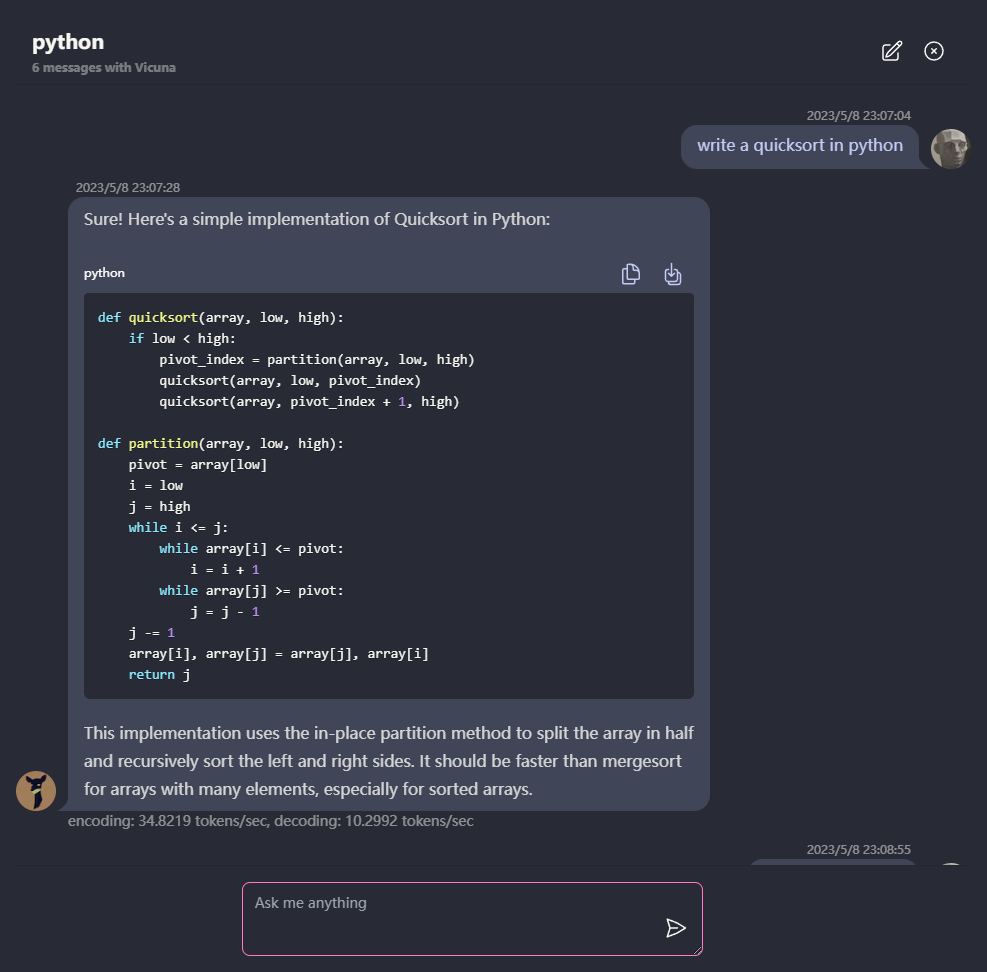

多轉換聊天,所有數據本地存儲在瀏覽器中以尋求隱私。

降價和流響應支持:數學,代碼突出顯示等。

?響應迅速且設計良好的UI,包括黑模式。

PWA支持,下載並完全離線運行。

要使用此應用程序,您需要一個支持WebGPU的瀏覽器,例如Chrome 113或Chrome Canary。不支持Chrome版本≤112。

您將需要一個大約6.4GB內存的GPU。如果您的GPU的內存較少,則該應用程序仍將運行,但是響應時間會較慢。

?第一次使用該應用程序時,您需要下載該模型。對於我們當前正在使用的Vicuna-7b型號,下載尺寸約為4GB。初始下載後,該模型將從瀏覽器緩存中加載,以更快地使用。

有關更多詳細信息,請訪問mlc.ai/web-llm

[✅] LLM:使用Web Worker創建LLM實例並生成答案。

[✅]對話:可用多轉換支持。

[✅] PWA

[] 設定:

git clone https://github.com/Ryan-yang125/ChatLLM-Web.git

cd ChatLLM-Web

npm i

npm run dev

麻省理工學院